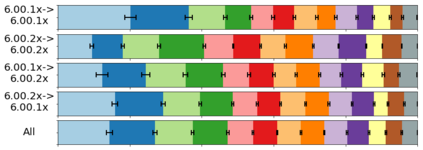

In MOOCs predictive models of student behavior support many aspects of learning design, including instructor feedback and timely intervention. Ongoing (target) courses, when their predictive outcomes are yet unknown, must rely upon models trained from the historical data of previously offered (source) courses. It is possible to transfer such models but they still often predict poorly. One reason is features that inadequately capture predictive attributes common to both courses. We present an automated transductive transfer learning approach that addresses this issue. It relies upon straight-forward problem-agnostic, temporal organization of the clickstream data, where, for each student, for multiple courses, a set of specific MOOC event types is expressed for each time unit. It consists of two alternative transfer methods based on autoencoders: a passive approach using transductive principal component analysis and an active approach by adding a correlation alignment loss term. We investigate the transferability of dropout prediction across similar and dissimilar MOOCs and compare with known methods. Results show improved model transferability and suggest that the methods are capable of automatically learning a feature representation that expresses common predictive characteristics of MOOCs.

翻译:在学生行为预测模型中,学生行为预测模型支持学习设计的许多方面,包括教员反馈和及时干预。当持续(目标)课程的预测结果尚不清楚时,必须依靠以前提供的课程(源)历史数据中经过培训的模型。这种模型有可能转移,但往往预测不力。一个原因是不能充分捕捉两个课程共同的预测属性。我们提出了一个自动传输传输转移学习方法,以解决这个问题。它依靠直接向前的问题、不可知性和时间性组织点击流数据。对于每个学生来说,多门课程中每个时单位都表示一组具体的MOOC事件类型。它由两种基于自动编码器的替代转移方法组成:一种采用被动方法,使用移动式主元件分析,一种积极方法,增加一个相关匹配损失术语。我们调查了类似和不相近的MOOC的辍学预测可转移性,并与已知方法进行比较。结果显示模型可改进的可转移性,并表明这些方法能够自动学习显示MOOC的共同预测特征的特征。