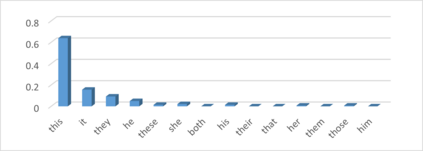

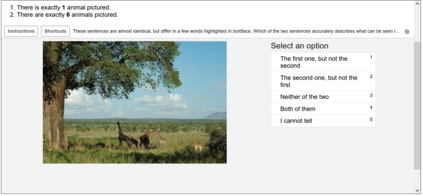

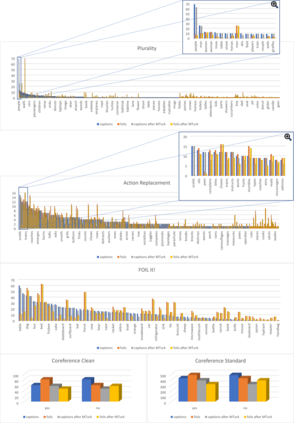

We propose VALSE (Vision And Language Structured Evaluation), a novel benchmark designed for testing general-purpose pretrained vision and language (V&L) models for their visio-linguistic grounding capabilities on specific linguistic phenomena. VALSE offers a suite of six tests covering various linguistic constructs. Solving these requires models to ground linguistic phenomena in the visual modality, allowing more fine-grained evaluations than hitherto possible. We build VALSE using methods that support the construction of valid foils, and report results from evaluating five widely-used V&L models. Our experiments suggest that current models have considerable difficulty addressing most phenomena. Hence, we expect VALSE to serve as an important benchmark to measure future progress of pretrained V&L models from a linguistic perspective, complementing the canonical task-centred V&L evaluations.

翻译:我们提出VALSE(视觉和语言结构评价),这是用于测试通用预先训练的视力和语言(V&L)模型的新颖基准,用于测试其针对特定语言现象的视觉语言基础能力。VALSE提供一套包括各种语言结构的六种测试。解决这些问题需要将语言现象建立在视觉模式的基础之上,允许比以往更细微的评价。我们使用支持构建有效引信的方法建立VALSE,并报告五种广泛使用的V &L模型的评估结果。我们的实验表明,当前模型很难解决大多数现象。因此,我们期望VALSE成为从语言角度衡量预先训练的V &L模型未来进展的重要基准,以补充以教会任务为中心的V &L评估。