题目: The Unstoppable Rise of Computational Linguistics in Deep Learning

摘要:

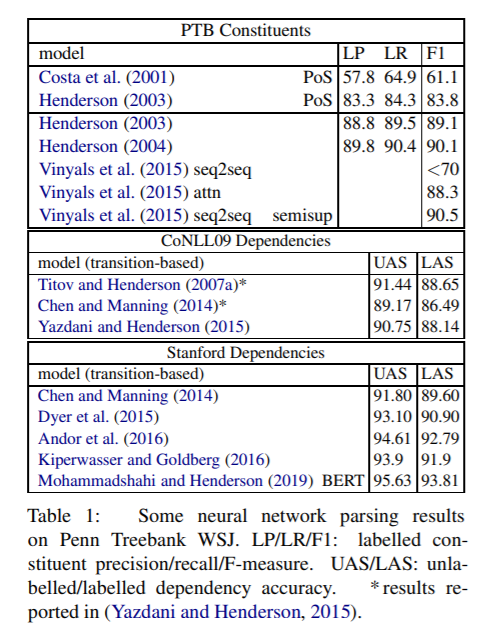

本文追溯了神经网络在自然语言理解任务中的应用历史,并确定了语言的本质对神经网络体系结构发展的关键贡献。重点讨论了基于注意模型中变量绑定及其实例化的重要性,并认为Transformer不是一个序列模型,而是一个诱导结构模型。这一观点导致了对自然语言理解的深度学习架构的研究所面临预测的挑战。

成为VIP会员查看完整内容

相关内容

专知会员服务

48+阅读 · 2019年11月17日