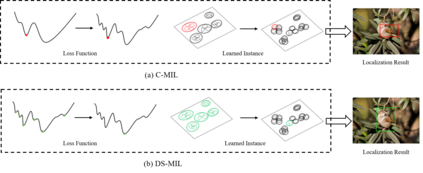

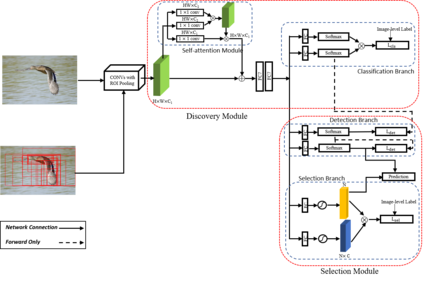

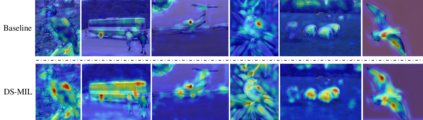

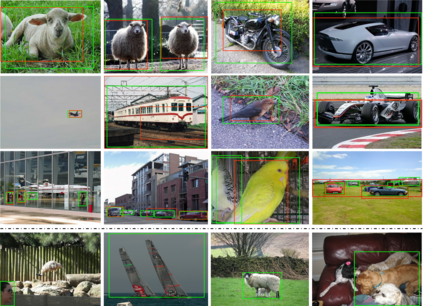

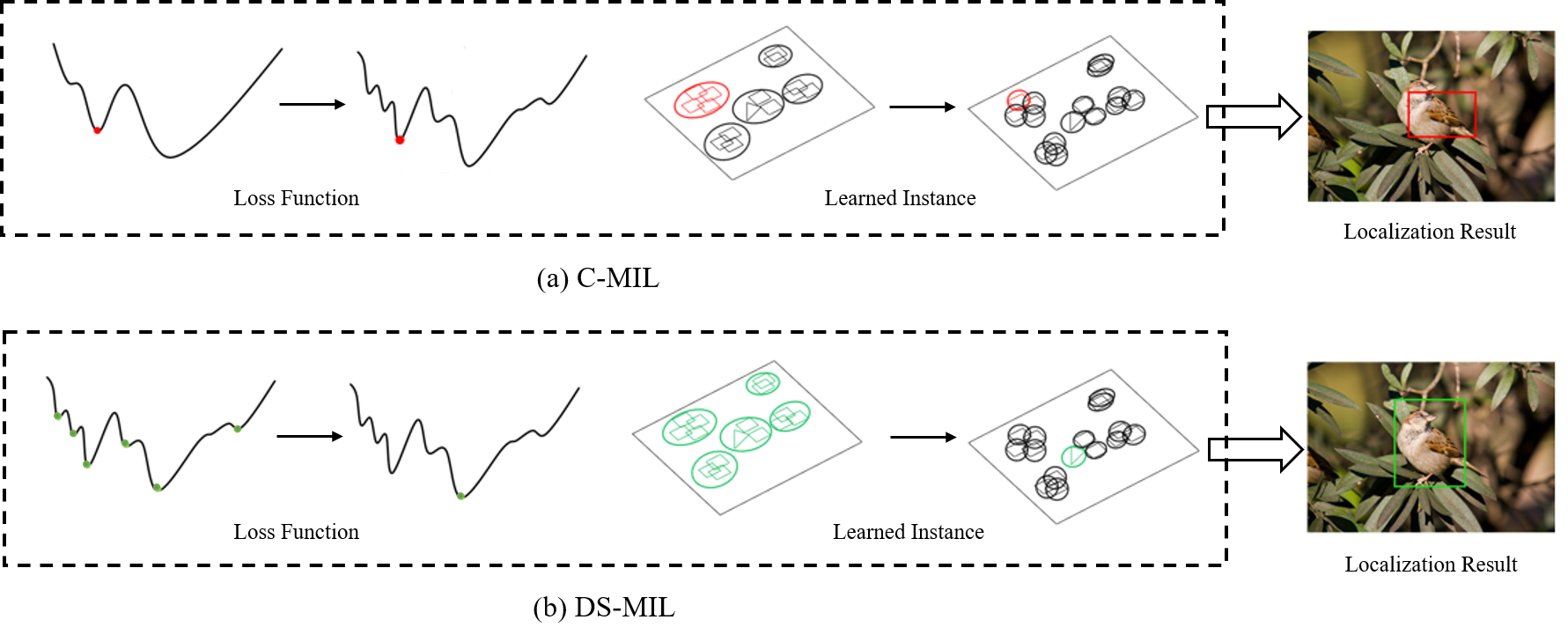

Weakly supervised object detection (WSOD) is a challenging task that requires simultaneously learn object classifiers and estimate object locations under the supervision of image category labels. A major line of WSOD methods roots in multiple instance learning which regards images as bags of instances and selects positive instances from each bag to learn the detector. However, a grand challenge emerges when the detector inclines to converge to discriminative parts of objects rather than the whole objects. In this paper, under the hypothesis that optimal solutions are included in local minima, we propose a discovery-and-selection approach fused with multiple instance learning (DS-MIL), which finds rich local minima and select optimal solution from multiple local minima. To implement DS-MIL, an attention module is proposed so that more context information can be captured by feature maps and more valuable proposals can be collected during training. With proposal candidates, a selection module is proposed to select informative instances for object detector. Experimental results on commonly used benchmarks show that our proposed DS-MIL approach can consistently improve the baselines, reporting state-of-the-art performance.

翻译:微弱监督天体探测(WSOD)是一项具有挑战性的任务,需要同时学习物体分类师,并在图像类别标签的监督下估计物体位置。WSOD方法的主要一行源于多实例学习,将图像视为一袋实例,并从每个包中选择积极的事例来学习探测器。然而,当探测器的内涵汇集到有区别的物体部分而不是整个物体时,就会出现巨大的挑战。在本文件中,根据最佳解决办法包含在当地微型模型的假设,我们建议采用发现和选择方法,与多实例学习(DS-MIL)相结合,发现丰富的本地微型模型,并从多个本地微型模型中选择最佳解决办法。为了实施DS-MIL,建议了一个关注模块,以便更多的背景信息能够通过特征地图收集,并在培训期间收集更有价值的建议。在推荐候选人时,建议选择模块为对象探测器选择信息实例。常用基准的实验结果显示,我们提议的DS-MIL方法可以不断改进基线,报告最新业绩。