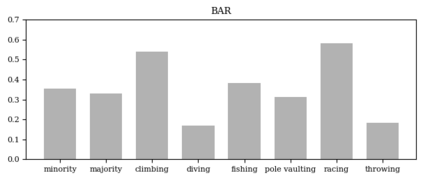

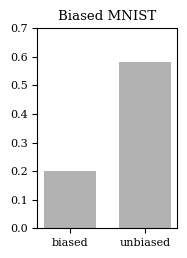

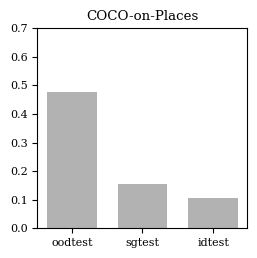

The fairness of a deep neural network is strongly affected by dataset bias and spurious correlations, both of which are usually present in modern feature-rich and complex visual datasets. Due to the difficulty and variability of the task, no single de-biasing method has been universally successful. In particular, implicit methods not requiring explicit knowledge of bias variables are especially relevant for real-world applications. We propose a novel implicit mitigation method using a Bayesian neural network, allowing us to leverage the relationship between epistemic uncertainties and the presence of bias or spurious correlations in a sample. Our proposed posterior estimate sharpening procedure encourages the network to focus on core features that do not contribute to high uncertainties. Experimental results on three benchmark datasets demonstrate that Bayesian networks with sharpened posterior estimates perform comparably to prior existing methods and show potential worthy of further exploration.

翻译:深度神经网络的公平性受到数据集偏差和错误相关性的强烈影响,这两者通常存在于现代功能丰富和复杂的视觉数据集中。由于任务的困难程度和变异性,没有单一的去偏方法能够普遍成功。特别是隐式方法不需要显式知识偏差变量,对于真实世界的应用特别重要。我们提出了一种新颖的隐式缓解方法,使用贝叶斯神经网络,允许我们利用思辨不确定性与样本中偏差或错误相关性之间的关系。我们提出的后验估计锐化程序鼓励网络关注不影响高不确定性的核心特征。在三个基准数据集上的实验结果表明,具有锐化后验估计的贝叶斯网络与先前存在的方法性能相当,并显示出值得进一步探索的潜力。