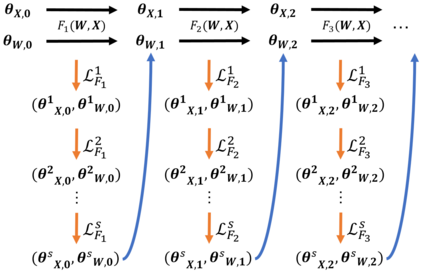

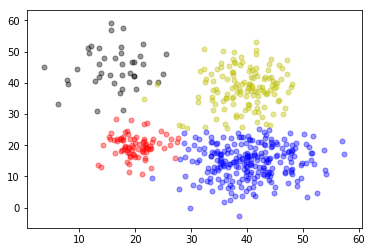

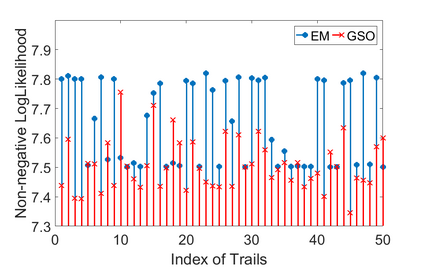

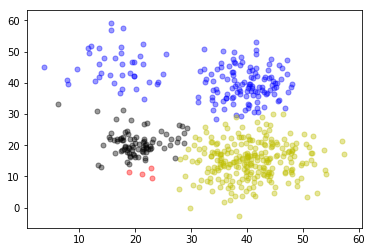

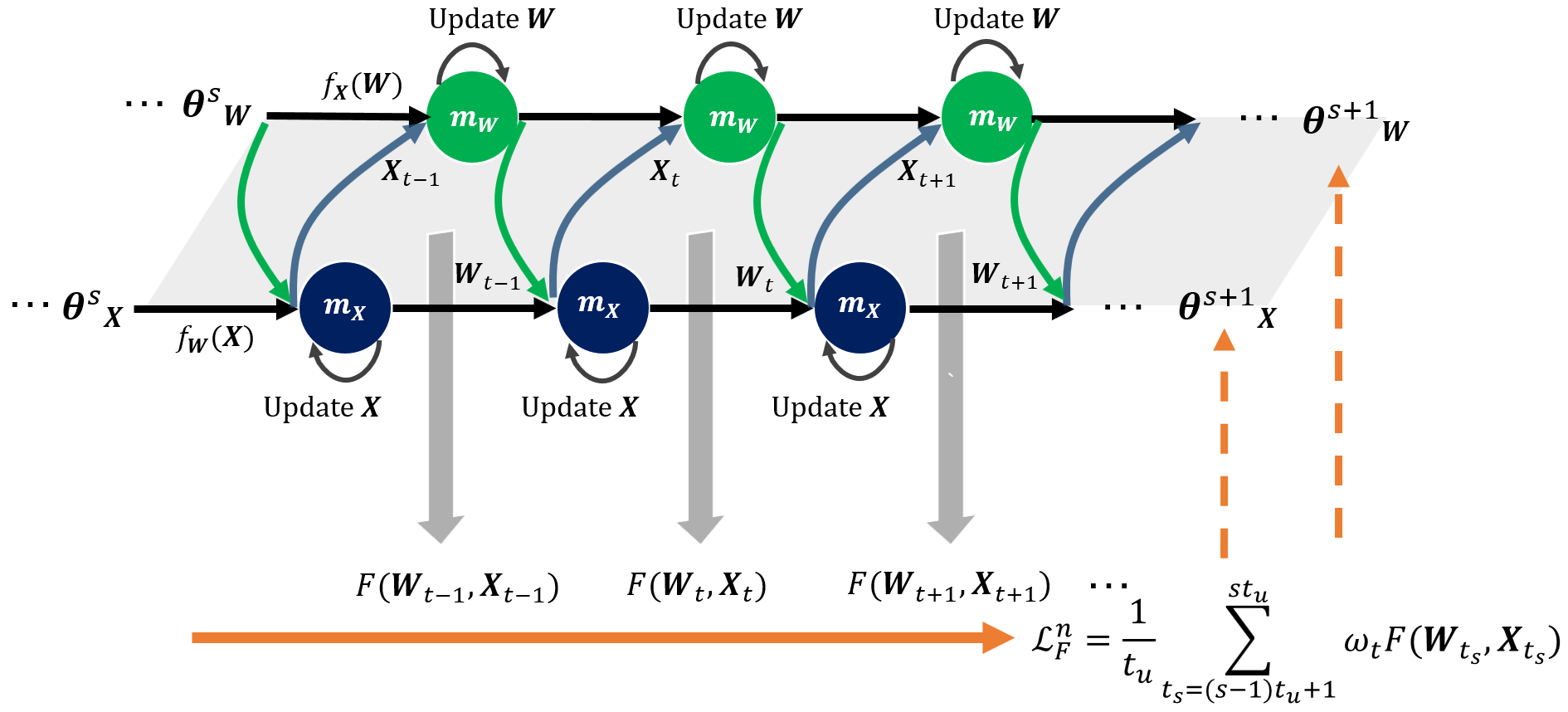

In this paper, we aim to address the problem of solving a non-convex optimization problem over an intersection of multiple variable sets. This kind of problems is typically solved by using an alternating minimization (AM) strategy which splits the overall problem into a set of sub-problems corresponding to each variable, and then iteratively performs minimization over each sub-problem using a fixed updating rule. However, due to the intrinsic non-convexity of the overall problem, the optimization can usually be trapped into bad local minimum even when each sub-problem can be globally optimized at each iteration. To tackle this problem, we propose a meta-learning based Global Scope Optimization (GSO) method. It adaptively generates optimizers for sub-problems via meta-learners and constantly updates these meta-learners with respect to the global loss information of the overall problem. Therefore, the sub-problems are optimized with the objective of minimizing the global loss specifically. We evaluate the proposed model on a number of simulations, including solving bi-linear inverse problems: matrix completion, and non-linear problems: Gaussian mixture models. The experimental results show that our proposed approach outperforms AM-based methods in standard settings, and is able to achieve effective optimization in some challenging cases while other methods would typically fail.

翻译:在本文中,我们的目标是解决在多个变量组交汇的交叉点上解决非软盘优化问题的问题。这类问题通常通过使用一种交替最小化(AM)战略来解决,这种战略将整体问题分为一个与每个变量相对应的子问题组,然后利用固定更新规则对每个子问题进行迭接,对每个子问题进行最小化处理。然而,由于总体问题固有的非复杂性,即使每个子问题可在每处循环中优化全球范围,这种优化通常也会被困在最差的当地最低要求中。为了解决这一问题,我们建议采用基于全球范围范围的元学习优化(AM)战略。这种战略将整体问题分为一个子问题组,将整体问题分成一组,然后利用固定更新规则,对每个子组问题进行最小化;然而,由于总体问题固有的非复杂性,这种优化通常会被困于最差的当地最低要求中。我们评估了若干模拟模型的拟议模型,包括解决双线内在问题。为了解决这个问题,我们提出了一种基于矩阵的全局性优化方法。它通过元化的模型生成一些具有挑战性的模型,而常规的模型则显示我们最差的方法。