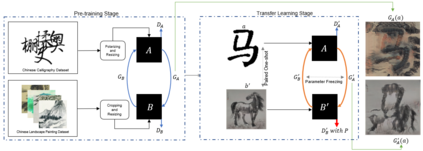

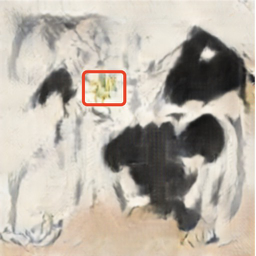

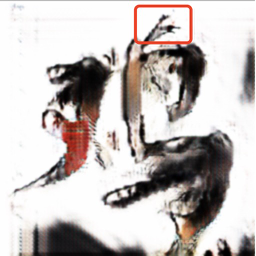

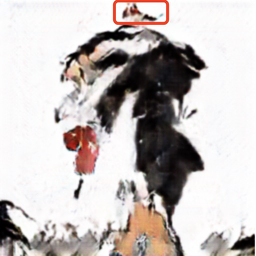

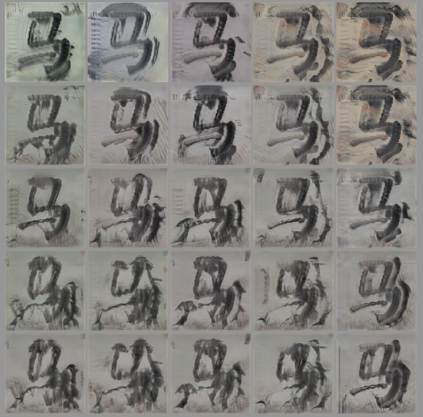

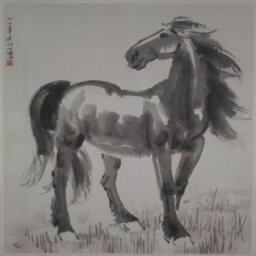

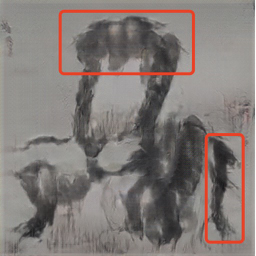

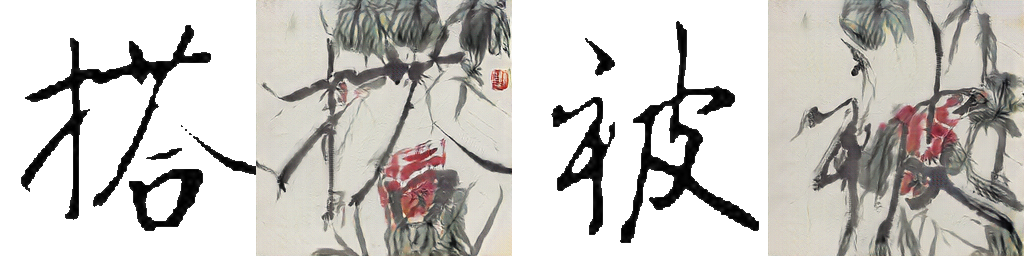

AI-Generated Content (AIGC) has recently gained a surge in popularity, powered by its high efficiency and consistency in production, and its capability of being customized and diversified. The cross-modality nature of the representation learning mechanism in most AIGC technology allows for more freedom and flexibility in exploring new types of art that would be impossible in the past. Inspired by the pictogram subset of Chinese characters, we proposed PaCaNet, a CycleGAN-based pipeline for producing novel artworks that fuse two different art types, traditional Chinese painting and calligraphy. In an effort to produce stable and diversified output, we adopted three main technical innovations: 1. Using one-shot learning to increase the creativity of pre-trained models and diversify the content of the fused images. 2. Controlling the preference over generated Chinese calligraphy by freezing randomly sampled parameters in pre-trained models. 3. Using a regularization method to encourage the models to produce images similar to Chinese paintings. Furthermore, we conducted a systematic study to explore the performance of PaCaNet in diversifying fused Chinese painting and calligraphy, which showed satisfying results. In conclusion, we provide a new direction of creating arts by fusing the visual information in paintings and the stroke features in Chinese calligraphy. Our approach creates a unique aesthetic experience rooted in the origination of Chinese hieroglyph characters. It is also a unique opportunity to delve deeper into traditional artwork and, in doing so, to create a meaningful impact on preserving and revitalizing traditional heritage.

翻译:AI-General Enterm(AIGC)最近由于生产效率高、一致性高,以及具有定制化和多样化能力,而赢得了高度受欢迎程度。在AIGC大多数技术中,代表性学习机制的交叉模式性质使得探索过去不可能的新型艺术更加自由和灵活。在中国字符的象形图子子的启发下,我们建议PaCaNet,一个以循环GAN为基础的管道,用于制作新型艺术作品,结合两种不同的传统艺术类型,传统的中国绘画和书法。为了产生稳定和多样化的产出,我们采用了三种主要技术创新:1. 利用一张照片学习来增加预先培训的模型的创造力,并使集成图像的内容多样化。2. 控制对中国造型书的偏好,冻结了事先培训模型中随机抽样的参数。3. 利用正规化方法鼓励模型制作与中国绘画相似的图像。此外,我们进行了一项系统的研究,探索PaaNet在使中国成型画和书法多样化方面的独特性表现。这显示了令人满意的成果。在中国成型图中,我们从历史中树立了一种独特的形象和刻画,这是中国历史中的一种新的方向。