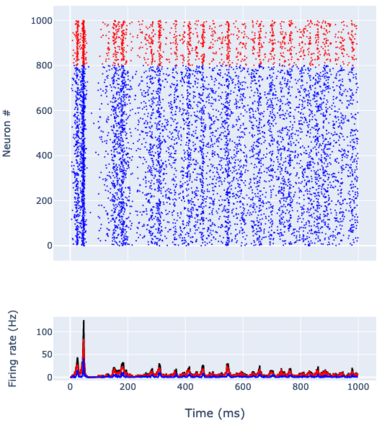

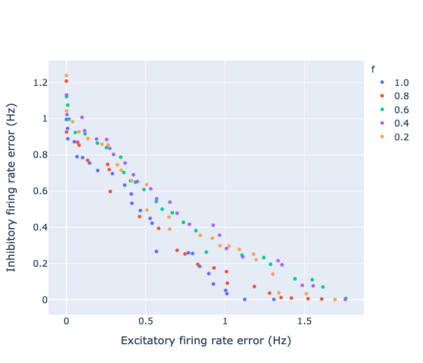

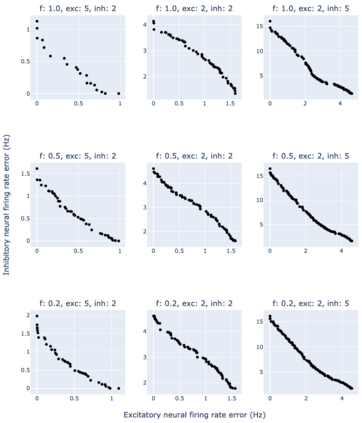

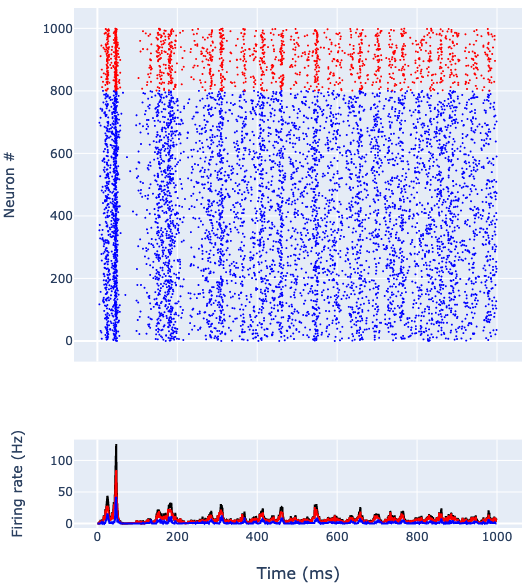

Spiking neural networks (SNNs) communicate through the all-or-none spiking activity of neurons. However, fitting the large number of SNN model parameters to observed neural activity patterns, for example, in biological experiments, remains a challenge. Previous work using genetic algorithm (GA) optimisation on a specific efficient SNN model, using the Izhikevich neuronal model, was limited to a single parameter and objective. This work applied a version of GA, called non-dominated sorting GA (NSGA-III), to demonstrate the feasibility of performing multi-objective optimisation on the same SNN, focusing on searching network connectivity parameters to achieve target firing rates of excitatory and inhibitory neuronal types, including across different network connectivity sparsity. We showed that NSGA-III could readily optimise for various firing rates. Notably, when the excitatory neural firing rates were higher than or equal to that of inhibitory neurons, the errors were small. Moreover, when connectivity sparsity was considered as a parameter to be optimised, the optimal solutions required sparse network connectivity. We also found that for excitatory neural firing rates lower than that of inhibitory neurons, the errors were generally larger. Overall, we have successfully demonstrated the feasibility of implementing multi-objective GA optimisation on network parameters of recurrent and sparse SNN.

翻译:通过神经神经元的全天或全天神经网络(SNNs)进行交流。然而,将大量SNN模型参数与观察到的神经活动模式(例如生物实验中的神经活动模式)相匹配仍然是一个挑战。以前使用Izhikevich神经模型对特定高效 SNN 模型进行基因算法(GA)优化的工作仅限于一个单一参数和目标。这项工作应用了一个名为“非主分类GA(NSGA-III)”的GA版本,以展示在同一SNN上执行多目标优化参数的可行性,重点是搜索网络连接参数,以达到刺激性和抑制性神经活动类型的目标发射率,包括不同网络连接度之间的目标发射率。我们显示,NSGA-III对特定高效的 SNNNNN模式的优化,仅限于一个单一参数和目标。值得注意的是,当Excicical 神经神经系统的发射率高于或等于抑制性神经元时,误差是很小的。此外,当连接性连接度被认为是一个优化的参数时,最理想的网络连通性解决方案需要隐藏的连通性网络连接。我们还发现,在较慢的Sental-stal-stal-stal-toimal-toimation rotial