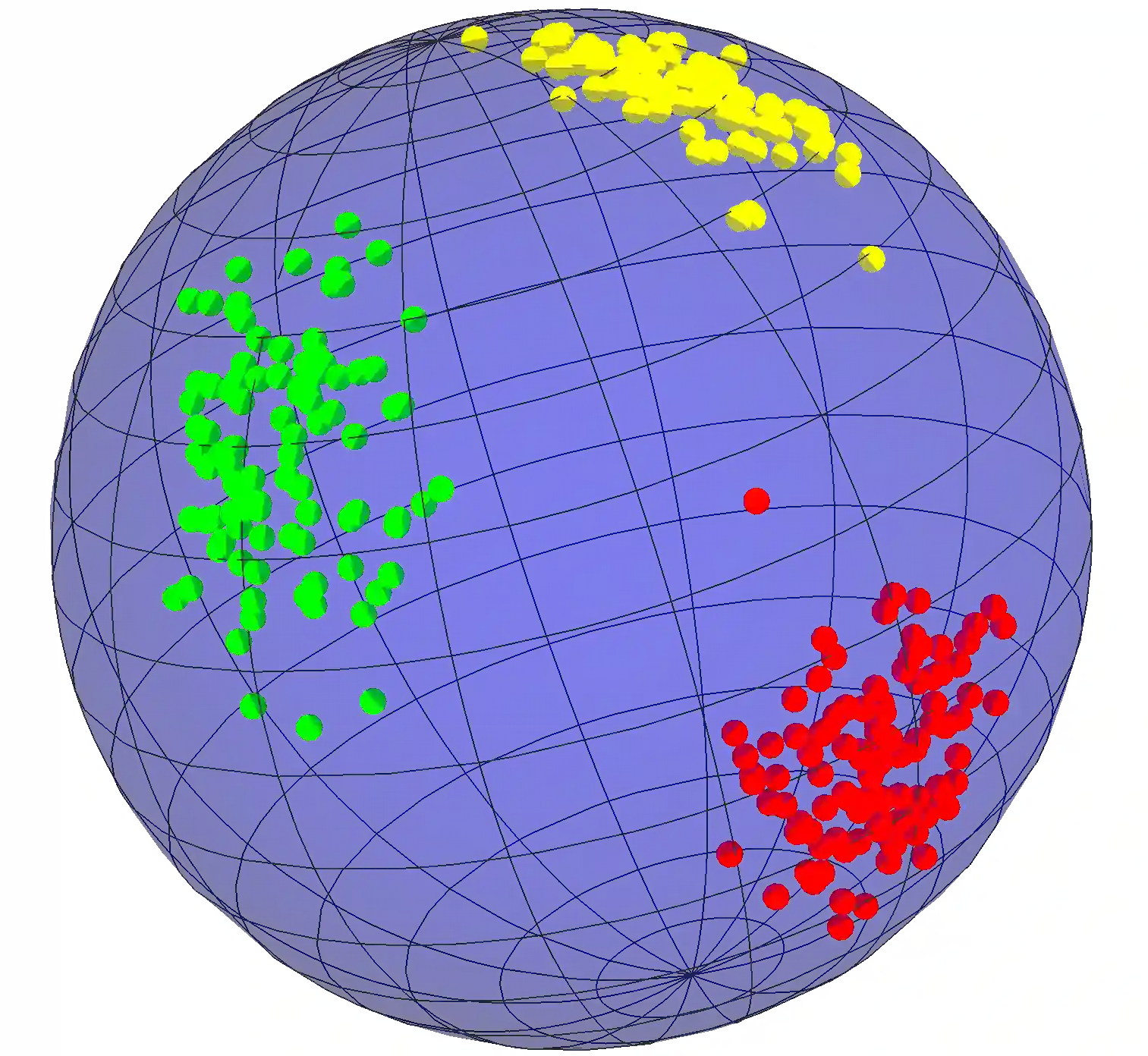

Quantum classification and hypothesis testing are two tightly related subjects, the main difference being that the former is data driven: how to assign to quantum states $\rho(x)$ the corresponding class $c$ (or hypothesis) is learnt from examples during training, where $x$ can be either tunable experimental parameters or classical data "embedded" into quantum states. Does the model generalize? This is the main question in any data-driven strategy, namely the ability to predict the correct class even of previously unseen states. Here we establish a link between quantum machine learning classification and quantum hypothesis testing (state and channel discrimination) and then show that the accuracy and generalization capability of quantum classifiers depend on the (R\'enyi) mutual informations $I(C{:}Q)$ and $I_2(X{:}Q)$ between the quantum state space $Q$ and the classical parameter space $X$ or class space $C$. Based on the above characterization, we then show how different properties of $Q$ affect classification accuracy and generalization, such as the dimension of the Hilbert space, the amount of noise, and the amount of neglected information from $X$ via, e.g., pooling layers. Moreover, we introduce a quantum version of the Information Bottleneck principle that allows us to explore the various tradeoffs between accuracy and generalization. Finally, in order to check our theoretical predictions, we study the classification of the quantum phases of an Ising spin chain, and we propose the Variational Quantum Information Bottleneck (VQIB) method to optimize quantum embeddings of classical data to favor generalization.

翻译:量子分类和假设测试是两个密切相关的主题,主要区别在于前者是数据驱动的:如何向量子国分配 $\ rho(x)$ 相应级的美元(或假设) 从培训中从实例中学习, 美元可以是可附带试验的参数, 也可以是典型的数据“ 嵌入” 量子国。 模型是否概括? 这是任何数据驱动战略中的主要问题, 即是否有能力预测正确的等级, 即使是先前不为人知的国家 。 我们在这里建立了量子机器学习分类和量子假设测试( 状态和频道歧视) 之间的联系, 然后表明量子分类的精确性和总体水平取决于( enyi) 的相互信息 $( C{ : { } ) 美元和 美元 ( =) 经典数据 Q( Q) 和 基质子 的精确度, 我们从一般交易到 水平 水平 水平 数据, 我们从一般交易到 水平 水平 水平 水平, 我们通过 水平 水平, 我们通过 水平 水平 水平, 我们通过 水平 将 数据 水平 开始 水平 水平 水平, 我们 水平 水平 开始 水平 数据 水平 水平 水平, 我们, 我们 水平 水平 开始 水平 水平 水平 水平, 我们 水平 水平 水平 水平, 我们, 我们 水平 水平 水平 水平 水平, 我们,, 我们, 水平 水平 水平, 我们, 我们,,,, 水平 水平 水平 水平, 我们,, 我们,, 开始 水平 开始, 开始 水平 水平 水平, 我们, 我们, 我们, 我们,, 我们, 水平 水平, 我们, 我们,, 我们,,,,, 水平 水平, 水平 水平 水平 水平 水平 水平 水平 水平, 水平, 我们, 我们, 我们,,,,, 我们,,,, 我们,, 水平 水平 水平 水平 水平 水平 水平