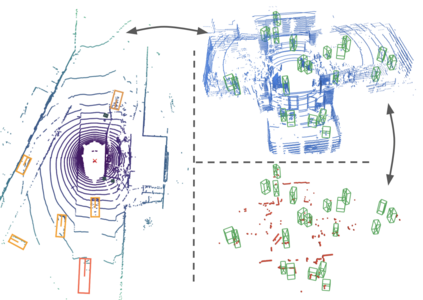

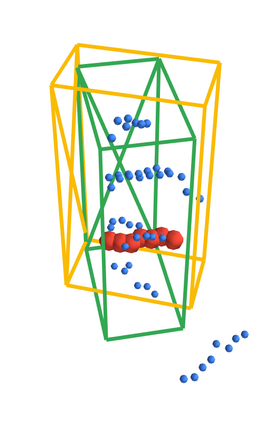

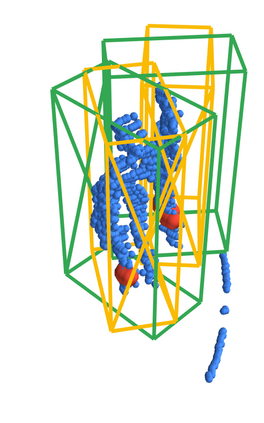

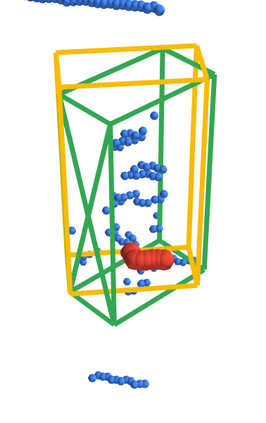

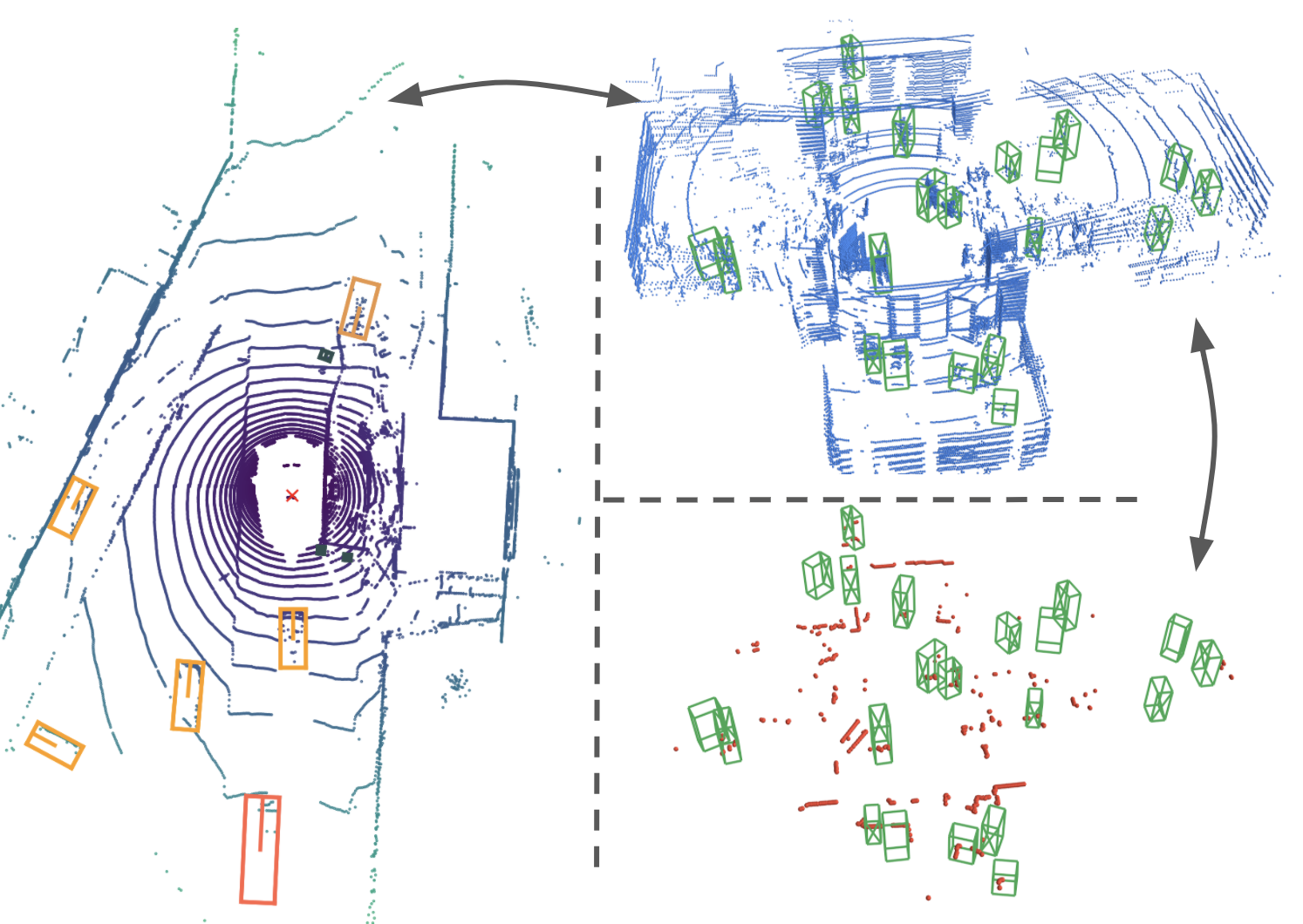

Person detection is a crucial task for mobile robots navigating in human-populated environments and LiDAR sensors are promising for this task, given their accurate depth measurements and large field of view. This paper studies existing LiDAR-based person detectors with a particular focus on mobile robot scenarios (e.g. service robot or social robot), where persons are observed more frequently and in much closer ranges, compared to the driving scenarios. We conduct a series of experiments, using the recently released JackRabbot dataset and the state-of-the-art detectors based on 3D or 2D LiDAR sensors (CenterPoint and DR-SPAAM respectively). These experiments revolve around the domain gap between driving and mobile robot scenarios, as well as the modality gap between 3D and 2D LiDAR sensors. For the domain gap, we aim to understand if detectors pretrained on driving datasets can achieve good performance on the mobile robot scenarios, for which there are currently no trained models readily available. For the modality gap, we compare detectors that use 3D or 2D LiDAR, from various aspects, including performance, runtime, localization accuracy, robustness to range and crowdedness. The results from our experiments provide practical insights into LiDAR-based person detection and facilitate informed decisions for relevant mobile robot designs and applications.

翻译:对于在人类居住环境中航行的移动机器人来说,探测人员是一项关键任务,而LiDAR传感器由于其精确的深度测量和广观视野,对这项任务很有希望。本文研究现有的LIDAR人探测器,特别侧重于移动机器人情景(如服务机器人或社交机器人),与驱动情景相比,在移动机器人情景中,人们的观察频率更高,范围更近得多。我们利用最近公布的JackRabbot数据集和基于3D或2D LiDAR传感器(分别为CenterPoint和DR-SPAM)的先进探测器进行了一系列实验。这些实验围绕驾驶和移动机器人情景之间的领域差距以及3D和2DLIDAR传感器之间的模式差距进行。关于域间隔,我们的目标是了解对驾驶数据集进行预先训练的探测器能否在移动机器人情景上取得良好的性能,而目前还没有经过训练的模型。关于模式差距,我们比较了使用3D或2DLIDAR探测器的探测器,从不同方面,包括性能、实时、本地化精确度、稳健度和移动智能设计范围,为我们相关的机器人探测和密集设计提供了结果。