【泡泡图灵智库】评估视觉惯性里程计的TUM VI基准(IROS)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:The TUM VI Benchmark for Evaluating Visual-Inertial Odometry

作者:David Schubert, Thore Goll, Nikolaus Demmel, Vladyslav Usenko, Jorg Stuckler and Daniel Cremers

来源:IROS 2018

编译:夏友杰

审核:李鑫

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——评估视觉惯性里程计的TUM VI基准,该文章发表于IROS 2018。

视觉里程计和SLAM方法在诸如增强现实和机器人等领域有广泛的应用。通过惯性测量对视觉传感器的补充可以极大地提高跟踪精度和鲁棒性,也因此催生各界开发视觉惯性里程计算法的浓厚兴趣。本文提出了TUM VI基准,这是一个全新的用于评估视觉惯性里程计的数据集,其中包括不同场景下的多样化的数据序列。该数据集提供的相机图像特点如下,分辨率为1024x1024,频率为20Hz,具备高动态范围而且经过光度标定。一个IMU单元以200Hz频率测量三轴线性加速度和三轴角速度,而IMU与相机在硬件上是时钟同步的。针对轨迹评估,TUM VI数据集还提供准确的姿态真值,其来自于高频率(120Hz)的运动捕捉系统,并且在数据序列的开头和结尾,相机和IMU的数据已经经过准确对齐。完整的数据集包含原始数据和经过标定的数据,已经全部公开。本文还在此数据集上评估了当前最前沿的视觉惯性里程计方法。

主要贡献

本文提出了TUM VI基准,这是一个全新的数据集,包括不同场景下的多样化的数据序列。其中,相机图像分辨率为1024x1024,频率为20Hz,16位色彩深度,已知曝光时间,线性响应函数和渐晕标定。一个IMU单元提供200Hz频率的三轴线性加速度和三轴角速度测量,而且IMU与相机在硬件上是时钟同步的。通过高频率(120Hz)的运动捕捉系统记录精确位姿真值。通过标定时间偏移和相对变换来精确对齐传感器测量值与真值。另外,在数据集上评估了当前最前沿视觉惯性算法。完整数据集包含原始数据,标定后数据。完整数据集见:https://vision.in.tum.de/data/datasets/visual-inertial-dataset。

数据集介绍

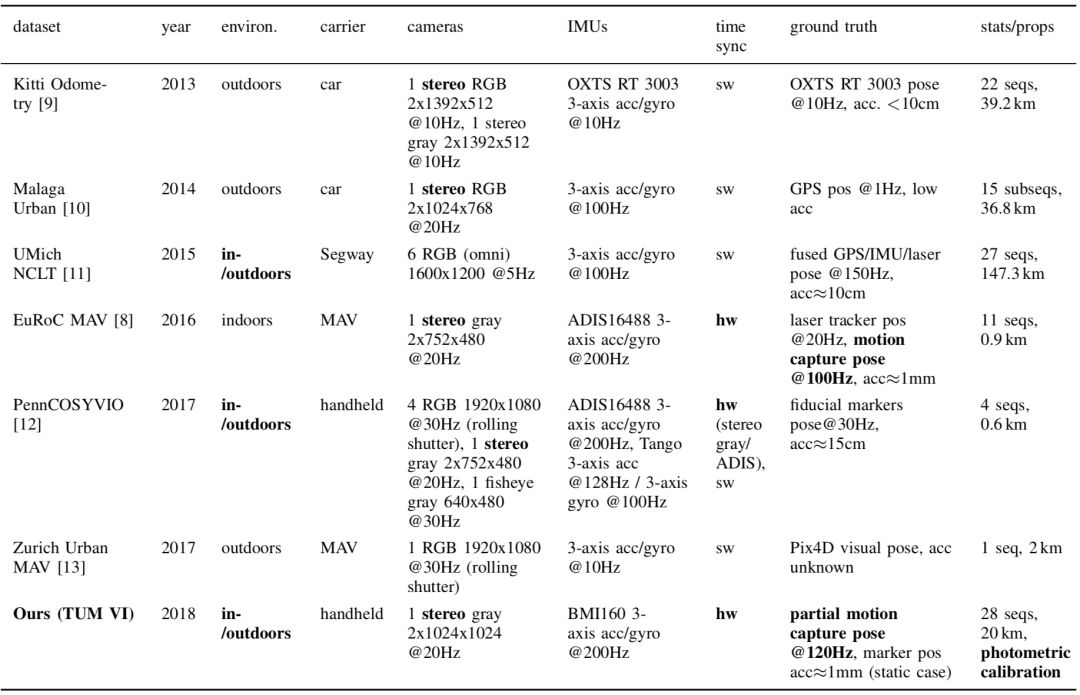

表1 包含图像与IMU的数据集比较

1、视觉惯性里程计和SLAM数据集

一些近期的数据集与TUM VI数据集类似,也是面向评估视觉惯性里程计和SLAM方法,经过同步的视觉数据与IMU测量值。EuRoC MAV数据集包含11个室内数据序列,由一个无人飞行器上的双目视觉惯性传感器Skybotix采集得到。准确的姿态真值(误差大约1毫米)由一个激光跟踪器或运动捕捉系统记录得到。与本文基准相比,EuRoC数据集中的序列时间上更短,并且差异性不够大,因为它只包括了一个机器厂房和一个实验室环境。但是EuRoC数据集不包括对评估直接法至关重要的光度标定。针对视觉惯性SLAM的还有PennCOSYVIO数据集和Zurich Urban MAV数据集,然而它们也没有像TUM VI一样包含光度标定,准确姿态真值或者IMU和相机之间的时间同步。

2、TUM VI数据集

2.1、数据序列

除了评估序列之外,本数据集还提供标定数据以供用户自行标定。所有数据序列可分为以下几类:

calib-cam:用于标定相机内参和双目相机间的外参

calib-imu:用于相机-IMU标定,得到它们之间的相对位姿

calib-vignette:用于渐晕标定

imu-static:纯IMU数据,用于估计噪声和随机游走参数(111个小时保持静止)

room:完全在MoCap室内的数据序列,完整轨迹均有对应真值

corridor:对应于相机沿走廊运动和进出办公室的序列

magistrale:对应于沿着某大学建筑的中心礼堂附近行走的序列

outdoors:对应大学校园内大范围行走的序列

slides:对应于沿着某大学建筑的中心礼堂内行走的序列,包括一小段没有视觉特征的封闭空间中滑动的数据

2.2、数据格式

主要包含ROS Bag文件和标定文件两类。每一个数据序列对应三个ROS Bag文件,一个原始数据包和两个不同分辨率的标定后数据包。

主要结果

1、 评估标准

为了评估跟踪算法在本数据集上的性能,这里采用不同的评估标准:绝对轨迹误差(absolute trajectory error,ATE)和相对姿态误差(relative pose error,RPE)。

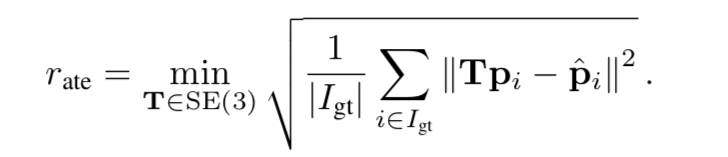

1.1、绝对轨迹误差

绝对轨迹误差是3D位置真值{\hat p}_i和跟踪位置p_i(经过最优SE(3)位姿T对齐后)误差和的均方根,具体定义如下:

其中,I_{gt}表示有对应真值的跟踪位姿的序号。

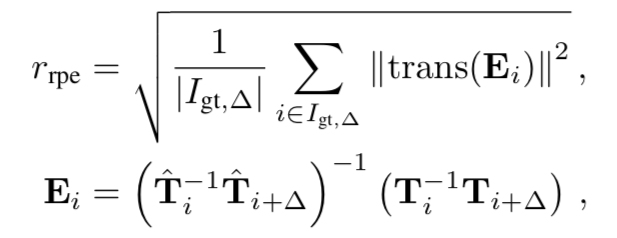

1.2、相对位姿误差

对于没有全局优化的视觉里程计而言,另外一种合理的定量标准就是相对位姿误差,具体定义如下:

其中,trans(.)表示从一个位姿中取出3D平移元素。该误差衡量了再一个很小的时间间隔\Delta内,位姿改变的准确程度。

2、评估结果

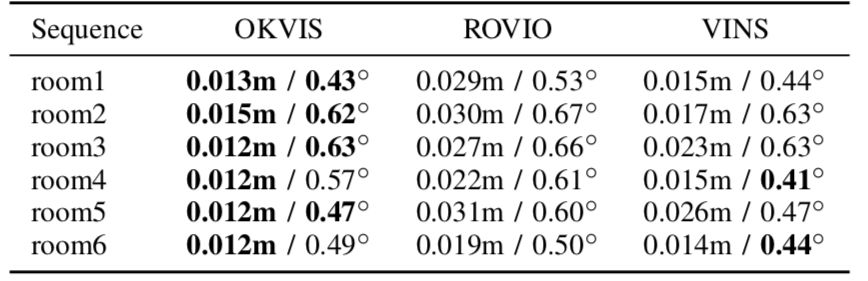

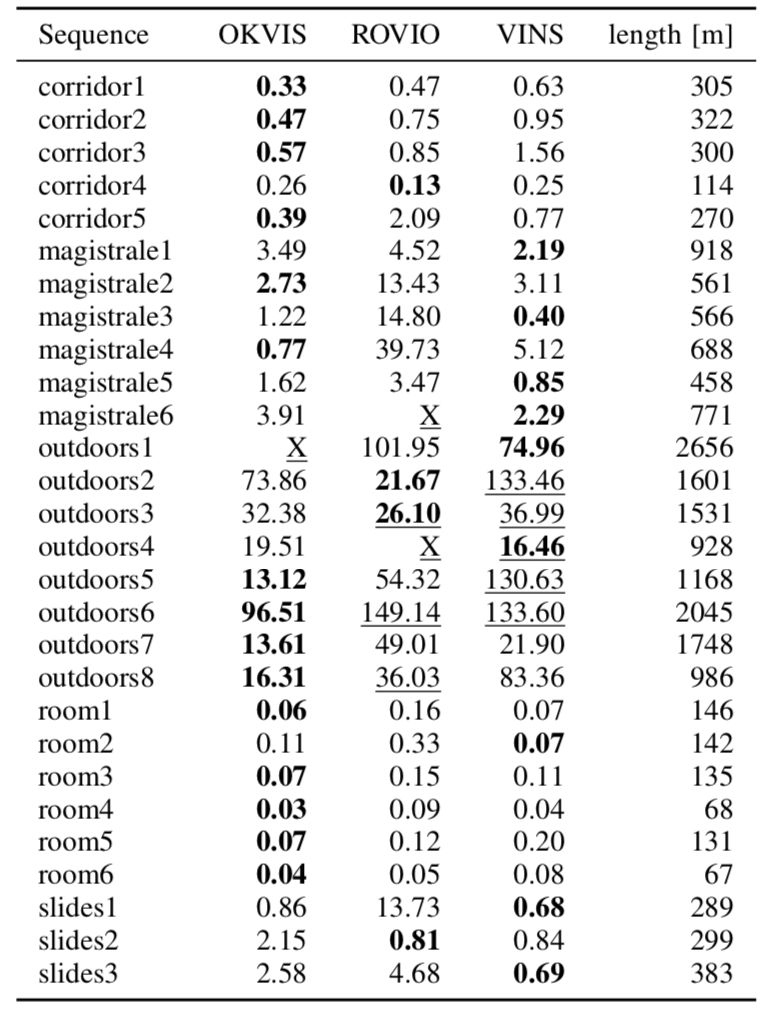

主要对ROVIO,OKVIS和VINS-Mono这三类算法进行性能评估,定量结果主要总结在表2和表3中,轨迹示意见图1。

OKVIS和VINS-Mono整体上表现较好,但在某些较长的室外序列上表现不佳。ROVIO在某些序列上表现的更易于飘移和不收敛,这可以理解,因为它的后端基于卡尔曼滤波器,而OKVIS和VINS-Mono是采用计算复杂度更高的非线性最小二乘优化的形式。VINS-Mono在一些室外序列中会发散,但通常只会发生在相机回到运动捕捉房间之后或者从主要向前运动切换到快速旋转时。这也许是因为加速度偏移(bias)估计值的漂移(drift)造成的。

评估过程说明即便是当前最优的算法在长序列(magistrale,outdoors)和有视觉挑战性的序列(slides)上会有较大的漂移。这充分说明了该数据集足够有挑战性,可以作为未来视觉惯性里程计算法研究的基准。

图1 三类方法在room3,magistrale2和slides1数据序列上的评估结果示意。

表2 三类方法在room序列上的RMSE RPE(单位:m)

表3 三类方法的RMSE ATE(单位:m)

Abstract

Visual odometry and SLAM methods have alarge variety of applications in domains such as augmentedreality or robotics. Complementing vision sensors with inertialmeasurements tremendously improves tracking accuracy androbustness, and thus has spawned large interest in the development of visual-inertial (VI) odometry approaches. In this paper,we propose the TUM VI benchmark, a novel dataset with adiverse set of sequences in different scenes for evaluating VIodometry. It provides camera images with 1024x1024 resolutionat 20 Hz, high dynamic range and photometric calibration. AnIMU measures accelerations and angular velocities on 3 axesat 200Hz, while the cameras and IMU sensors are time-synchronized in hardware. For trajectory evaluation, we alsoprovide accurate pose ground truth from a motion capturesystem at high frequency (120 Hz) at the start and end of thesequences which we accurately aligned with the camera andIMU measurements. The full dataset with raw and calibrateddata is publicly available. We also evaluate state-of-the-art VIodometry approaches on our dataset.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com