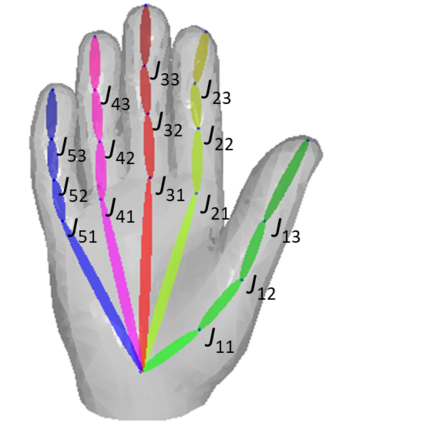

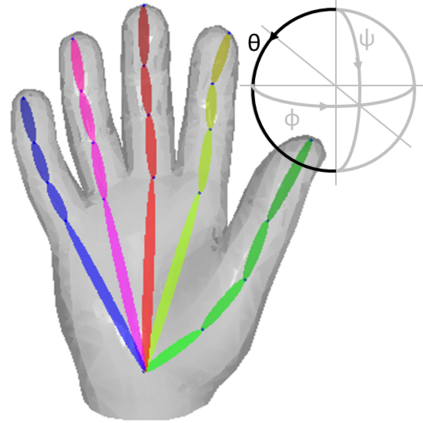

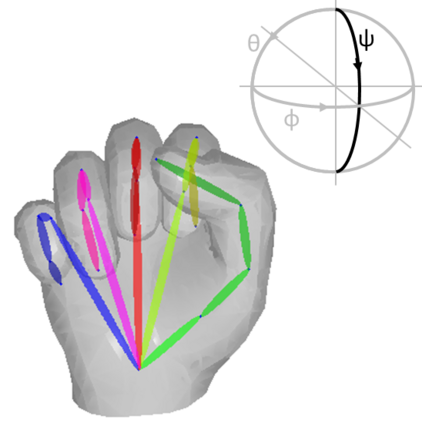

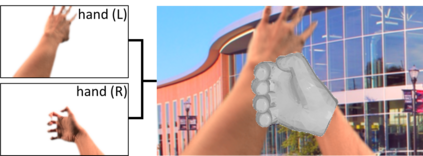

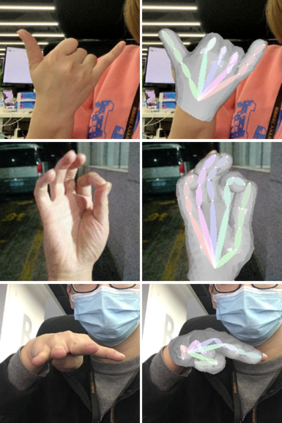

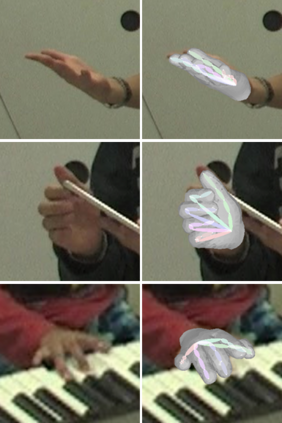

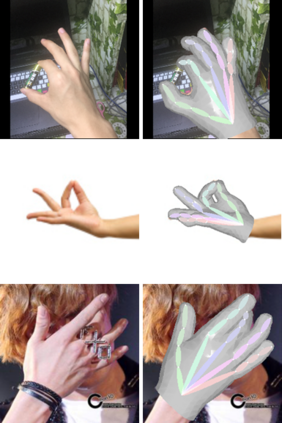

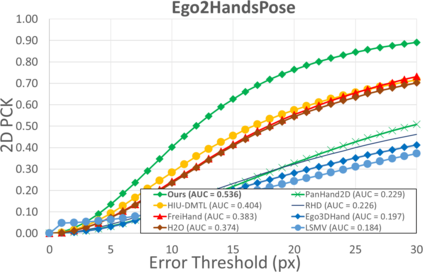

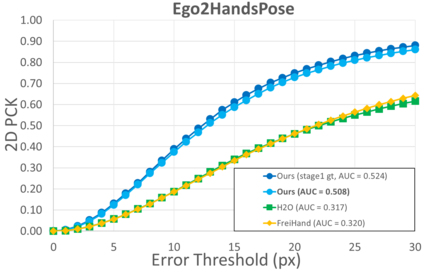

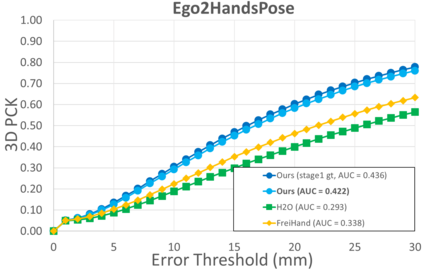

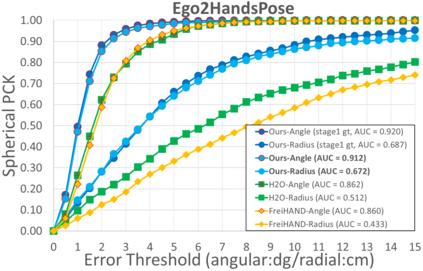

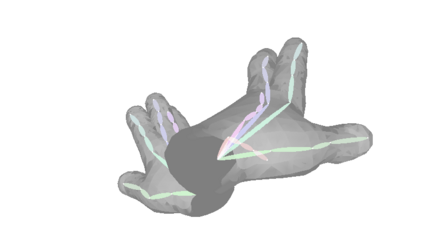

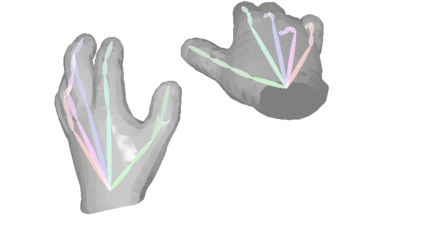

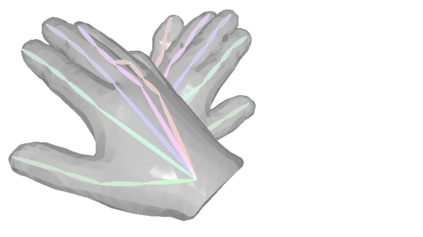

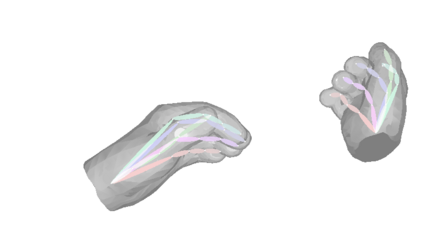

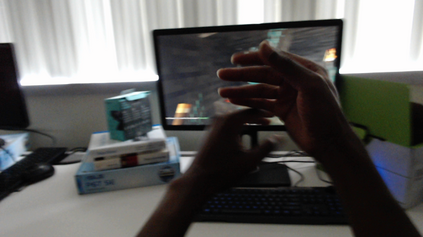

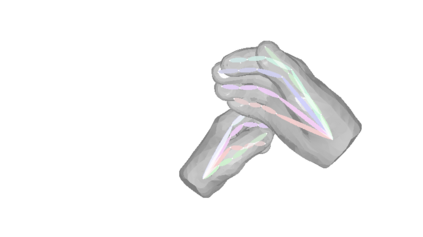

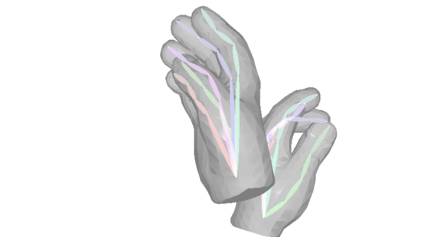

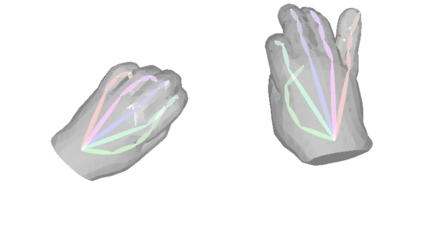

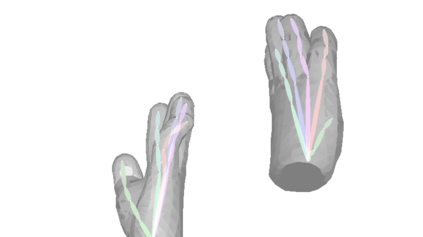

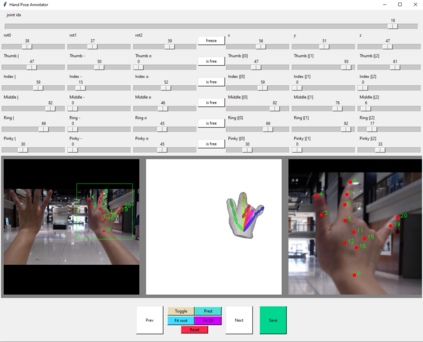

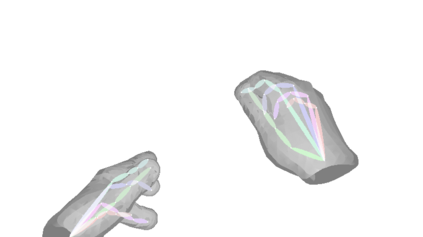

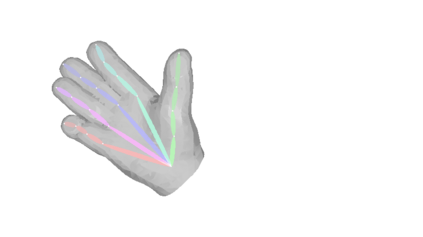

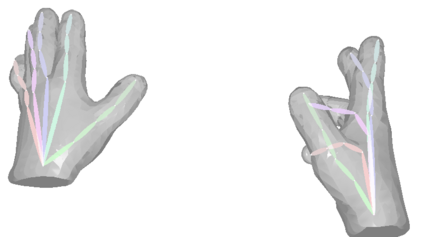

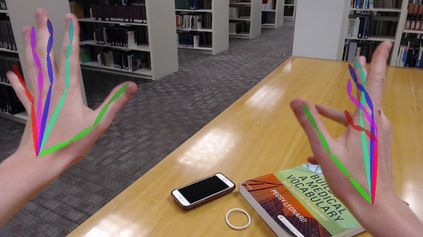

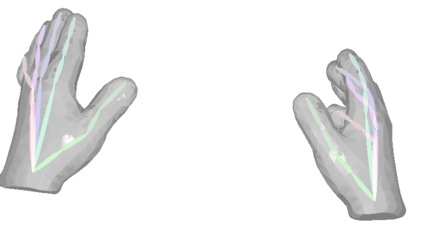

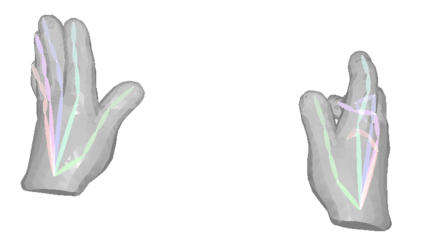

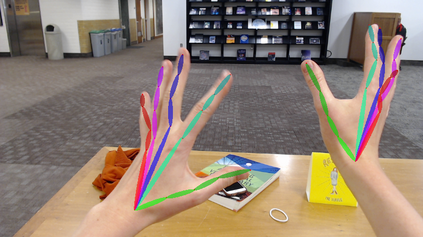

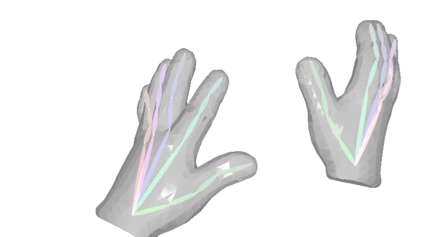

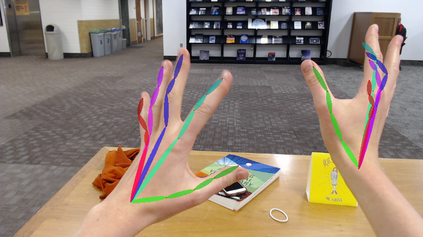

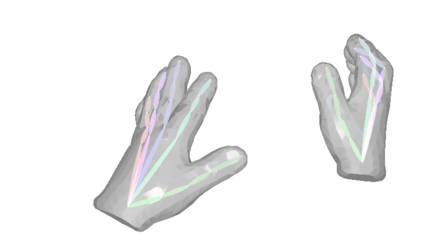

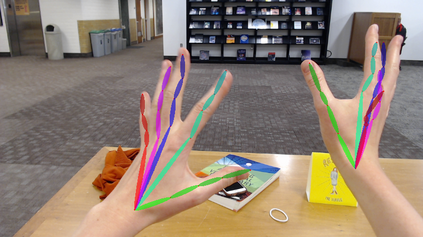

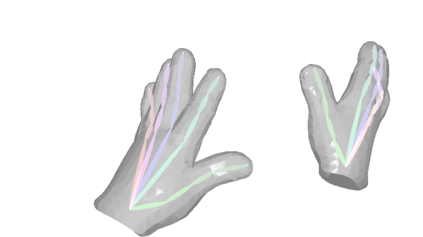

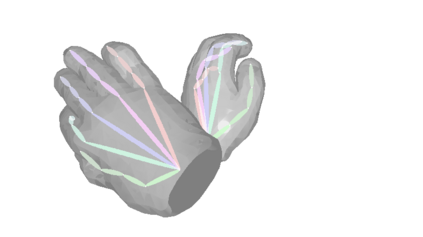

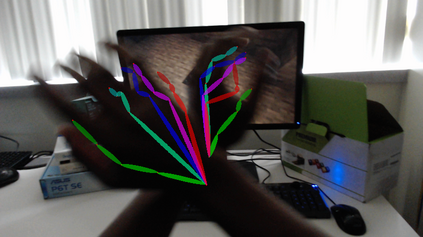

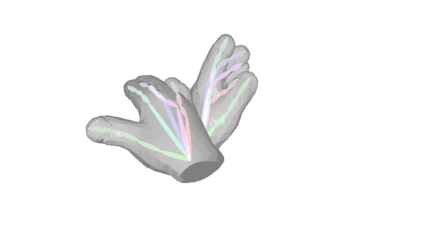

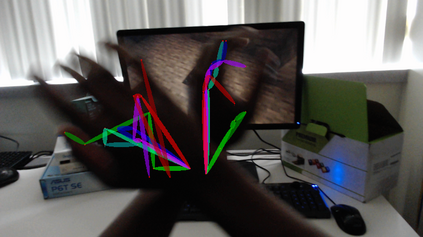

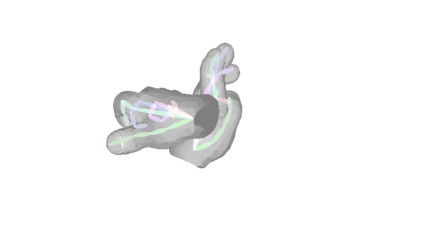

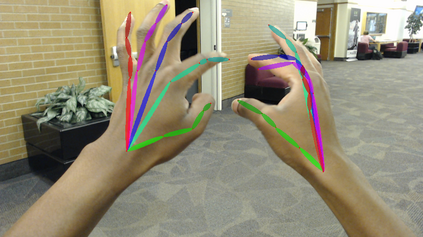

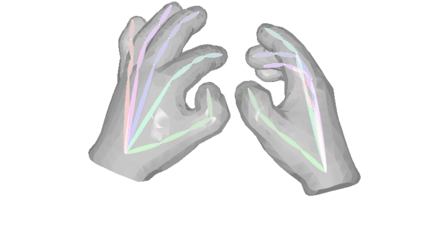

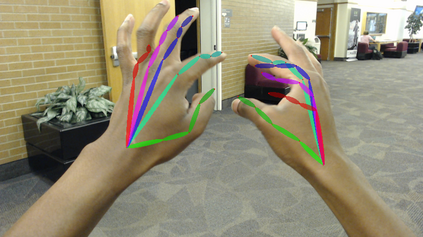

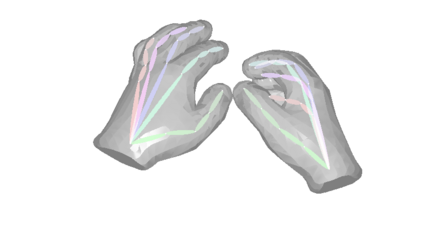

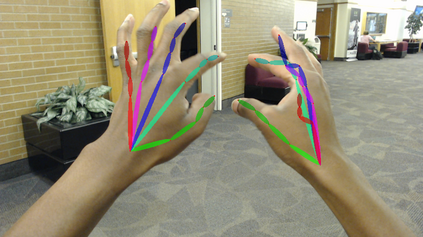

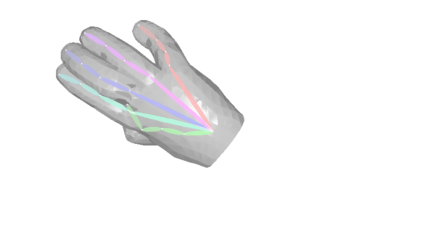

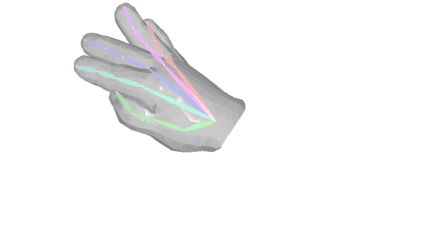

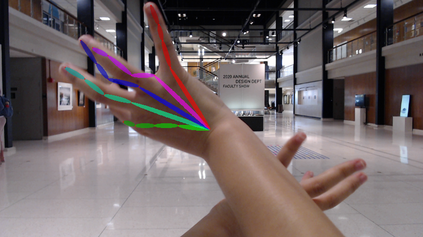

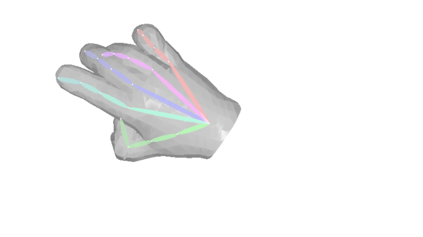

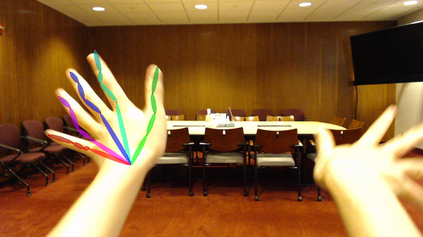

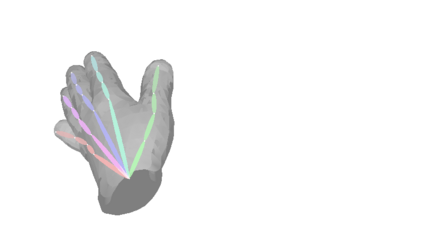

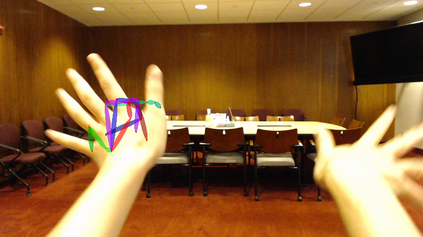

Color-based two-hand 3D pose estimation in the global coordinate system is essential in many applications. However, there are very few datasets dedicated to this task and no existing dataset supports estimation in a non-laboratory environment. This is largely attributed to the sophisticated data collection process required for 3D hand pose annotations, which also leads to difficulty in obtaining instances with the level of visual diversity needed for estimation in the wild. Progressing towards this goal, a large-scale dataset Ego2Hands was recently proposed to address the task of two-hand segmentation and detection in the wild. The proposed composition-based data generation technique can create two-hand instances with quality, quantity and diversity that generalize well to unseen domains. In this work, we present Ego2HandsPose, an extension of Ego2Hands that contains 3D hand pose annotation and is the first dataset that enables color-based two-hand 3D tracking in unseen domains. To this end, we develop a set of parametric fitting algorithms to enable 1) 3D hand pose annotation using a single image, 2) automatic conversion from 2D to 3D hand poses and 3) accurate two-hand tracking with temporal consistency. We provide incremental quantitative analysis on the multi-stage pipeline and show that training on our dataset achieves state-of-the-art results that significantly outperforms other datasets for the task of egocentric two-hand global 3D pose estimation.

翻译:在全球协调系统中基于颜色的双手 3D 显示在全球协调系统中的基于颜色的二手 3D 显示估计在许多应用中至关重要。 但是,用于这项任务的数据集非常少,而且没有现有的数据集支持在非实验室环境中进行估计。这在很大程度上归因于3D 手需要复杂的数据收集过程,带有说明,这也导致难以获得在野外估计所需的视觉多样性水平的事例。在实现这一目标的过程中,最近提出了大规模数据集 Ego2Hand 的建议,以解决野外两手分解和探测的任务。拟议的基于组成的数据生成技术可以创造质量、数量和多样性的双手实例,在非实验室环境中进行广泛覆盖。在这项工作中,我们介绍Ego2Hands Pose, Ego2Hands的扩展, 包含3D 手说明,这是第一个数据集,使得在隐蔽域进行基于颜色的双手跟踪3D 3D 跟踪。我们开发一套参数匹配算法,以便1) 3D 使用单一图像进行两手说明,2D 直观的双向未知域,2D 直径直径,在2D 直径直径对3D 和多式数据分析上显示我们从2D 直径方向分析,从2D 直径方向分析,从2D 向3D 直径对方向分析。