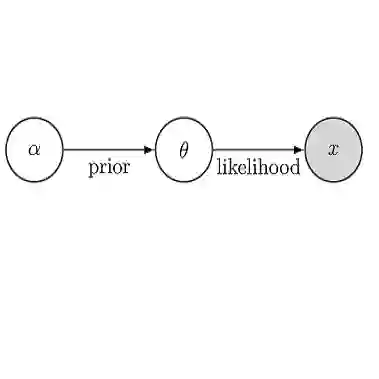

Unlike the classical linear model, nonlinear generative models have been addressed sparsely in the literature of statistical learning. This work aims to bringing attention to these models and their secrecy potential. To this end, we invoke the replica method to derive the asymptotic normalized cross entropy in an inverse probability problem whose generative model is described by a Gaussian random field with a generic covariance function. Our derivations further demonstrate the asymptotic statistical decoupling of the Bayesian estimator and specify the decoupled setting for a given nonlinear model. The replica solution depicts that strictly nonlinear models establish an all-or-nothing phase transition: There exists a critical load at which the optimal Bayesian inference changes from perfect to an uncorrelated learning. Based on this finding, we design a new secure coding scheme which achieves the secrecy capacity of the wiretap channel. This interesting result implies that strictly nonlinear generative models are perfectly secured without any secure coding. We justify this latter statement through the analysis of an illustrative model for perfectly secure and reliable inference.

翻译:与古典线性模型不同,统计学文献很少涉及非线性基因模型。这项工作旨在提请人们注意这些模型及其隐秘潜力。为此,我们采用复制方法,在反概率问题中得出无症状的正常交叉酶,其基因模型由带有通用共变函数的高斯随机字段描述为反概率问题。我们的衍生结果进一步表明巴耶斯估计器的无症状统计脱钩,并具体说明给定的非线性模型的脱钩设置。复制的解决方案说明,严格非线性模型建立全无或全无的过渡阶段:存在一种临界负荷,最佳巴伊斯推断从完美到不相干学习的最佳推断值从完美到不相干学习。基于这一发现,我们设计一个新的安全编码计划,实现窃听频道的保密能力。这一有趣的结果意味着,完全非线性基因模型在没有任何安全的编码的情况下得到完全的保证。我们通过分析一个非常安全和可靠的导断断断的示例模型来解释后一句。