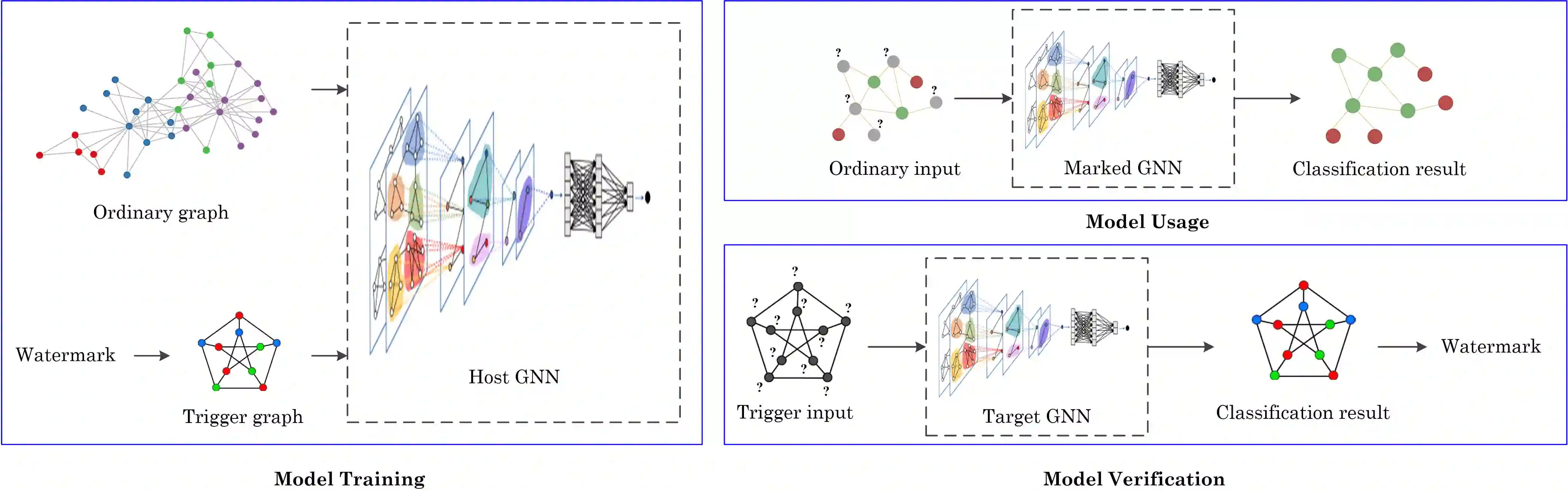

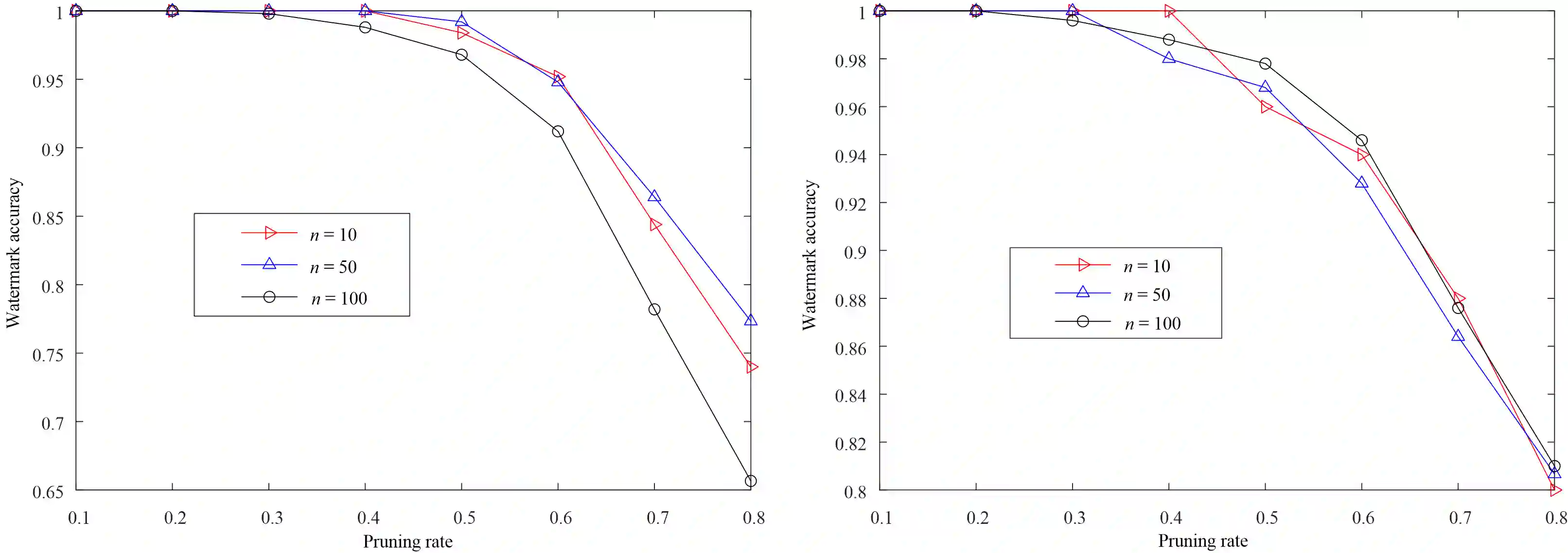

Many learning tasks require us to deal with graph data which contains rich relational information among elements, leading increasing graph neural network (GNN) models to be deployed in industrial products for improving the quality of service. However, they also raise challenges to model authentication. It is necessary to protect the ownership of the GNN models, which motivates us to present a watermarking method to GNN models in this paper. In the proposed method, an Erdos-Renyi (ER) random graph with random node feature vectors and labels is randomly generated as a trigger to train the GNN to be protected together with the normal samples. During model training, the secret watermark is embedded into the label predictions of the ER graph nodes. During model verification, by activating a marked GNN with the trigger ER graph, the watermark can be reconstructed from the output to verify the ownership. Since the ER graph was randomly generated, by feeding it to a non-marked GNN, the label predictions of the graph nodes are random, resulting in a low false alarm rate (of the proposed work). Experimental results have also shown that, the performance of a marked GNN on its original task will not be impaired. Moreover, it is robust against model compression and fine-tuning, which has shown the superiority and applicability.

翻译:许多学习任务要求我们处理含有各元素之间丰富关联信息的图表数据,导致在工业产品中使用越来越多的图形神经网络模型,以提高服务质量。但它们也提出了模型认证的挑战。有必要保护GNN模型的所有权,这促使我们向本文中的GNN模型提供水标识方法。在拟议方法中,带有随机节点特性矢量和标签的Erdos-Renyi(ER)随机随机生成随机随机生成图,作为将GNN与正常样本一起加以保护的触发点。在模型培训期间,秘密水印嵌入ER图形节点的标签预测中。在模型核查期间,通过启动一个带有触发ER图的标志GNN,水标记可以从输出中重建用于核实所有权。由于将ER图输入到一个非标记的GNNN,因此图节点的标签预测是随机生成的,从而导致与正常样本一起保护GNNN的低度警报率(拟议工作) 。在模型验证过程中,通过启动一个标记GNNN的标志性G,实验结果也显示它的精确性,其性将显示它的精确性。