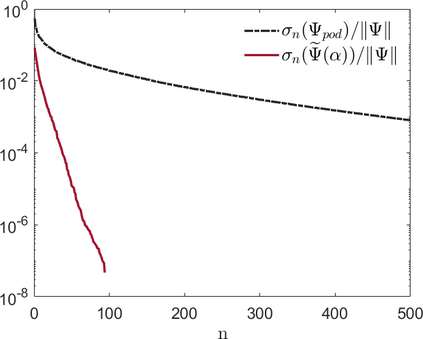

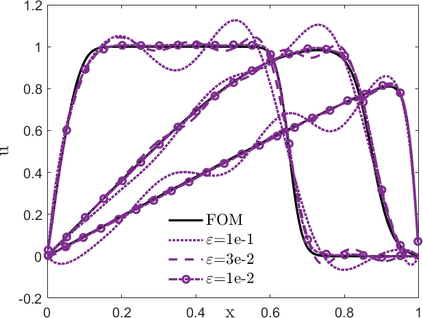

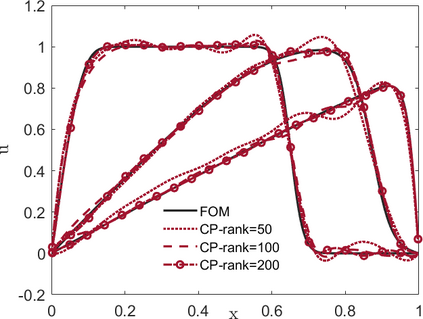

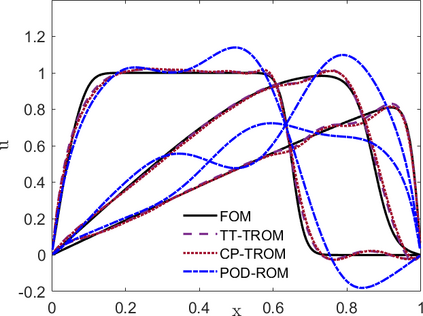

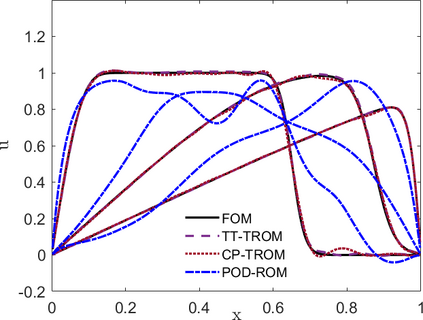

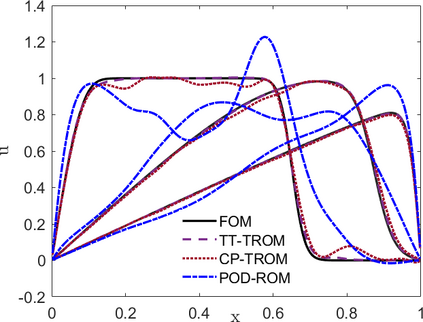

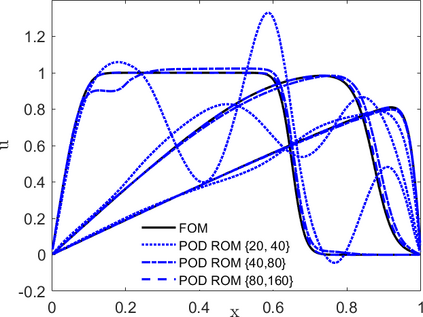

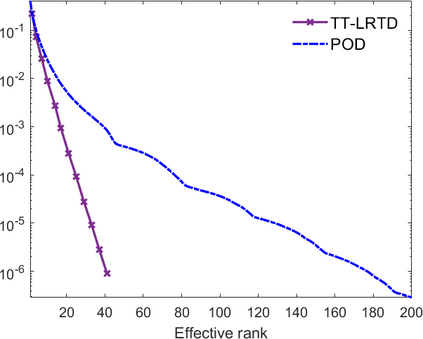

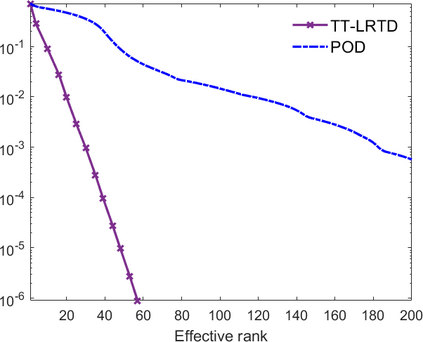

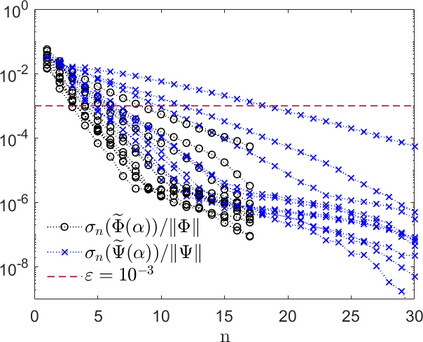

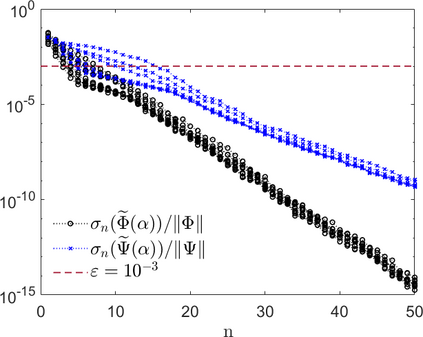

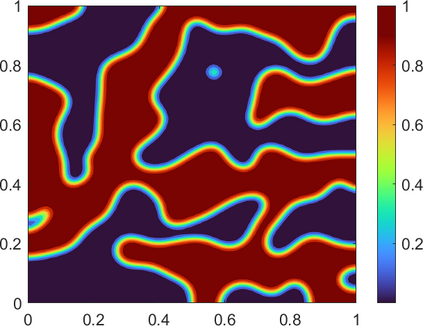

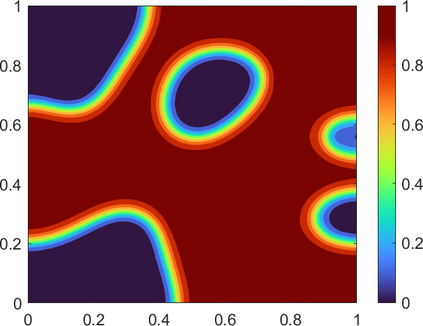

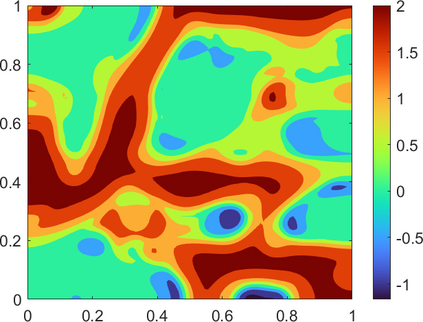

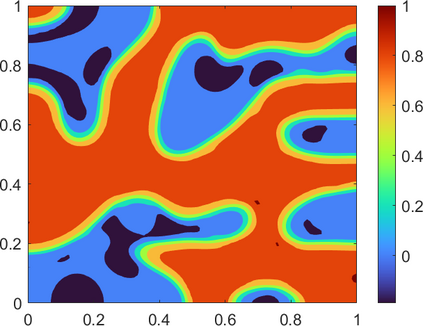

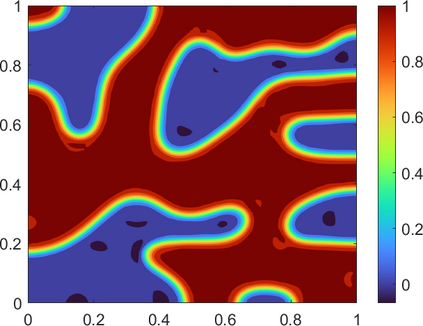

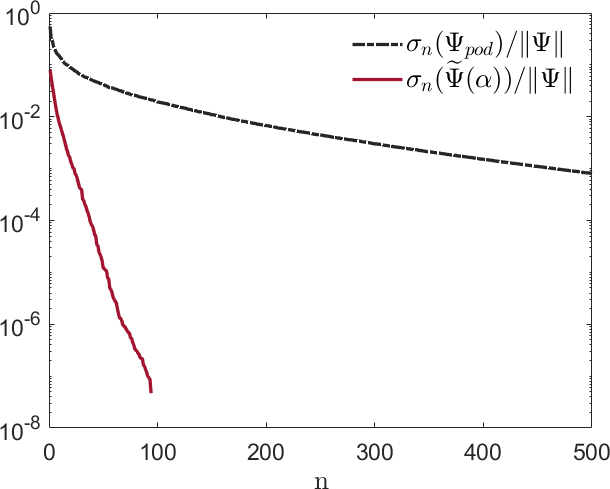

For a nonlinear dynamical system depending on parameters the paper introduces a novel tensorial reduced order model (TROM). The reduced model is projection-based and for systems with no parameters involved it resembles the proper orthogonal decomposition (POD) combined with the discrete empirical interpolation method (DEIM). For parametric systems, the TROM employs low-rank tensor approximations in place of truncated SVD, a key dimension-reduction technique in POD with DEIM. Three popular low-rank tensor compression formats are considered for this purpose: canonical polyadic, Tucker, and tensor train. The use of multi-linear algebra tools allows to incorporate the information about the parameter dependence of the system into the reduced model and leads to a POD--DEIM type ROM which (i) is parameter-specific (localized) and predicts the system dynamics for out-of-training set (unseen) parameter values, (ii) mitigates the adverse effects of high parameter space dimension, (iii) has online computational costs that depend only on tensor compression ranks but not on the full order model size, and (iv) achieves lower reduced space dimensions compared to the conventional POD--DEIM ROM. The paper explains the method, analyzes its prediction power, and assesses its performance for two specific parameter-dependent non-linear dynamical systems.

翻译:对于视参数而定的非线性动态系统,本文引入了一个新的微缩降序模型(TROM)。降级模型以投影为基础,对于没有涉及参数的系统来说,该模型类似于适当的正心分解(POD)和独立的实证内插法(DEIM)。对于参数系统来说,TROM采用低调高压近似值,以取代脱节的SVD,这是与DEIM一起的POD中降低关键维度的技术。为此考虑三种流行的低调低调压压缩格式:Canonial 多元体、Tucker和高压列列。使用多线性代数代数工具可以将关于系统参数依赖性的信息纳入降格模型,并导致POD-DEIM型ROM(POD-DEIM-DEIM)型ROM(I)是针对特定参数的(本地化),并预测系统外设(不见参数)参数值,(二)减轻高参数空间层面的不利影响,(三)在线计算成本仅取决于Stororma压缩级,但不取决于其总体预测系统。