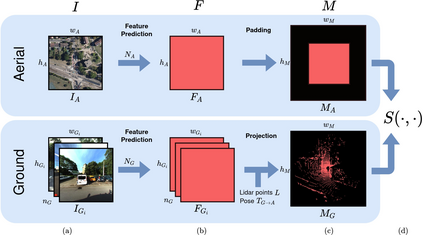

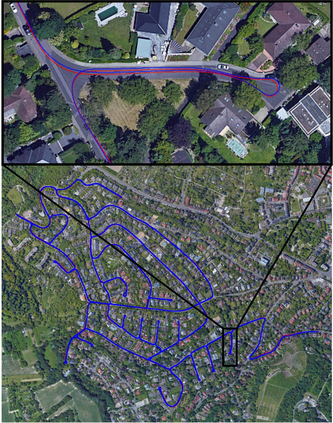

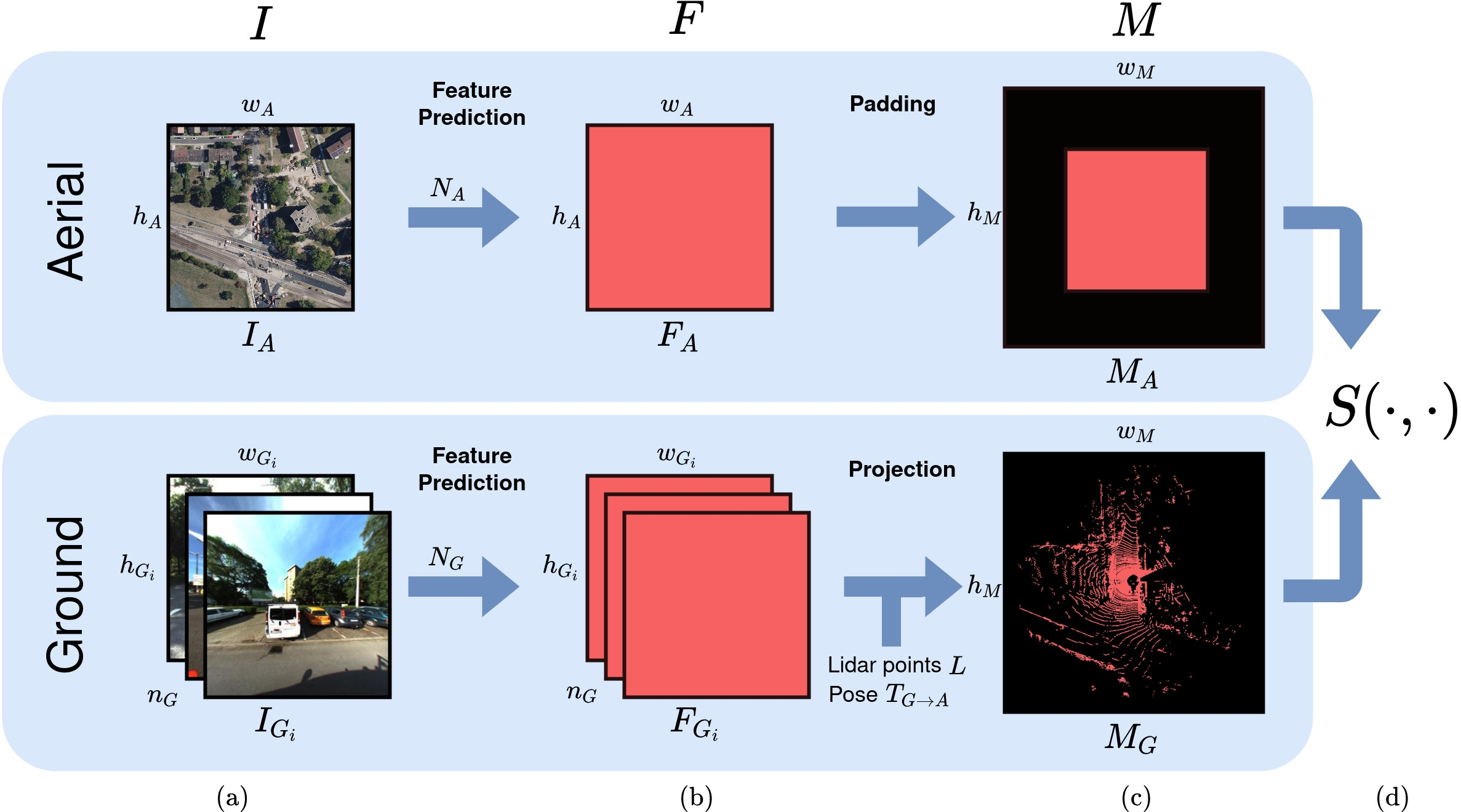

This paper proposes a novel method for geo-tracking, i.e. continuous metric self-localization in outdoor environments by registering a vehicle's sensor information with aerial imagery of an unseen target region. Geo-tracking methods offer the potential to supplant noisy signals from global navigation satellite systems (GNSS) and expensive and hard to maintain prior maps that are typically used for this purpose. The proposed geo-tracking method aligns data from on-board cameras and lidar sensors with geo-registered orthophotos to continuously localize a vehicle. We train a model in a metric learning setting to extract visual features from ground and aerial images. The ground features are projected into a top-down perspective via the lidar points and are matched with the aerial features to determine the relative pose between vehicle and orthophoto. Our method is the first to utilize on-board cameras in an end-to-end differentiable model for metric self-localization on unseen orthophotos. It exhibits strong generalization, is robust to changes in the environment and requires only geo-poses as ground truth. We evaluate our approach on the KITTI-360 dataset and achieve a mean absolute position error (APE) of 0.94m. We further compare with previous approaches on the KITTI odometry dataset and achieve state-of-the-art results on the geo-tracking task.

翻译:本文提出了一种新的地球跟踪方法,即在户外环境中连续采用衡量自我定位的计量方法,将车辆的传感器信息与隐形目标区域的空中图像进行注册; 地球跟踪方法有可能取代全球导航卫星系统(GNSS)的噪音信号以及通常用于此目的的昂贵和难以维持的先前地图; 拟议的地球跟踪方法将机上照相机和激光传感器的数据与在地籍登记的矫形摄影机和激光传感器的数据统一起来,使车辆持续本地化; 我们培训了一个模型,在计量学习环境中从地面和空中图像中提取视觉特征。 地面地貌特征通过利达尔点投射到自上下视角,并与天体特征相匹配,以确定车辆和矫形摄影机之间的相对位置。 我们的方法是首先使用机上摄影机上的不同模型,在隐形或相光谱上进行计量自我定位。 它显示出很强的概观性,对环境的变化非常有力,只需要将地貌定位作为地面事实。 我们评估了我们关于SMATI-360号的绝对值定位方法,我们用SIT-A的地理定位方法进一步测量了我们之前的地球定位,并实现了SIT-360号的数据。