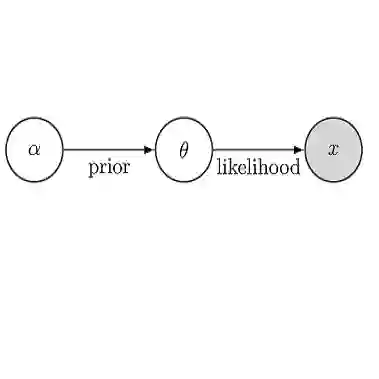

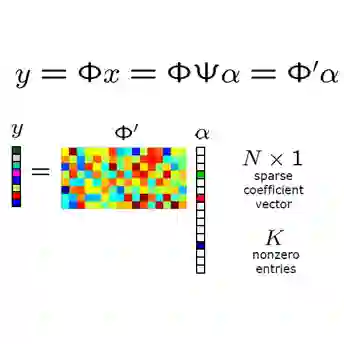

Purpose: To develop a deep learning-based Bayesian inference for MRI reconstruction. Methods: We modeled the MRI reconstruction problem with Bayes's theorem, following the recently proposed PixelCNN++ method. The image reconstruction from incomplete k-space measurement was obtained by maximizing the posterior possibility. A generative network was utilized as the image prior, which was computationally tractable, and the k-space data fidelity was enforced by using an equality constraint. The stochastic backpropagation was utilized to calculate the descent gradient in the process of maximum a posterior, and a projected subgradient method was used to impose the equality constraint. In contrast to the other deep learning reconstruction methods, the proposed one used the likelihood of prior as the training loss and the objective function in reconstruction to improve the image quality. Results: The proposed method showed an improved performance in preserving image details and reducing aliasing artifacts, compared with GRAPPA, $\ell_1$-ESPRiT, and MODL, a state-of-the-art deep learning reconstruction method. The proposed method generally achieved more than 5 dB peak signal-to-noise ratio improvement for compressed sensing and parallel imaging reconstructions compared with the other methods. Conclusion: The Bayesian inference significantly improved the reconstruction performance, compared with the conventional $\ell_1$-sparsity prior in compressed sensing reconstruction tasks. More importantly, the proposed reconstruction framework can be generalized for most MRI reconstruction scenarios.

翻译:目的是:为MRI重建开发基于深层次学习的巴耶斯测谎。 方法 : 我们按照最近提议的 PixelCNN++ 方法,以Bayes 的理论模拟了MRI重建问题。 利用了不完全的K-空间测量图象的重建,这是通过尽可能扩大后继可能性而获得的。 一个基因化网络是作为先前的图像使用的,可以进行计算,K-空间数据忠诚是通过使用平等限制来执行的。 使用随机反演法来计算最高后继器过程中的下降梯度,并使用预测的次梯度方法来强加平等制约。 与其他深学习的重建方法相比,提议的图象利用了以前作为培训损失和在重建中客观功能的可能性,以提高图像质量。 结果: 与GRAPPA、$ell_1 ESPRiT和MODL相比, 一种最高级的深度学习重建方法, 与最高级的重建相比,比以往的标准化的标准化的重建比,比以前的标准化的重建比比前的更高级的改进的图像。