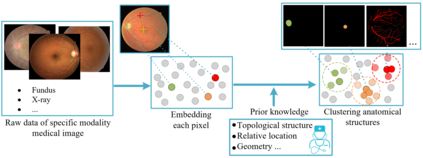

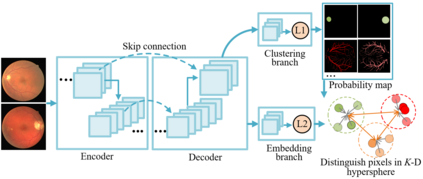

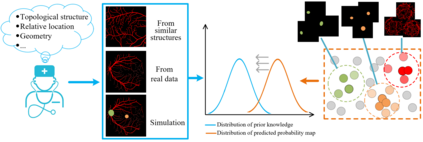

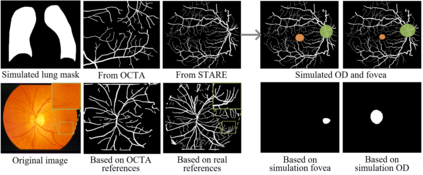

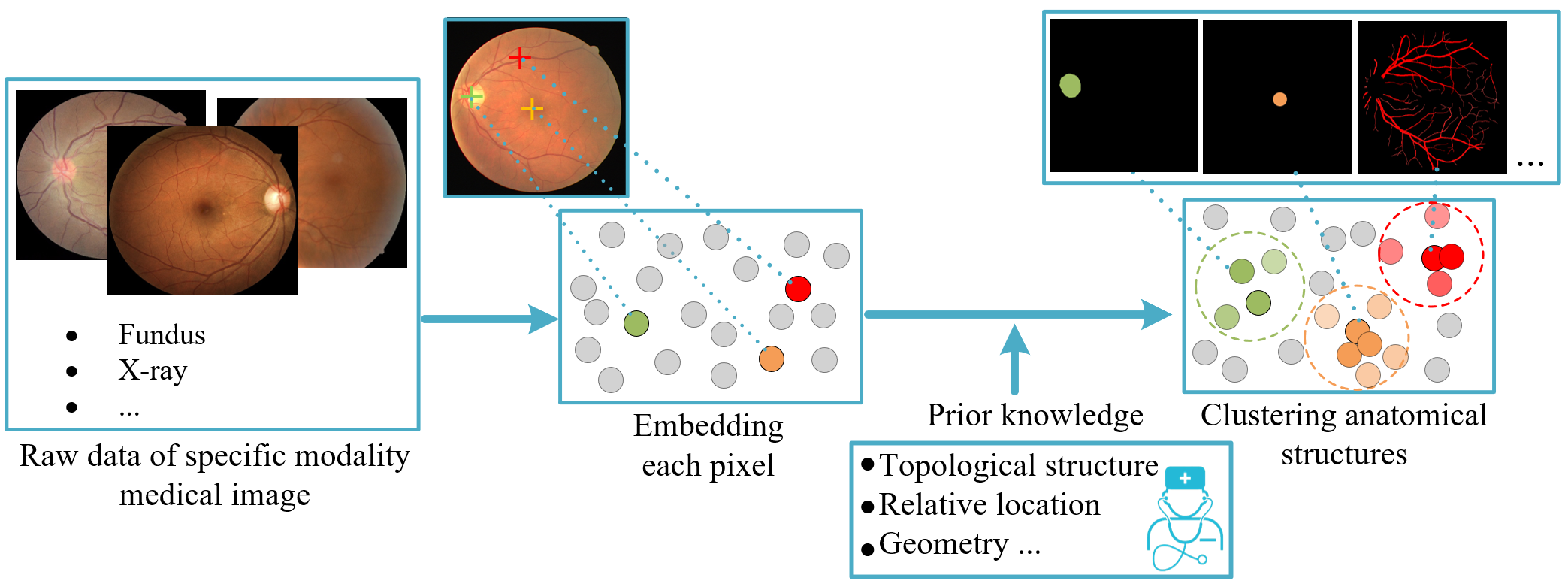

Local discriminative representation is needed in many medical image analysis tasks such as identifying sub-types of lesion or segmenting detailed components of anatomical structures. However, the commonly applied supervised representation learning methods require a large amount of annotated data, and unsupervised discriminative representation learning distinguishes different images by learning a global feature, both of which are not suitable for localized medical image analysis tasks. In order to avoid the limitations of these two methods, we introduce local discrimination into unsupervised representation learning in this work. The model contains two branches: one is an embedding branch which learns an embedding function to disperse dissimilar pixels over a low-dimensional hypersphere; and the other is a clustering branch which learns a clustering function to classify similar pixels into the same cluster. These two branches are trained simultaneously in a mutually beneficial pattern, and the learnt local discriminative representations are able to well measure the similarity of local image regions. These representations can be transferred to enhance various downstream tasks. Meanwhile, they can also be applied to cluster anatomical structures from unlabeled medical images under the guidance of topological priors from simulation or other structures with similar topological characteristics. The effectiveness and usefulness of the proposed method are demonstrated by enhancing various downstream tasks and clustering anatomical structures in retinal images and chest X-ray images.

翻译:在许多医学图像分析任务中,例如确定病变或分解病变或解析解剖结构详细组成部分的子类型,都需要地方的歧视性代表制分析任务,例如查明病变或分解病变或解剖解剖结构的详细组成部分。然而,通常采用的受监督的代表制学习方法需要大量附加说明的数据,而未经监督的歧视性代表制学习通过学习全球特征而区分不同的图像,这两种特征都不适合局部医学图像分析任务。为了避免这两种方法的局限性,我们在这项工作中将地方歧视引入不受监督的代表制学习。模型包含两个分支:一个是嵌入分支,学习嵌入功能,将异同异像素散布在低维度超镜之上;另一个是集群分支,学习集群功能,将相似的像素分类到同一组群中。这两个分支同时受到培训,不能用于局部的医学图像分析任务;为改进各种下游任务,还可以用于从未贴标签的医学图像中分离出一个嵌入功能;通过模拟或下游图象结构,通过模拟和下游图象结构,展示一种具有更高用途的图象学特性的其他结构结构。