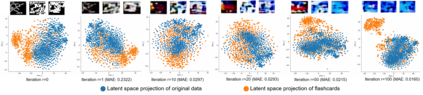

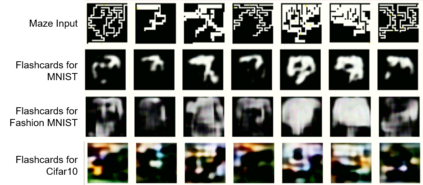

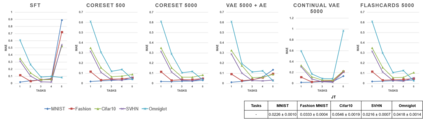

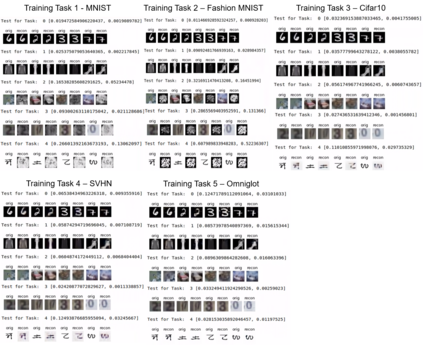

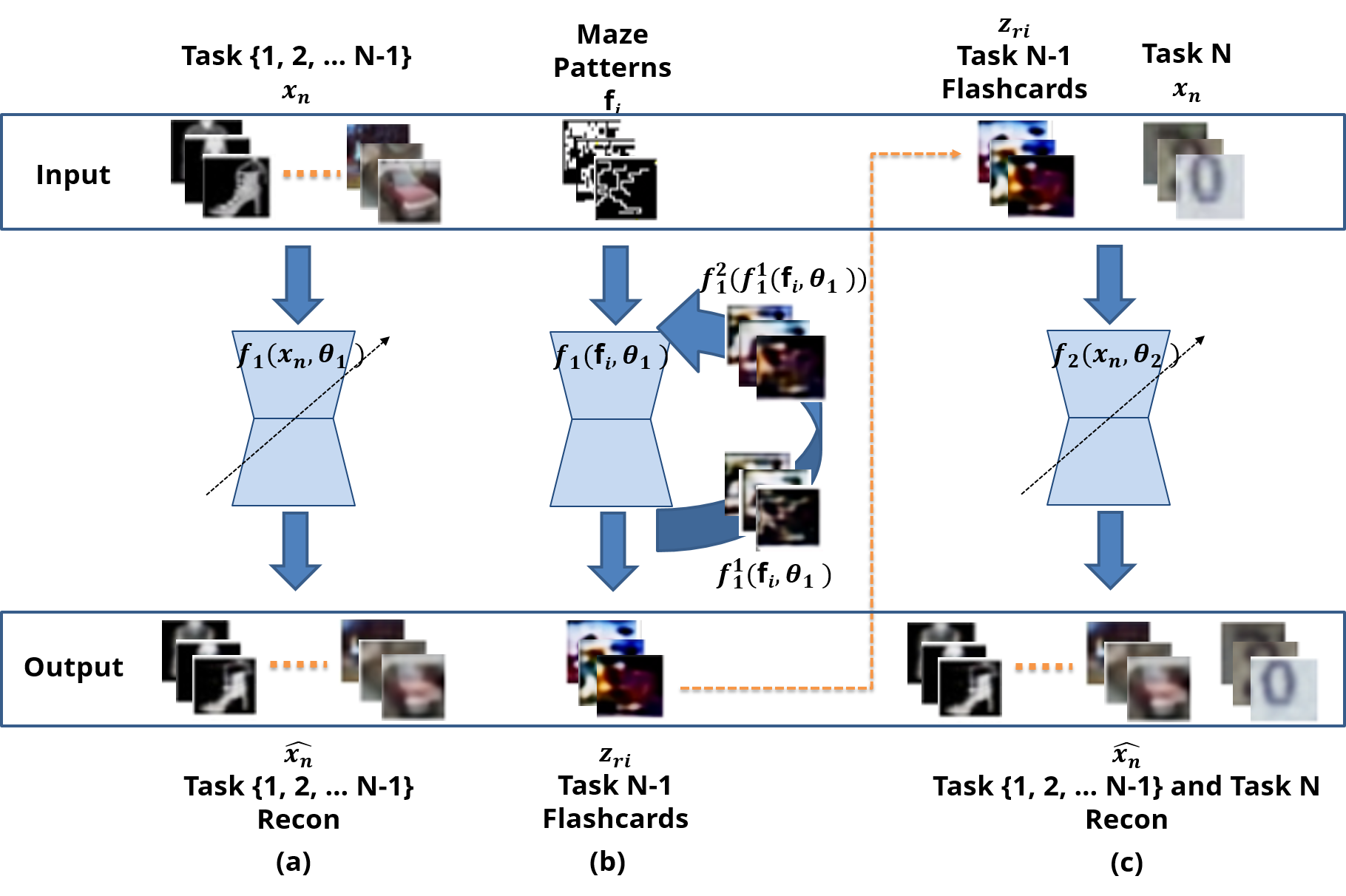

Deep neural networks have shown promise in several domains, and the learned task-specific information is implicitly stored in the network parameters. It will be vital to utilize representations from these networks for downstream tasks such as continual learning. In this paper, we introduce the notion of {\em flashcards} that are visual representations to {\em capture} the encoded knowledge of a network, as a function of random image patterns. We demonstrate the effectiveness of flashcards in capturing representations and show that they are efficient replay methods for general and task agnostic continual learning setting. Thus, while adapting to a new task, a limited number of constructed flashcards, help to prevent catastrophic forgetting of the previously learned tasks. Most interestingly, such flashcards neither require external memory storage nor need to be accumulated over multiple tasks and only need to be constructed just before learning the subsequent new task, irrespective of the number of tasks trained before and are hence task agnostic. We first demonstrate the efficacy of flashcards in capturing knowledge representation from a trained network, and empirically validate the efficacy of flashcards on a variety of continual learning tasks: continual unsupervised reconstruction, continual denoising, and new-instance learning classification, using a number of heterogeneous benchmark datasets. These studies also indicate that continual learning algorithms with flashcards as the replay strategy perform better than other state-of-the-art replay methods, and exhibits on par performance with the best possible baseline using coreset sampling, with the least additional computational complexity and storage.

翻译:深心神经网络在多个领域显示出希望, 所学到的具体任务信息隐含在网络参数中。 至关重要的是, 要利用这些网络的演示来完成诸如持续学习等下游任务。 在本文中, 我们引入“ ~ em 闪存卡” 的概念, 将它作为随机图像模式的函数, 是网络的编码知识的函数 。 我们演示闪存卡在获取演示中的有效性, 并显示它们对于一般和任务不可知的持续学习设置来说是有效的复放方法。 因此, 在适应新任务的同时, 有限的构建闪存卡数量有助于防止灾难性地忘记先前学到的任务。 最有趣的是, 这些闪存卡不需要外部存储, 也不需要在多个任务中累积, 只需在学习随后的新任务之前,, 不论以前训练过多少任务, 因而是任务不可知的。 我们首先展示闪存卡在获取来自受过训练的网络的知识体现和任务持续持续持续学习的更多内容方面的有效性, 并且用经验来验证闪存新卡在各种持续学习的任务上的功效: 持续不为持续、 持续不彻底的存储存储存储的存储的存储, 和不断的存储 基础战略的重新学习, 学习这些基础的升级的学习, 学习, 学习, 学习, 学习这些 学习的升级的进度的进度的进度的进度的进度, 以及其它的进度的升级的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的技巧,,,,, 学习的进度的技巧, 学习, 学习, 学习, 学习, 学习的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的技巧, 学习, 学习,,, 学习, 学习, 学习的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度, 学习, 学习, 学习, 学习, 学习, 学习, 和速度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的进度的技巧, 和速度的进度的进度的进度的变。

相关内容

Source: Apple - iOS 8