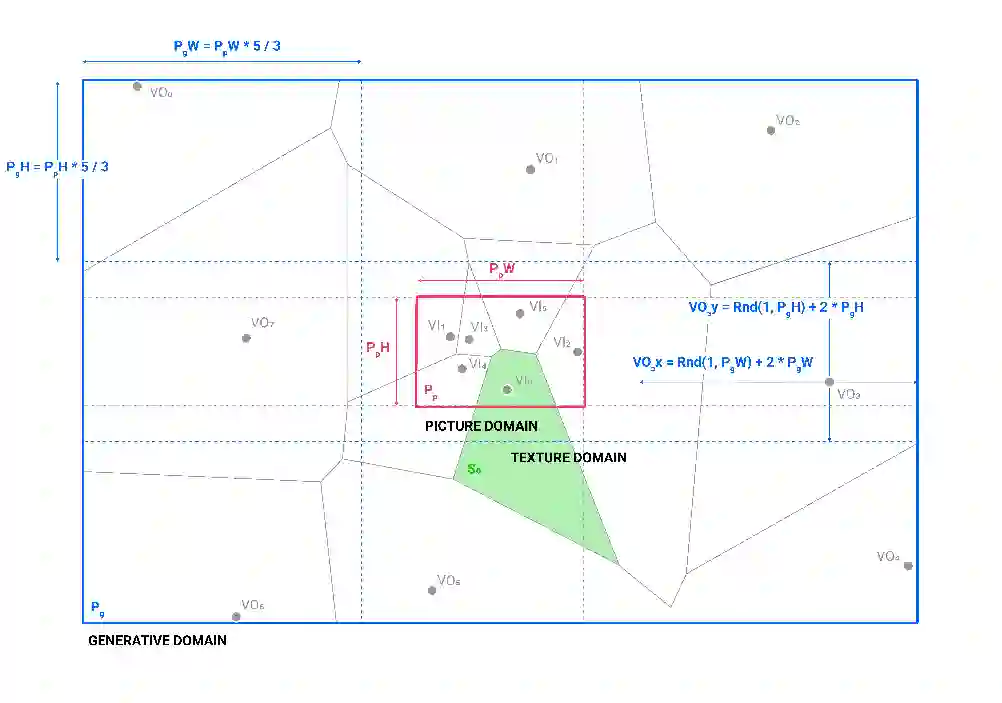

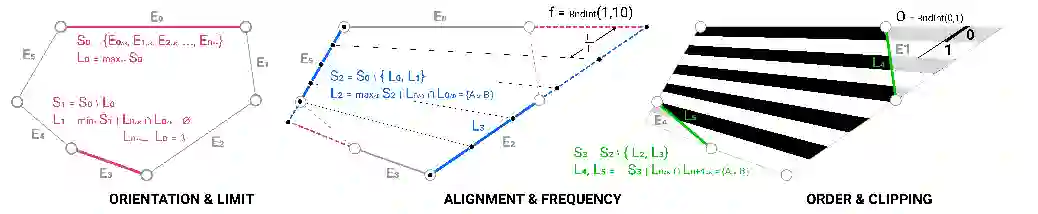

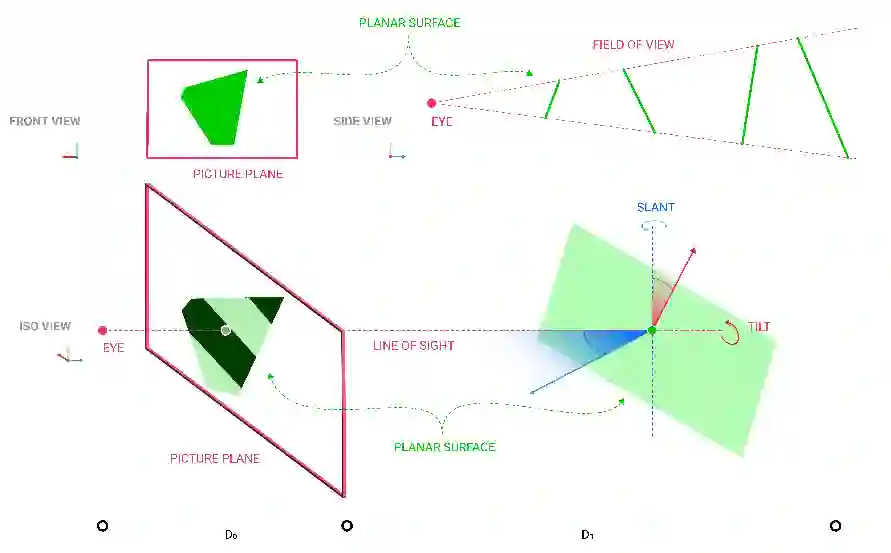

This paper focuses on a specific aspect of human visual discrimination from computationally generated solutions for CAAD ends. The bottleneck at work here concern informational ratios of discriminative rates over generative ones. The amount of information that can be brought to a particular sensory modality for human perception is subject to bandwidth and dimensional limitations. This problem is well known in Brain-Computer Interfaces, where the flow of relevant information must be maintained through such interaction for applicative ends and adoption of use in many fields of human activity. While architectural modeling conveys a high level of complexity in its processes, let alone in the presentation of its generated design solutions, promises in applicative potentials of such interfaces must be made aware of these fundamental issues and need developments of appropriate sophistication. This paper addresses this informational bottleneck by introducing a method to retrieve spatial information from the rapid serial visual presentation of generated pictures. This method will be explained and defined as inverse modeling, based on inverse graphics, and its relation to human visual processing.

翻译:本文侧重于从计算产生的CAAD最终解决方案中产生的人的视觉歧视的一个具体方面。这里的工作瓶颈涉及歧视率相对于基因化的差别率的信息比。可以带给特定感官模式的人类感知信息数量受带宽和维度限制的限制。这个问题在大脑-计算机界面中是众所周知的,通过这种互动,为适应目的和在人类活动的许多领域采用应用而维持相关信息的流动。虽然建筑模型表明其过程的高度复杂性,更不用说在介绍其生成的设计解决方案时,但必须让这些界面的辅助潜力意识到这些基本问题,需要适当先进的发展。本文通过采用一种方法从生成的图片的快速序列直观演示中检索空间信息,从而解决了这一信息瓶颈问题。该方法的解释和定义将基于反向图形及其与人类视觉处理的关系进行反向建模。