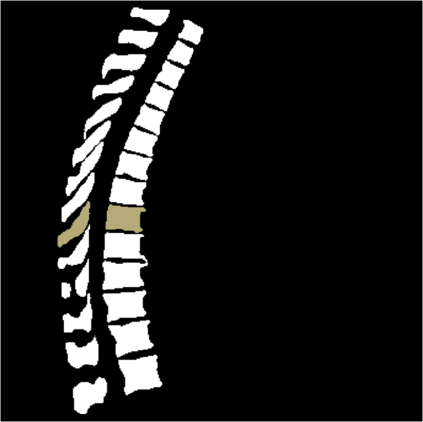

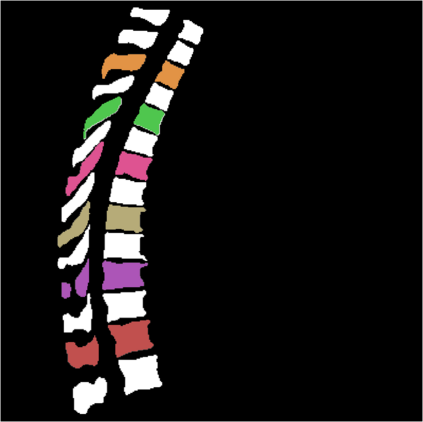

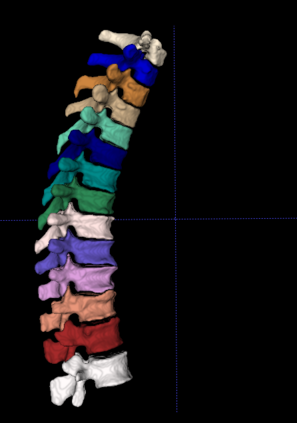

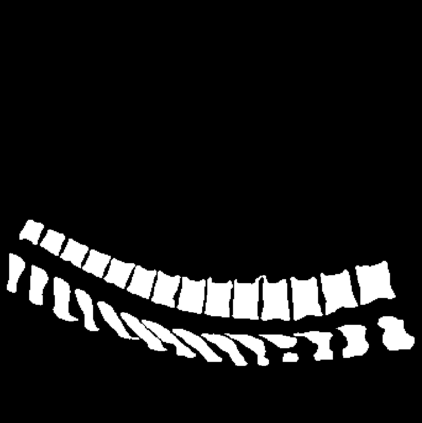

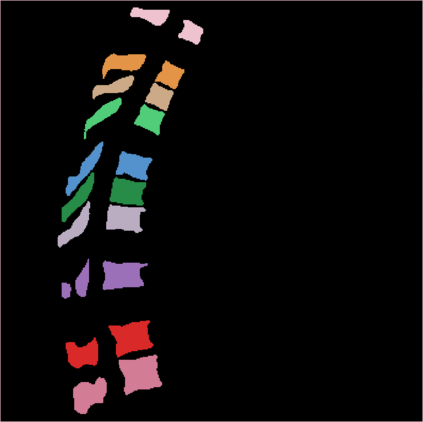

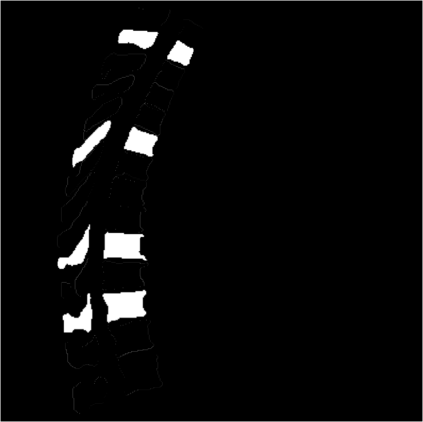

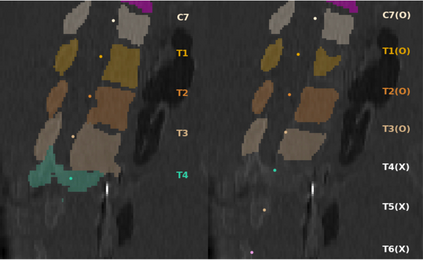

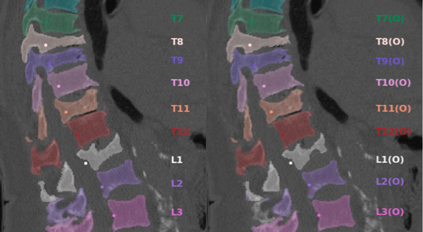

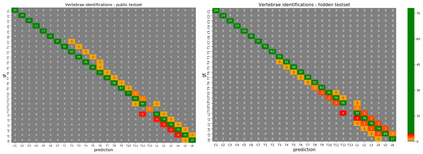

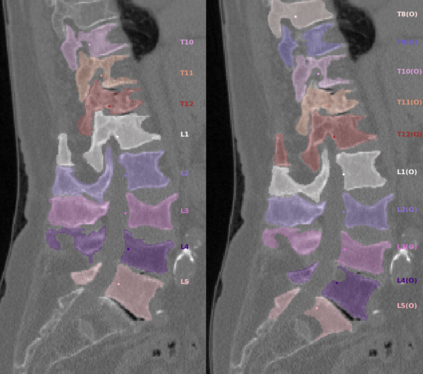

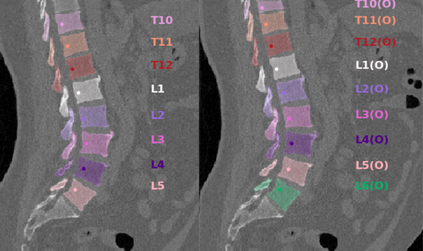

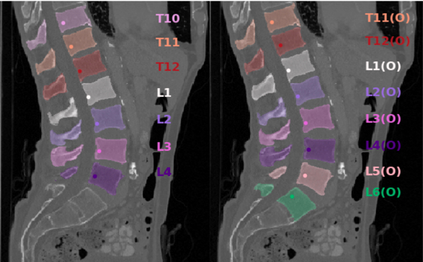

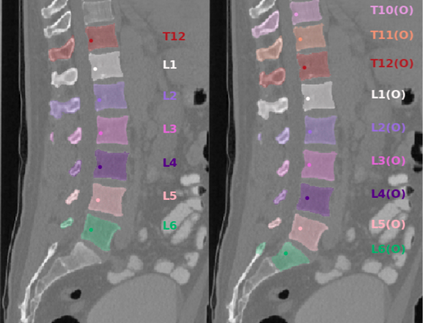

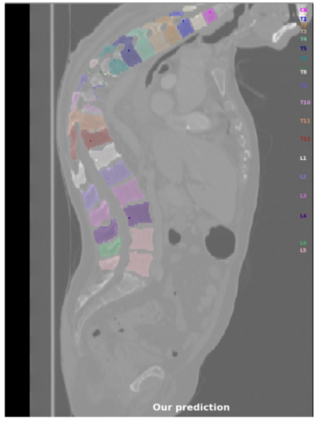

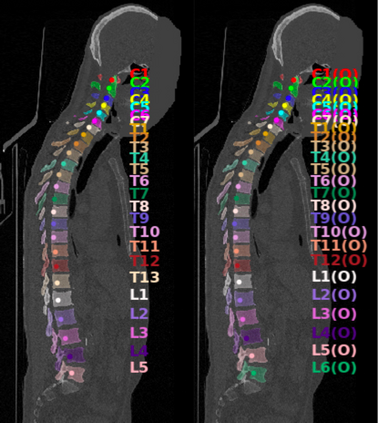

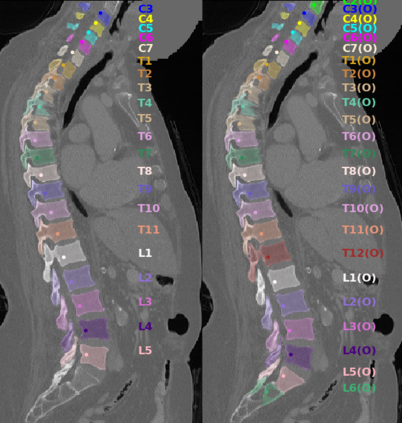

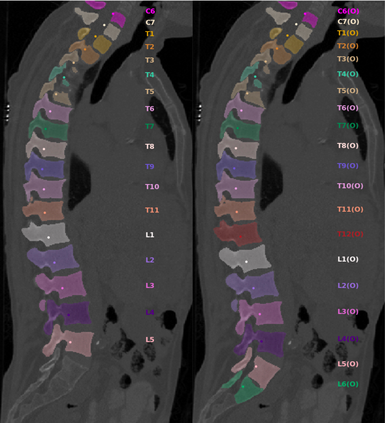

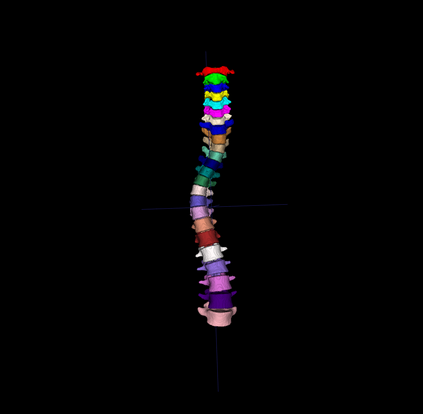

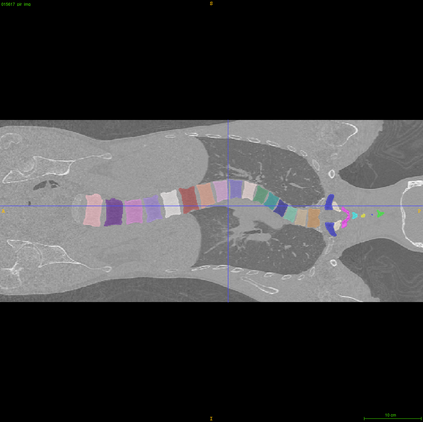

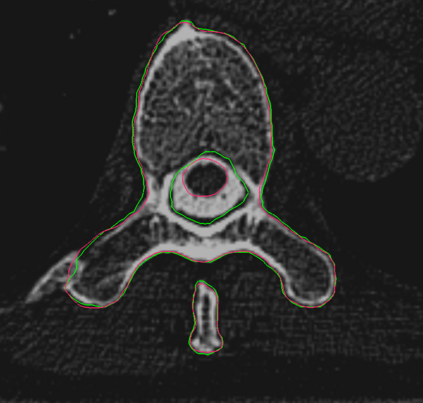

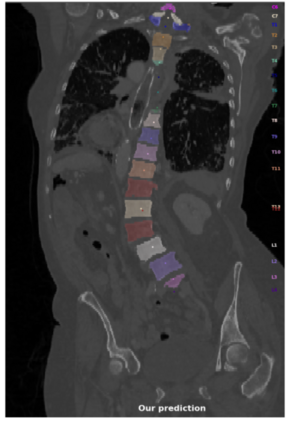

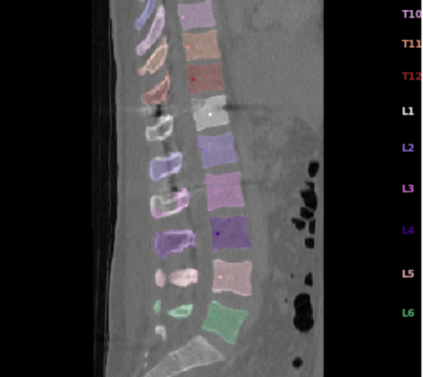

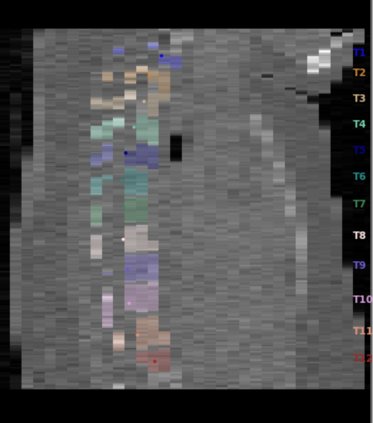

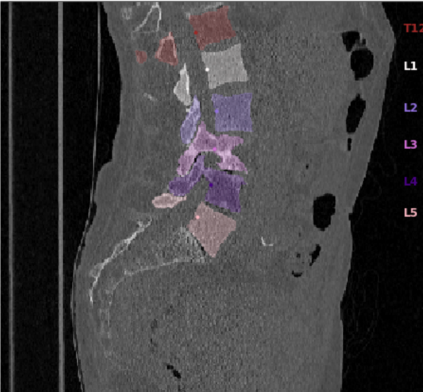

Vertebrae localization, segmentation and identification in CT images is key to numerous clinical applications. While deep learning strategies have brought to this field significant improvements over recent years, transitional and pathological vertebrae are still plaguing most existing approaches as a consequence of their poor representation in training datasets. Alternatively, proposed non-learning based methods take benefit of prior knowledge to handle such particular cases. In this work we propose to combine both strategies. To this purpose we introduce an iterative cycle in which individual vertebrae are recursively localized, segmented and identified using deep-networks, while anatomic consistency is enforced using statistical priors. In this strategy, the transitional vertebrae identification is handled by encoding their configurations in a graphical model that aggregates local deep-network predictions into an anatomically consistent final result. Our approach achieves state-of-the-art results on the VerSe20 challenge benchmark, and outperforms all methods on transitional vertebrae as well as the generalization to the VerSe19 challenge benchmark. Furthermore, our method can detect and report inconsistent spine regions that do not satisfy the anatomic consistency priors. Our code and model are openly available for research purposes.

翻译:在CT图象中,Verdebrae定位、分解和识别是许多临床应用的关键。虽然近年来深层次学习战略给该领域带来了显著的改进,但过渡性和病理脊椎仍然由于在培训数据集中的代表性不足而困扰着大多数现有方法。或者,拟议的非学习型方法利用先前的知识来处理这类特定案例。在这项工作中,我们提议将这两种战略结合起来。为此,我们引入了一个迭代周期,在这个周期中,个人脊椎通过深层次网络反复本地化、分解和识别,而解剖一致性则使用统计前期强制实施。在这一战略中,过渡性脊椎识别通过将其配置编码成一个图形模型来处理,将地方深网络预测汇总成解剖一致的最终结果。我们的方法在VerSe20挑战基准上取得了最新的结果,并超越了过渡性脊椎的所有方法,以及通用VerSe19挑战基准。此外,我们的方法可以用来检测和报告现有不一致性的脊椎研究。此外,我们的方法可以公开地测量和报告我们之前的脊柱形研究的目的。