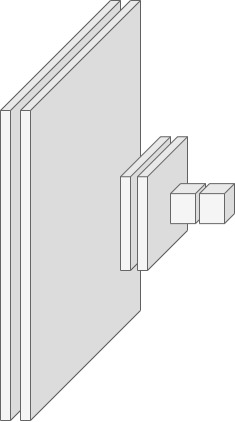

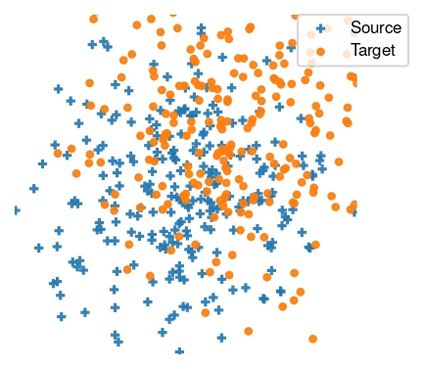

Unsupervised Domain Adaptation Regression (DAR) aims to bridge the domain gap between a labeled source dataset and an unlabelled target dataset for regression problems. Recent works mostly focus on learning a deep feature encoder by minimizing the discrepancy between source and target features. In this work, we present a different perspective for the DAR problem by analyzing the closed-form ordinary least square~(OLS) solution to the linear regressor in the deep domain adaptation context. Rather than aligning the original feature embedding space, we propose to align the inverse Gram matrix of the features, which is motivated by its presence in the OLS solution and the Gram matrix's ability to capture the feature correlations. Specifically, we propose a simple yet effective DAR method which leverages the pseudo-inverse low-rank property to align the scale and angle in a selected subspace generated by the pseudo-inverse Gram matrix of the two domains. We evaluate our method on three domain adaptation regression benchmarks. Experimental results demonstrate that our method achieves state-of-the-art performance. Our code is available at https://github.com/ismailnejjar/DARE-GRAM.

翻译:不监督领域适应回归(DAR)旨在解决回归问题中标记源数据集和未标记目标数据集之间的领域差距。最近的研究主要关注通过最小化源特征和目标特征之间的差异来学习深度特征编码器。在这项工作中,我们提出了一种不同的DAR问题的视角,通过分析深度领域自适应上线性回归器的闭式最小二乘~(OLS)解决方案来实现。我们提出的方法是对齐特征的逆 Gram 矩阵,这一方法由其在 OLS 解的存在和格矩阵捕获特征相关性的能力所驱动。特别地,我们提出了一种简单而有效的 DAR 方法,利用伪逆低秩特性,在由两个域的伪逆格矩阵生成的选择子空间中对齐比例和角度。我们在三个领域适应回归基准上评估了我们的方法。实验结果表明,我们的方法实现了最先进的性能。我们的代码可在 https://github.com/ismailnejjar/DARE-GRAM 上获得。