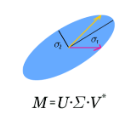

We introduce the Singular Value Representation (SVR), a new method to represent the internal state of neural networks using SVD factorization of the weights. This construction yields a new weighted graph connecting what we call spectral neurons, that correspond to specific activation patterns of classical neurons. We derive a precise statistical framework to discriminate meaningful connections between spectral neurons for fully connected and convolutional layers. To demonstrate the usefulness of our approach for machine learning research, we highlight two discoveries we made using the SVR. First, we highlight the emergence of a dominant connection in VGG networks that spans multiple deep layers. Second, we witness, without relying on any input data, that batch normalization can induce significant connections between near-kernels of deep layers, leading to a remarkable spontaneous sparsification phenomenon.

翻译:我们引入了单质值代表(Snular value Spresentation) (SVR) (SVD ) (SVR) (SVD ) (SVR) (SVR) (SVR) (SVR) (SVR) (SVR) ) (SVD ) (SVVD ) (SVD ) (SVVD ) (SVVD ) (SVD ) (SVD ) (SVD ) (SVD ) (SVIV) (S) (SVD) ) (S) (SVVD ) (SVD ) (SVD ) (SVD (SVD) (S) (SVD ) (SVD) (SVR) (S) (SVVVR) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (Snularent ) (Sing ) (S) (S) (S) (Snal ) (S) (S) (S) (S) (S) (S) (S) (S) (S ) (SVD (S) (S) (SVD (S) (SVD ) (S) (S) (S) (S) (S) (S) (SD ) (S) (S) (S) (S) (SD ) ) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (SVD) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (SVD ) (SVD) (S) (S) (SVD) (SVD) (S) (S) (S) (S) (S) (S) (S) (SD) (