【ICML2022】可解释的心理学理论

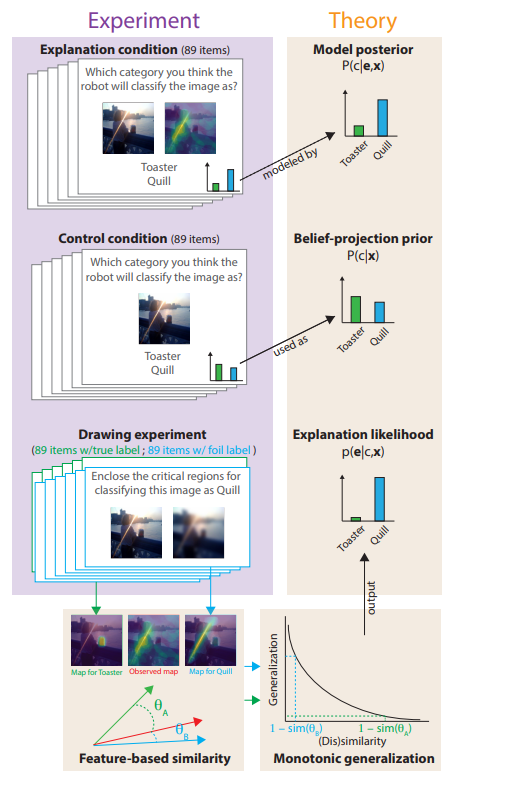

可解释人工智能(XAI)的目标是生成人类可解释的解释,但目前还没有计算精确的理论来解释人类如何解释人工智能生成的解释。理论的缺乏意味着XAI的验证必须在个案的基础上进行实证,这阻碍了XAI系统的理论建设。我们提出了一个关于人类如何从显著图(XAI解释的最常见形式)中得出结论的心理学理论,这首次允许在解释的条件下精确预测被解释推理。我们的理论假设,在缺乏解释的情况下,人类期望人工智能做出与自己类似的决定,他们通过与自己给出的解释进行比较来解释一种解释。比较是由认知科学中的经典理论——相似空间中的Shepard普遍概化定律形式化的。一项预先注册的带有显著图解释的AI图像分类用户研究表明,我们的理论在数量上与参与者对AI的预测相匹配。

https://www.zhuanzhi.ai/paper/87b1a3a6f02a70edcd51bf6449128f0f

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“APTE” 就可以获取《【ICML2022】可解释的心理学理论》专知下载链接

登录查看更多

相关内容

Arxiv

14+阅读 · 2022年7月26日