【ICML2022】Branchformer:并行MLP-Attention架构,捕捉局部和全局上下文,用于语音识别和理解

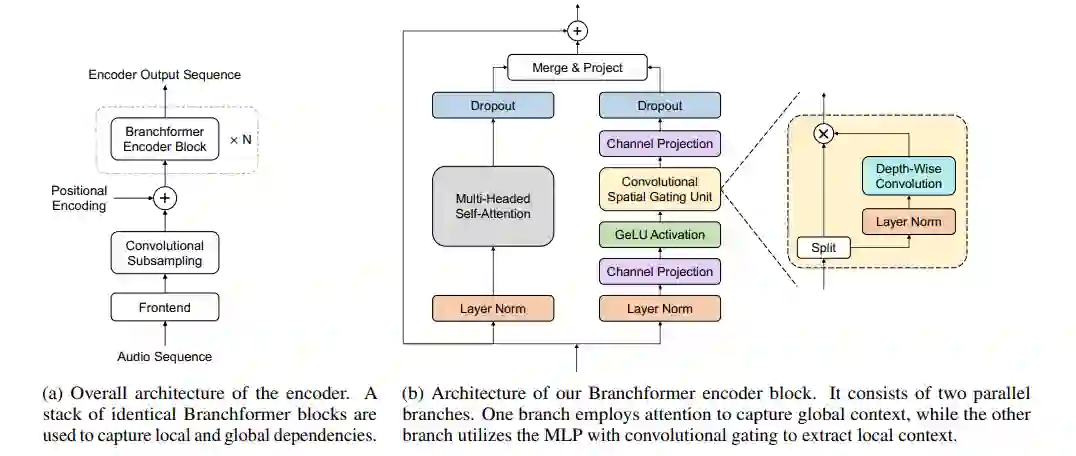

Conformer已被证明在许多语音处理任务中是有效的。它结合了使用卷积提取局部依赖项和使用自注意力提取全局依赖项的优点。受此启发,我们提出了一种更灵活、可解释和可定制的编码器备选方案——Branchformer,它具有并行分支,用于建模端到端语音处理中的各种范围依赖性。在每个编码器层中,一个分支使用自注意力或其变体来捕获远程依赖,而另一个分支使用带有卷积门控(cgMLP)的MLP模块来提取局部关系。我们对几个语音识别和口语理解基准进行了实验。结果表明,该模型的性能优于Transformer和cgMLP。它还匹配或优于Conformer取得的最先进的结果。此外,我们展示了多种策略来减少计算,这得益于双分支架构,包括在单个训练模型中具有可变推理复杂性的能力。为合并分支学习的权重表明如何在不同层中利用局部和全局依赖关系,这有利于模型设计。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BFME” 就可以获取《【ICML2022】Branchformer:并行MLP-Attention架构,捕捉局部和全局上下文,用于语音识别和理解》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年9月15日