学界 | 神经混合模型:提升模型性能,显著降低困惑度

选自arXiv

机器之心编译

参与:路雪、蒋思源

基于神经网络的语言模型能够学习不同的自然语言特征,性能也正在持续提升。萨尔大学在 ICASSP 2017 发表的论文中提出一种神经混合模型(NMM),该模型可以显著改善模型的性能,同时极大地降低困惑度。

论文:https://arxiv.org/abs/1708.06989

摘要:由于新架构的出现,基于神经网络的语言模型的性能正在平稳提高,能够学习不同的自然语言特征。本论文展示了一个新型框架,该框架表明在同一个架构中连接不同的异质模型(heterogeneous model)能够实现性能的显著改善。这通过特征层和混合层来实现:特征层(feature layer)单独学习基于神经网络的不同模型,混合层融合产生的模型特征。该架构受益于每个模型的学习能力,同时模型参数和训练时间没有显著的增长。大量基于 Penn Treebank(PTB)和 Large Text Compression Benchmark(LTCB)语料库的实验证明,与顶尖的前馈神经网络和循环神经网络架构相比,该新型框架极大地降低了困惑度(perplexity)。

图 1:神经混合模型(NMM)架构。红色箭头表示训练过程中错误的传播。

表 2:语言模型在 PTB 测试集上的表现。

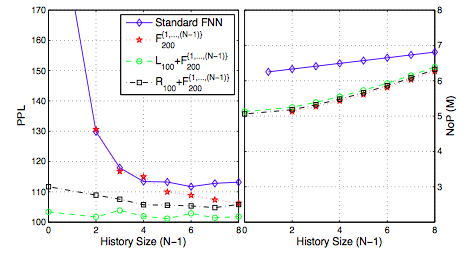

图 2:迭代地向不同的混合模型添加更多的 FNN 模型时,它们的困惑度和参数增长关系。

表 3:语言模型在 LTCB 测试集上的困惑度。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com