【业界】DeepMind提出速度提高千倍的并行WaveNet语音合成方法

点击上方“专知”关注获取专业AI知识!

【导读】DeepMind提出速度提高千倍的并行WaveNet语音合成方法。我们来一览这篇文章。(DeepMind Blog)

▌正文内容

在十月份,我们公布了迄今为止最先进的语音合成模型WaveNet,并将它用在谷歌语音助手中用来生成听起来像真人朗读一样的英语和日语。这种新的产品技术被称为并行的WaveNet (parallel WaveNet),这比原来版本的WaveNet的速度快1000倍以上并且能够产生出更高质量的音频。

我们最新的论文(Parallel WaveNet: Fast High-Fidelity Speech Synthesis)详细介绍了这个新模型,并且介绍了我们开发的能够使系统在大规模并行计算环境中工作的“概率密度蒸馏”技术。

原版的WaveNet模型使用自回归关系来在一段时间内合成波形的一个样本,因此每一个新的样本都取决于在它之前一个的样本。虽然这种方法每秒能产生高达24000个样本的音频,但是将这种序列生成方法用在实际的产品中还是太慢了。

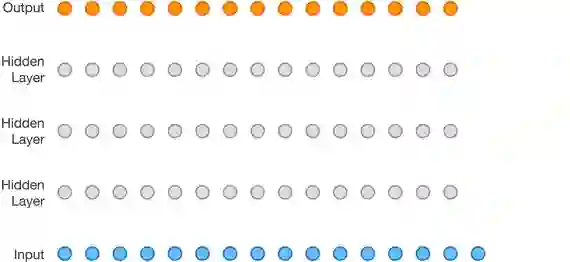

图1 原版WaveNet逐个生成波形样本

为了解决这个产生效率的问题,我们需要一种能够生成较长序列,有能保持高质量的解决方案。我们的方法称为概率密度蒸馏,我们用一个已经训练好的的WaveNet模型当成导师来教学生,而“学生”是一种更小更平行的网络,因此会更适合现代计算硬件。这个学生网络是一个较小的扩张卷积神经网络,类似于原来的WaveNet。但关键的一点是,每个样本的生成不依赖于任何先前生成的样本,这意味着我们可以同时生成第一个和最后一个词,以及两者之间的所有内容,如下面的动画所示。

图2 新WaveNet模型使用白噪声为输入,并行合成所有样本

在训练过程中,学生网络开始时处于随机状态。给予它随机白噪声作为该网络的输入,它的任务就是产生连续的音频波形来输出。生成的波形送入训练wavenet模型,给每个样本打分,每个样本给学生网络一个信号,了解它是距离教师网络的期望输出有多远。经过一段时间,该学生网络可以通过反向传播来学习它应该产生什么声音。另一方面,教师和学生都为每个音频样本的值输出了一个音频采样值的概率分布,这个训练的目的是尽量减少教师分布与学生分布之间的KL散度。

该训练过程中,教师扮演生成器,学生作为判别器,这种训练方法类似于生成对抗网络的设置(GANs)。然而,不像生成对抗网络那样,学生的目标不是让老师变“傻”,而是合作并尝试匹配教师的表现。

虽然训练技术很有效,但我们还需要增加一些额外的损失函数来引导学生达到预期。具体来说,我们增加了一种感知损失参数来避免发音错误,增加了对比损失以进一步降低噪音,增加了功率损失来帮助匹配人类讲话的能量。比如,如果没有后者,受过训练的模型耳语语音不会变为大声喧哗的语音。

所有这些的加入帮助我们培养出并行WaveNet,实现言论的质量相同的原WaveNet,如平均意见得分所示(MOS),根据听众的测试来衡量发音的自然程度划分为1-5级。注意,即使是人类语言,在MOS尺度上也仅为4.667。

当然,概率密度蒸馏的发展只是让WaveNet满足速度和质量需求的步骤之一。将并行WaveNet进入谷歌助手服务线上同样需要DeepMind应用和谷歌演讲团队大量的工程工作。只有通过共同努力,我们才能在12个多月内从基础研究转向谷歌规模的产品。

论文:

ParallelWaveNet: Fast High-Fidelity Speech Synthesis

链接:

https://deepmind.com/documents/131/Distilling_WaveNet.pdf

DeepMind博客文章:

https://deepmind.com/blog/high-fidelity-speech-synthesis-wavenet/

原版WaveNet论文:

https://arxiv.org/pdf/1609.03499.pdf

(附上专知内容组翻译的摘要,有错误和不完善的地方,请大家提建议和指正)

▌摘要

最近提出的WaveNet结构是现在最先进的真实语音合成方法,合成的结果一直被认为比以前的任何系统听起来都更自然一些。但是由于WaveNet模型用自回归连接来一个样本一个样本地合成声音波形,每一个新样本受前一个样本制约,所以它不适合当今大规模并行计算机,因此很难在实际应用中部署设置。

本文介绍了被称为概率密度蒸馏(sProbability Density Distillation)的一种新方法,它从训练好的WaveNet中再训练一个并行的前馈网络,而产生的结果质量跟原版的WaveNet每什么差别,但是由此产生的系统能够产生高保真度语音采样速度比以前快了20倍以上,并已经部署通在谷歌助理上,用来生成像英语和日语等语言的高质量人声。

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃集合】人工智能领域主题知识资料全集[ 持续更新中](入门/进阶/论文/综述/视频/专家等,附查看)

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请关注我们的公众号,获取人工智能的专业知识。扫一扫关注我们的微信公众号。

请扫描专知小助手,加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等,或者加小助手咨询入群)交流~

点击“阅读原文”,使用专知!