论文题目:

Latent Relation Language Models

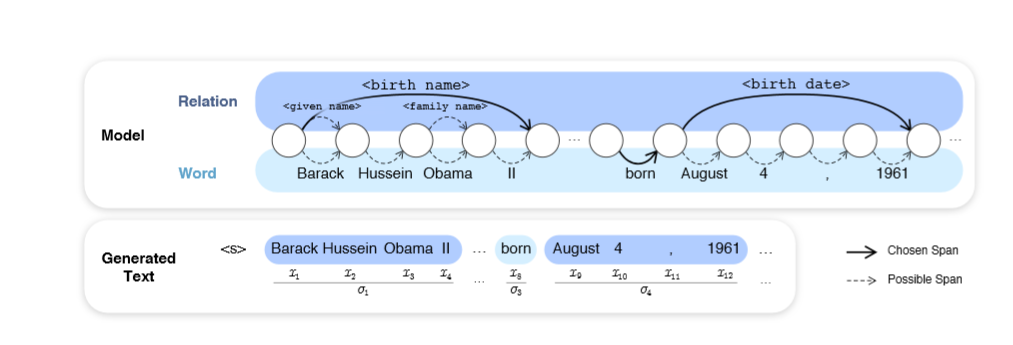

论文摘要: 在本文中,我们提出了潜在关系语言模型(LRLM),它是一类语言模型,它通过知识图的关系参数化文档中单词和其中出现的实体的联合分布。 该模型具有许多吸引人的属性:它不仅提高了语言建模性能,而且还能够注释实体跨度对于关联文本的后验概率。 实验表明,在基于单词的基准语言模型和结合了知识图谱信息的先前方法上,经验性改进。 定性分析进一步证明了该模型在上下文中学习最佳预测适当关系的能力。

成为VIP会员查看完整内容

相关内容

知识图谱(Knowledge Graph),在图书情报界称为知识域可视化或知识领域映射地图,是显示知识发展进程与结构关系的一系列各种不同的图形,用可视化技术描述知识资源及其载体,挖掘、分析、构建、绘制和显示知识及它们之间的相互联系。

知识图谱是通过将应用数学、图形学、信息可视化技术、信息科学等学科的理论与方法与计量学引文分析、共现分析等方法结合,并利用可视化的图谱形象地展示学科的核心结构、发展历史、前沿领域以及整体知识架构达到多学科融合目的的现代理论。它能为学科研究提供切实的、有价值的参考。

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

78+阅读 · 2020年5月11日

专知会员服务

108+阅读 · 2020年3月29日

专知会员服务

64+阅读 · 2020年1月11日

Arxiv

7+阅读 · 2018年5月24日

Arxiv

7+阅读 · 2018年4月6日

Arxiv

8+阅读 · 2018年2月6日