注意力能提高模型可解释性?实验表明:并没有

作者:Sarthak Jain

编辑:机器之心编辑部,Nurhachu Null、张倩参与

转载申明:本文经机器之心(微信公众号:almosthuman2014)授权转载,禁止二次转载

自然语言处理中有一种普遍的观点:注意力机制可以提高模型的可解释性,但这一观点经得起检验吗?本文作者通过实验证明:标准的注意力模块在解释模型方面基本没什么卵用。

注意力机制(Bahdanau et al., 2014)引入了输入单元的条件分布来为下游的模块形成一个权重语境向量。这在神经自然语言处理结构中几乎是普遍的存在。注意力权重通常(明确地或者隐式地)被认为能够提供关于模型「内部工作机理」的信息:对一个给定的输出,你可以检查到模型分配了较大注意力权重的输入。Li 等人(2016)总结了这一在自然语言处理中普遍持有的观点:「注意力机制为神经模型的工作方式提供了一种重要的解释方式」。事实上,注意力可以提供模型解释的说法在文献中是很常见的。

其中隐含的假设是高注意力权重对应的输入单元(例如单词)会对模型的输出造成影响。但是据目前所知,这个假设并没有被正式地评估过,而且本文作者发现这一假设是有问题的。具体而言,他们通过实验研究了注意力权重、输入和输出之间的关系。

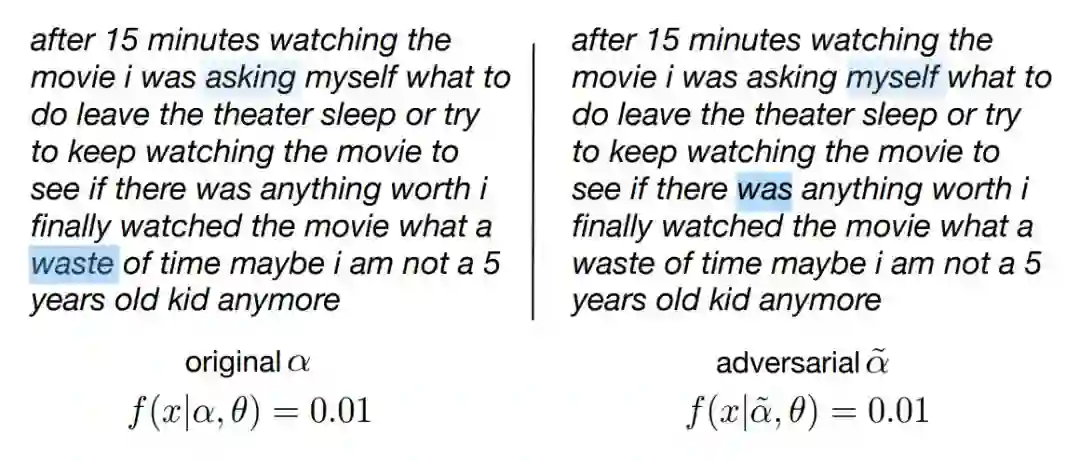

看一下图 1,左边是使用标准的注意力 BiLSTM 架构对某部电影的影评做情感分析得到的在单词上的原始注意力分布α。似乎很有可能从中得出结论:单词「waste」是模型倾向于判断为「negative,差评」(y^=0.01)的主要原因。但是也可以构建另一个注意力分布α~(右图),它注意到了完全不同的单词,但是得到了基本一样的预测结果(保持 f 的其他参数θ为常数)。

图 1:一个负面电影评论的注意力权重热力图。该图展示了所观察到的模型的注意力(左)和一个对照组的注意力权重(右)。尽管注意力很不相似,但是两者都有效地产生了相同的预测(0.01)。

这种反事实的分布意味着,通过突出注意到的 token 来解释原始的预测是有误导性的。例如,现在可以从右图中得到这样的结论:模型的输出主要是由于单词「was」;但是「waste」和「was」无法同时成为原因。此外,这种情况下的注意力权重与基于梯度的特征重要性度量只存在微弱的相关性(τg = 0.29)。并且,任意置换α中的元素就能得到与原始预测的中值差异为 0.006 的结果。

这些结果以及类似的发现都使人们对「注意力能为模型的预测提供有意义的解释」这一观点产生质疑。因此作者提醒我们不要使用注意力权重来强调对模型输出「负责」的输入 token,并将其作为理所应当的基础。

作者对这些问题的研究结果如下:(1)注意力只能为模型的预测提供微弱的解释,而且并不总是一致的;(2)这通常很可能构建「对立的」注意力分布。当使用最初引入的注意力权重时,它能够得到等价的预测,即使是注意到了完全不同的输入特征。甚至更令人印象深刻的是,随机置换注意力权重通常只会导致输出的微小变化。

论文:Attention is not Explanation

论文链接:https://arxiv.org/abs/1902.10186v1

摘要:注意力机制在神经自然语言处理中得到了广泛的采用。除了能够提升预测的性能,它们通常被吹捧能够提高模型的透明度:即具有注意力的模型提供了在输入单元上的注意力分布,并且这通常被呈现为(至少是隐含地说明)表达了输入的相对重要性。但是,注意力权重和模型输出之间到底存在什么样的关系并不明确。在这篇论文中,我们在各种自然语言处理任务上开展了广泛的实验,这些任务旨在评估注意力权重能够对预测提供何种程度上的有意义的「解释」。我们发现注意力权重基本上是做不到的。例如,学习到的注意力权重通常与基于梯度的特征重要性度量是没有关联的,而且我们可以发现非常不同的注意力分布,它们可以带来同样的预测。我们的研究结果表明,标准的注意力模块并没有提供有意义的解释。所有实验的代码参见:

https://github.com/successar/AttentionExplanation。

4. 实验

我们进行了一系列实验来检查学习到的注意力权重的经验属性,确认它们的可解释性和透明性。关键的问题是:学习到的注意力权重是否和特征重要性的自然度量是一致的?此外,如果我们注意到了不同的特征,预测结果会不同吗?

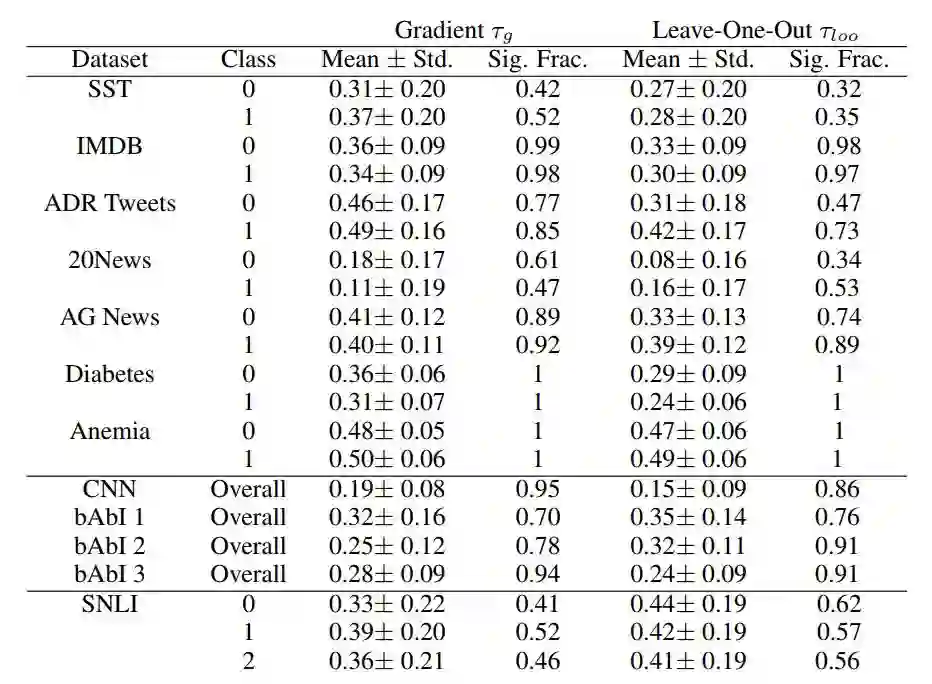

我们以两种方式实验性地表征了注意力权重和对应的特征重要性得分之间的关联:(1)基于梯度的特征重要性度量(τg);(2)忽略了一些特征((τloo))之后模型输出的不同。

表 2 是每个数据集中的 Kendall 相关系数τ的统计结果

表 2:梯度和 LOO(leave-one-out)的重要性度量和注意力权重的均值、标准差、方差。Sig. Frac. 列指的是这种关联在统计上确实是重要的例子的比例。

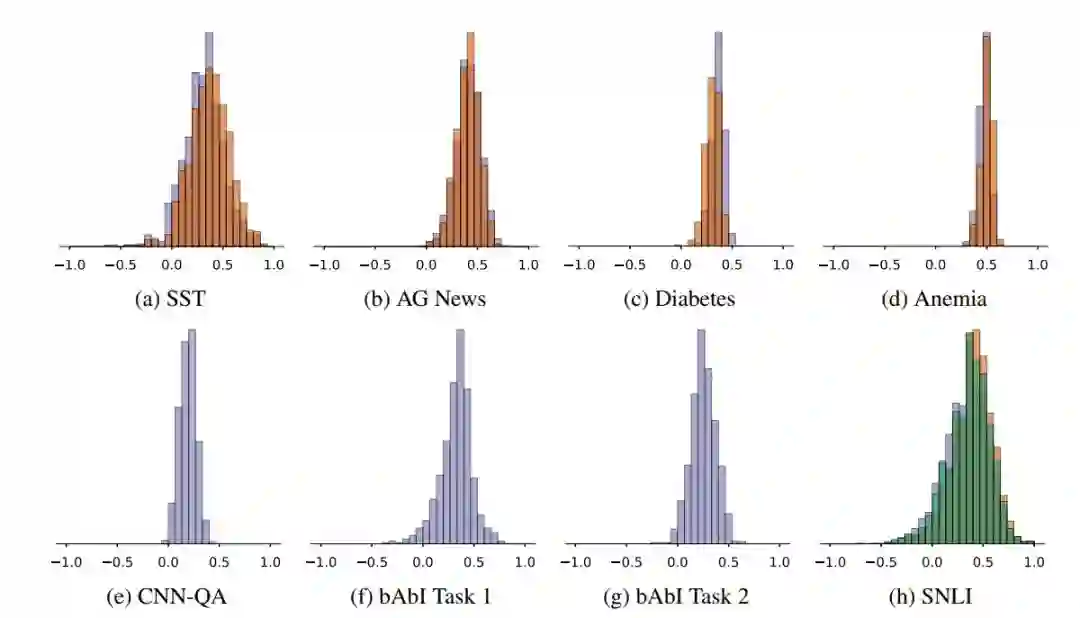

图 2:注意力和梯度之间的 Kendall 系数τ。颜色代表的是预测类别。

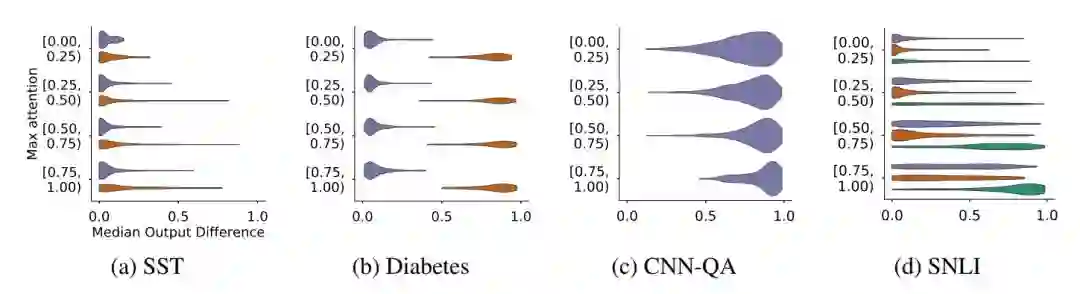

图 3 描述的是数据集中的样本中原始注意力αˆ的最大值和模型输出的中位诱导变化 (∆ˆy med) 之间的关系。如上所示,颜色还是代表预测类别。

图 3:输出的中位数变化∆ˆymed (X 轴) 密度与随机置换注意力权重得到的最大注意力 (max ˆα) (Y 轴) 是相关的。

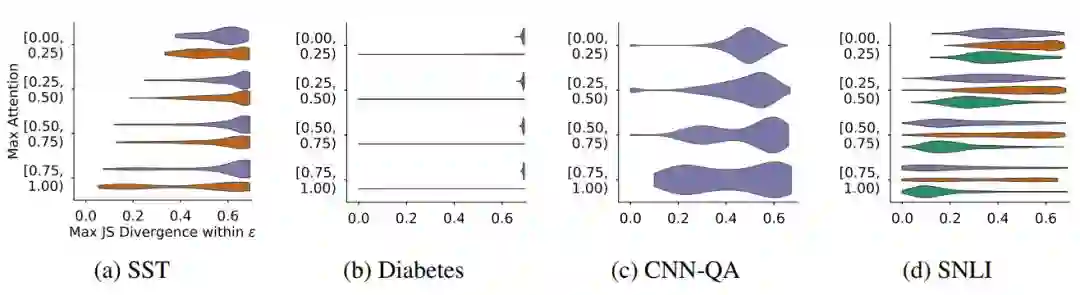

图 5 表明,虽然这种结果存在负面效应,但是事实上比较微弱。换种方式说:在这所有的数据集中存在很多案例,尽管具有较高的注意力权重,但是不同的注意力配置最终会得到相同的结果。

图 5:最大 JS 散度的(max JSD)密度,它是每个从原始注意力和对抗注意力权重中得到的例子的最大注意力(Y 轴)的一个函数。

推荐阅读

基础 | TreeLSTM Sentiment Classification

原创 | Simple Recurrent Unit For Sentence Classification

原创 | Attention Modeling for Targeted Sentiment

欢迎关注交流

欢迎关注交流