![]()

作者 | 蒋宝尚

编辑 | 丛 末

图像翻译目的是用模型将源域图像转换到目标域图像,通常涉及标签图到场景图的转换、图像风格、人脸的属性变换、标签图到场景图的转换。

图像翻译任务自生成对抗网络提出就得到了快速发展,例如经典的pix2pix、CycleGAN、StarGAN。

上述模型

虽然实现了从源域图像到目标域图像的转换,但也需要一定的标签参与或者需要建立源域和目标域各自的生成器。

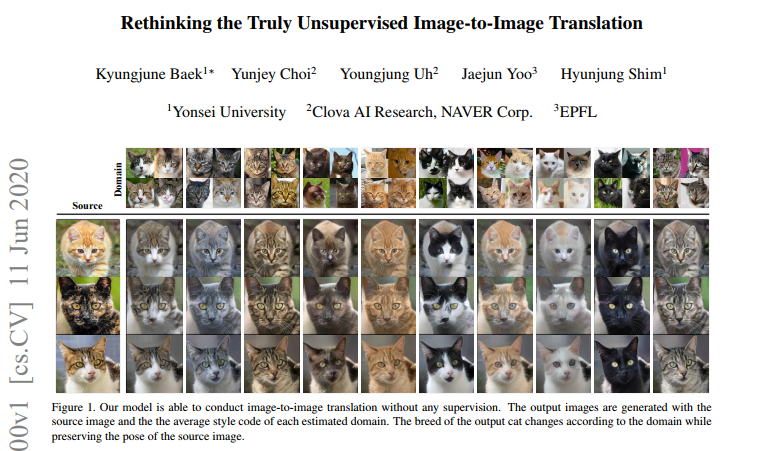

而近日韩国延世大学的一篇名为《Rethinking the Truly Unsupervised Image-to-Image Translation》的论文号称实现了

真正的“无监督”学习

。

![]() 论文地址:https://arxiv.org/pdf/2006.06500.pdf

论文的导语部分提到,近期的图像到图像的一些模型都至少使用了图像级别(输入输出对(input-output pairs))或者集合级别(set-level)(域标签)监督中的一种。后者往往被称为“无监督”,而这种方法还有一个重要的假设:域标签是先验的。

在论文中作者提出了一种真正无监督的图像到图像转换方法(truly unsupervised image-to image translation method,TUNIT),

此方法既不需要“输入输出对”也不需要域标签。

其通过信息理论方法学习分离图像域,并使用估计的域标签生成相应的图像。

另外,作者在不同数据集上对比了FUNIT和MSGAN这俩最先进的多域和跨域图像到图像的翻译模型。实验结果表明,作者提出的方法能成功地实现域的分离和跨域的图像翻译。在半监督环境下,作者也声称其方法的性能优于当前现有的集合级监督方法。

论文地址:https://arxiv.org/pdf/2006.06500.pdf

论文的导语部分提到,近期的图像到图像的一些模型都至少使用了图像级别(输入输出对(input-output pairs))或者集合级别(set-level)(域标签)监督中的一种。后者往往被称为“无监督”,而这种方法还有一个重要的假设:域标签是先验的。

在论文中作者提出了一种真正无监督的图像到图像转换方法(truly unsupervised image-to image translation method,TUNIT),

此方法既不需要“输入输出对”也不需要域标签。

其通过信息理论方法学习分离图像域,并使用估计的域标签生成相应的图像。

另外,作者在不同数据集上对比了FUNIT和MSGAN这俩最先进的多域和跨域图像到图像的翻译模型。实验结果表明,作者提出的方法能成功地实现域的分离和跨域的图像翻译。在半监督环境下,作者也声称其方法的性能优于当前现有的集合级监督方法。

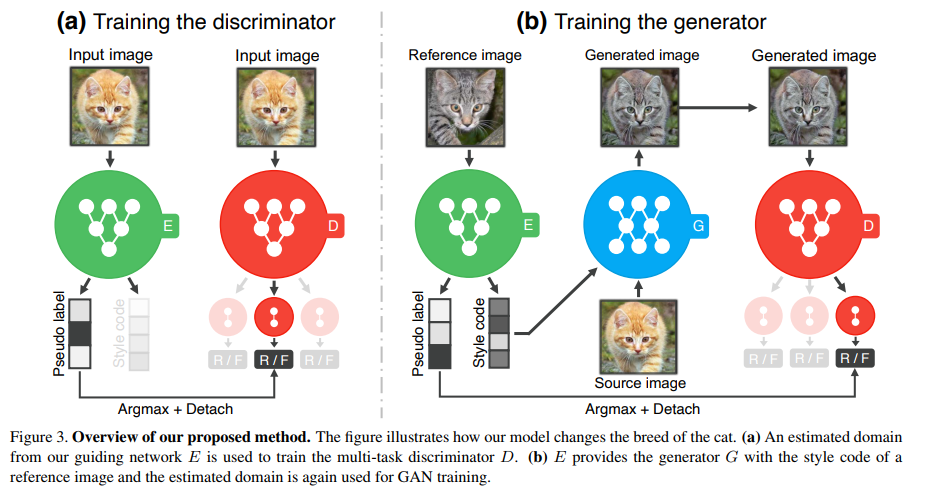

图注:方法概述如上,上图说明了模型转换猫品种的过程:1.使用引导网络的估计域训练多任务鉴别器;2.引导网络为生成器提供参考图像( reference image )的样式代码。另外,估计域再次用于GAN训练。

具体而言,作者通过三个子问题来解决这一问题:

1)区分图像(即域)的集合特征;2)对输入图像的个别内容和风格进行编码;3)学习估计域之间的映射函数

。

另外,作者引入了一个引导网络(guiding network),从而提供用于识别器和生成器的伪域标签和编码风格特征。为了估计域标签,作者还采用了一种能够最大化图像的域分配与其增强版本之间相互信息(mutual information)的无监督方法。这有助于引导网络将相似的图像分组在一起,并同时均匀地分隔类别。另外,通过参与图像翻译过程,引导网络还可以利用来自生成器和鉴别器的梯度。

注:增强版本是对指对原图像随机裁剪、水平翻转之后生成的图像。

对于嵌入风格码,作者采用了对比损失,其使得模型能够更好地理解图像之间的差异性,从而更好地进行表示学习。另外,引导网络和对抗性网络之间的交互,也让模型成功地分离域和翻译图像。

前面也提到,

引导网络有两个作用,其一是将风格代码(style code)提供给生成器,其二是将伪域标签提供给鉴别器来指导翻译

。另外,生成器还会根据鉴别器的反馈合成目标域的图像,同时尊重参考图像的风格(例如毛皮图案)保持源图像的内容(例如姿势)。

主要的方法有两个部分,

第一是学习如何产生域标签以及编码风格特征

。

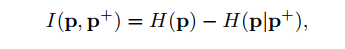

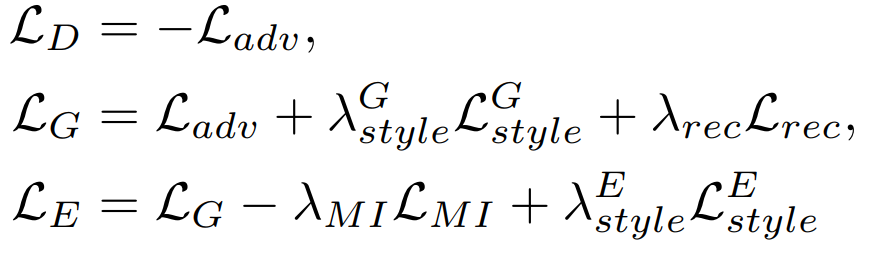

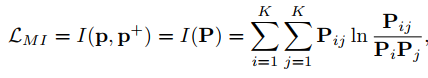

在这一部分中作者使用无监督聚类方法自动产生给定图像的域标签,也就是前面所说的最大化图像的域分配与其增强版本之间相互信息。公式如下:

其中

![]() 为:

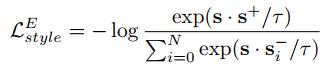

虽然L_MI提供了一种自动生成输入图像的域标签方法,但是当图像的分辨率高于64x64或样本变得复杂多样时它无法放大。因此我们作者向引导网络中添加辅助支路Estyle并施加对比损耗来克服这一点,公式如下:

第二部分是域引导下的图像到图像的翻译

。这部分是为了解决翻译模式应该提供包含目标域视觉特征的逼真图像。为此作者采用了三种损失:1)对抗性损失以生成逼真的图像;2)风格对比损失以鼓励模型不忽略风格代码;3)图像重建损失以保持域不变特征。

其中,对于对抗性损失训练,作者采用多任务鉴别器,其设计目的是同时对每个领域进行歧视(discrimination)。然后仅利用估计输入图像的域的损失来计算其梯度。

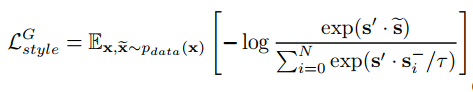

另外,为了防止出现生成器忽略给定的风格代码而合成域的随机图像的退化情况,对生成器施加的风格对比损失函数如下:

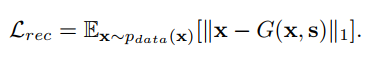

为了保证生成器在给定其原始风格时可以重建源图像,其施加图像重建损失为:

上述公式不仅能保证生成器可以保留其输入图像的域不变性特征(例如,姿态),而且还有助于通过提取源图像的原始风格来学习引导网络的风格表示。

为:

虽然L_MI提供了一种自动生成输入图像的域标签方法,但是当图像的分辨率高于64x64或样本变得复杂多样时它无法放大。因此我们作者向引导网络中添加辅助支路Estyle并施加对比损耗来克服这一点,公式如下:

第二部分是域引导下的图像到图像的翻译

。这部分是为了解决翻译模式应该提供包含目标域视觉特征的逼真图像。为此作者采用了三种损失:1)对抗性损失以生成逼真的图像;2)风格对比损失以鼓励模型不忽略风格代码;3)图像重建损失以保持域不变特征。

其中,对于对抗性损失训练,作者采用多任务鉴别器,其设计目的是同时对每个领域进行歧视(discrimination)。然后仅利用估计输入图像的域的损失来计算其梯度。

另外,为了防止出现生成器忽略给定的风格代码而合成域的随机图像的退化情况,对生成器施加的风格对比损失函数如下:

为了保证生成器在给定其原始风格时可以重建源图像,其施加图像重建损失为:

上述公式不仅能保证生成器可以保留其输入图像的域不变性特征(例如,姿态),而且还有助于通过提取源图像的原始风格来学习引导网络的风格表示。

在实验部分,一共进行了三个,分别是分析目标函数和训练策略的效果、在三个未标记的数据集上进行无监督的图像到图像的翻译、在半监督监督环境下与最先进的(SOTA)技术的比较。

在训练策略效果实验中,作者选择了AnimalFaces 10数据集,并验证了引入引导网络中的对抗损失能够提高模型的整体翻译性能。通过对训练策略的研究,证实了引导网络与GAN之间的互动确实提高了翻译效果。

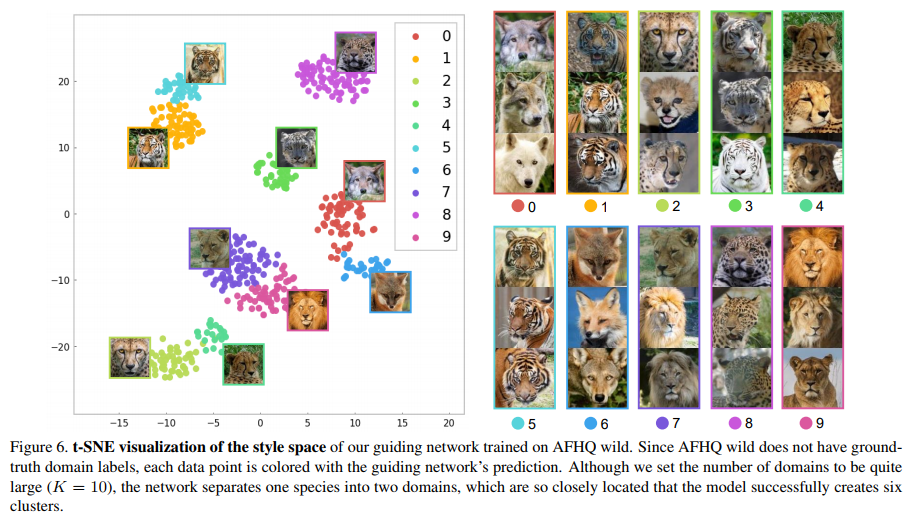

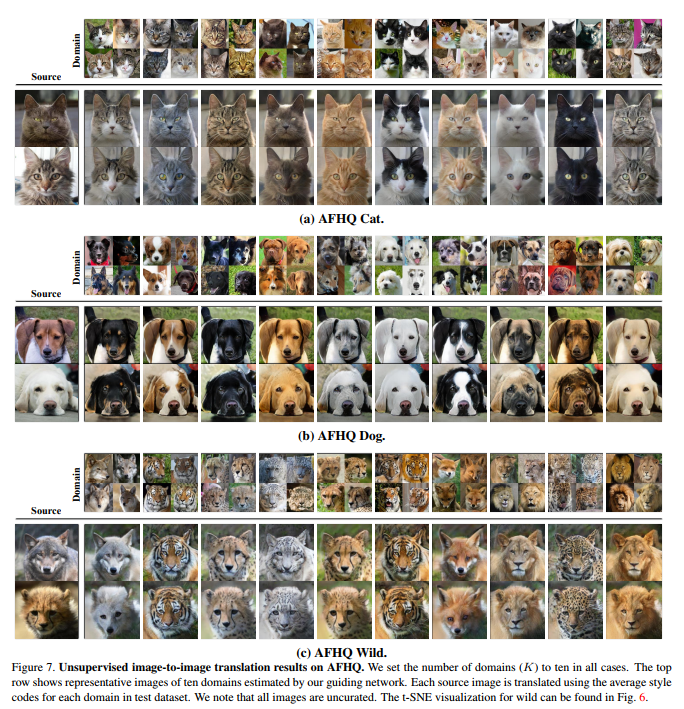

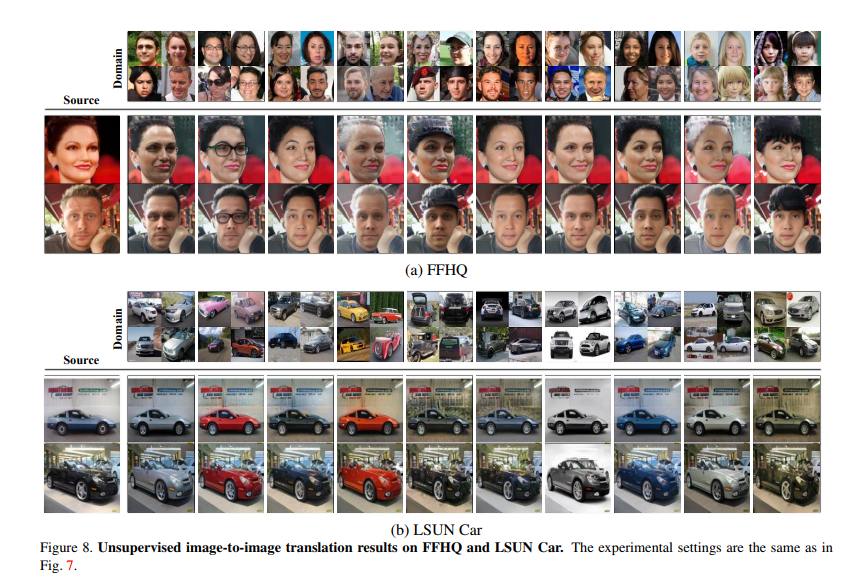

作者为了研究所提出的方法能够处理无监督的图像到图像的翻译,在AFHQ、FFHQ和LSUN CAR数据集上对模型进行了评估。整体结果如下图:

上图是在AFHQ野生类上训练的引导网络的t-SNE结果和来自每个域的示例图像。

上图是定性的图像翻译结果,每幅图像由源图像和每个域中所有测试图像的平均风格码码合成。可以清晰的看出,每个输出都成功地反映了每个领域的视觉特征(即毛皮图案和颜色)以及其物种的视觉特征。

FHQ和LSUN CAR的结果如图8所示。虽然还不清楚如何在FFHQ中定义“域”,但该网络成功地将图像分成了视觉上不同的类别,如眼镜、发色和刘海。

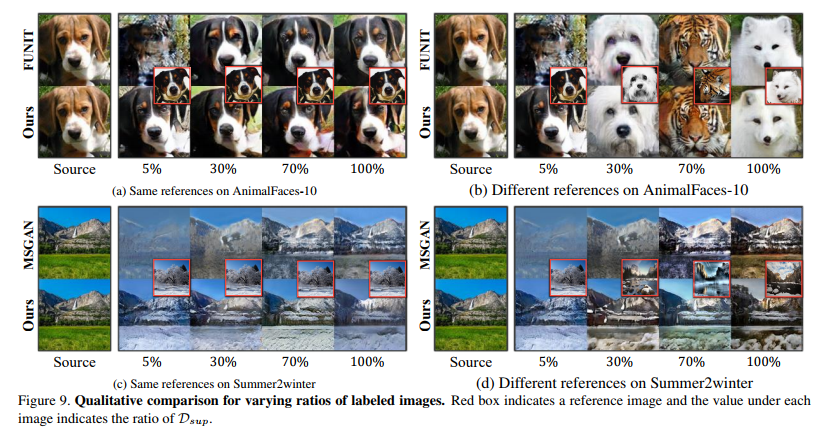

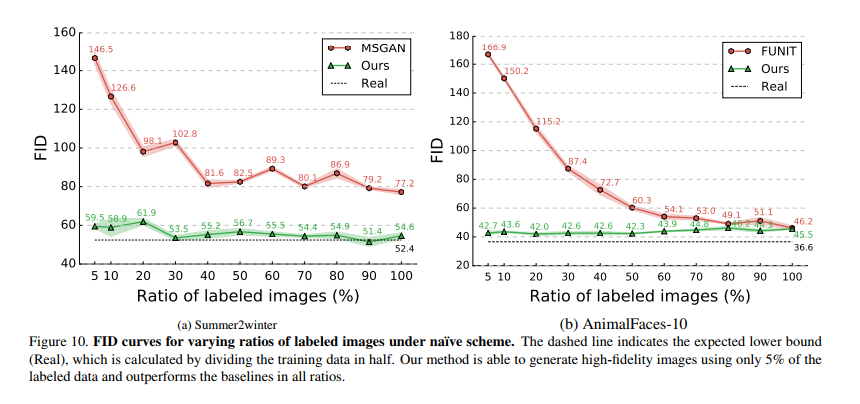

作者的第三个实验是与半监督学习环境下在两种方案下训练的最先进的翻译模型进行比较。如下图,展示了与使用朴素方案训练的基线之间的定性比较。

下图分别展示了在Summer2wendor和AnimalFaces-10上使用class-wise FID的定量结果。随着比值(γ)的降低,基线模型的性能显著下降,而作者提出的模型无论γ如何,都将FID值维持在60和45左右。

AI 科技评论希望能够招聘 科技编辑/记者 一名

办公地点:北京

职务:以跟踪学术热点、人物专访为主

工作内容:

1、关注学术领域热点事件,并及时跟踪报道;

2、采访人工智能领域学者或研发人员;

3、参加各种人工智能学术会议,并做会议内容报道。

要求:

1、热爱人工智能学术研究内容,擅长与学者或企业工程人员打交道;

2、有一定的理工科背景,对人工智能技术有所了解者更佳;

3、英语能力强(工作内容涉及大量英文资料);

4、学习能力强,对人工智能前沿技术有一定的了解,并能够逐渐形成自己的观点。

感兴趣者,可将简历发送到邮箱:jiangbaoshang@yanxishe.com

点击"阅读原文",直达“CVPR 交流小组”了解更多会议信息。

论文地址:https://arxiv.org/pdf/2006.06500.pdf

论文地址:https://arxiv.org/pdf/2006.06500.pdf

为:

为: