普林、DeepMind新研究:结合深度学习和符号回归,从深度模型中看见宇宙

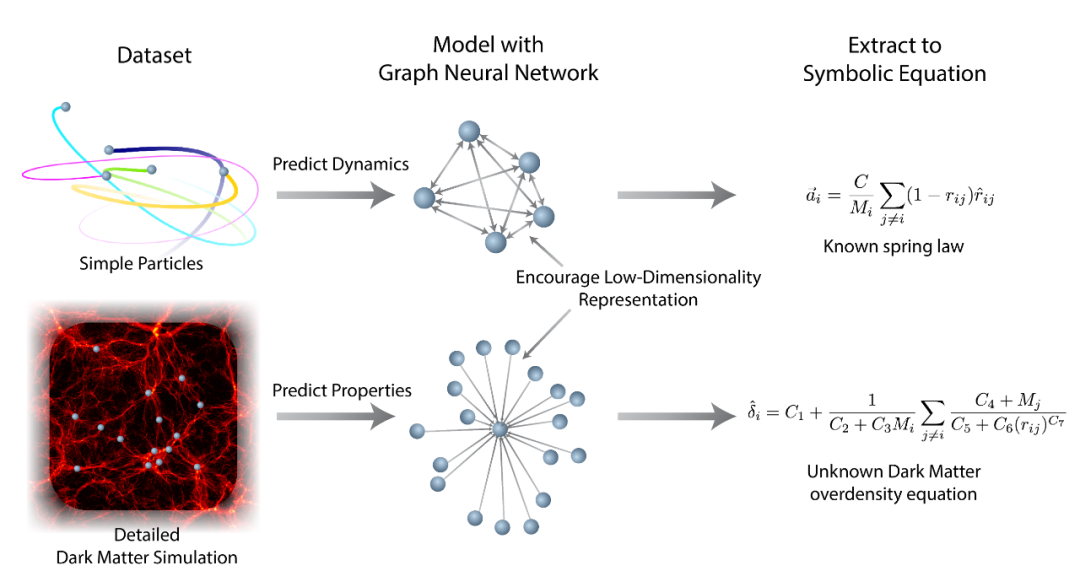

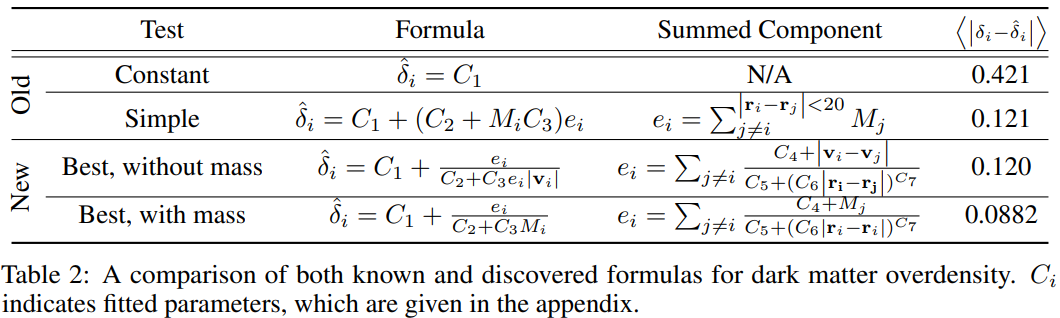

简单的符号表达式能够有效地建模世界。符号模型紧凑,具备可解释性和良好的泛化能力,但很难处理高维机器学习问题;深度模型擅长在高维空间中学习,但泛化性和可解释性却很差。那么有没有什么办法可以取二者之所长呢?这项研究做到了。

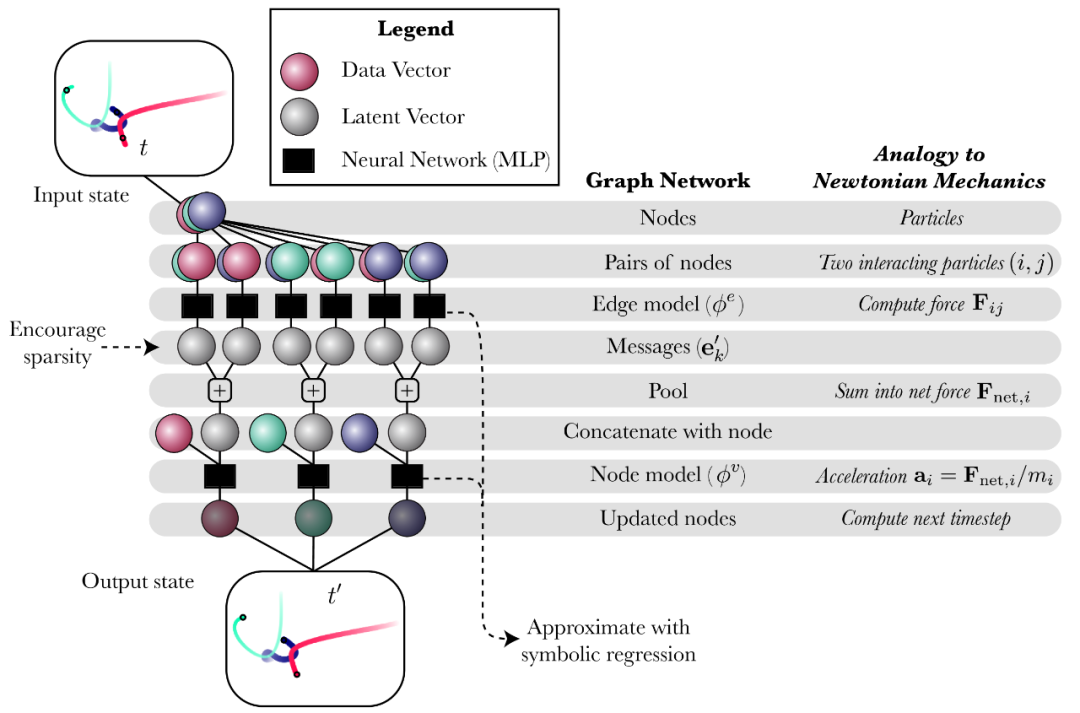

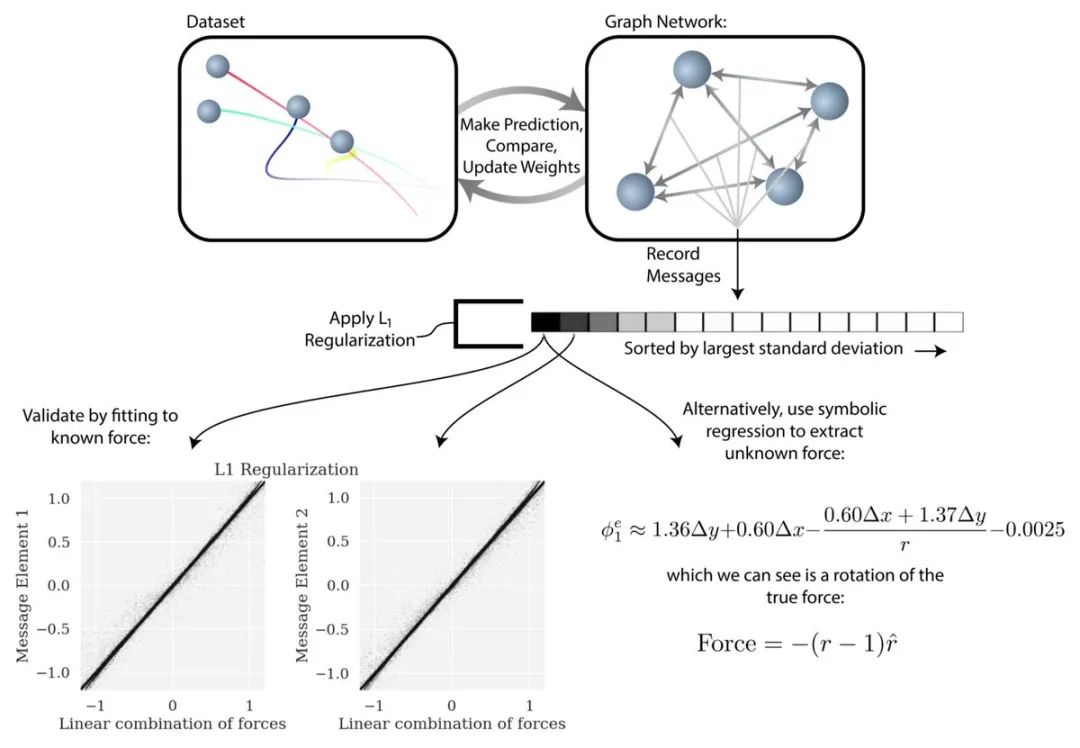

设计一个深度学习模型,它具有可分离的内部结构和由问题引发的归纳偏置;

使用可用数据对模型进行端到端训练;

在训练过程中,鼓励每个内部函数输入或输出中的潜在表示保持稀疏性;

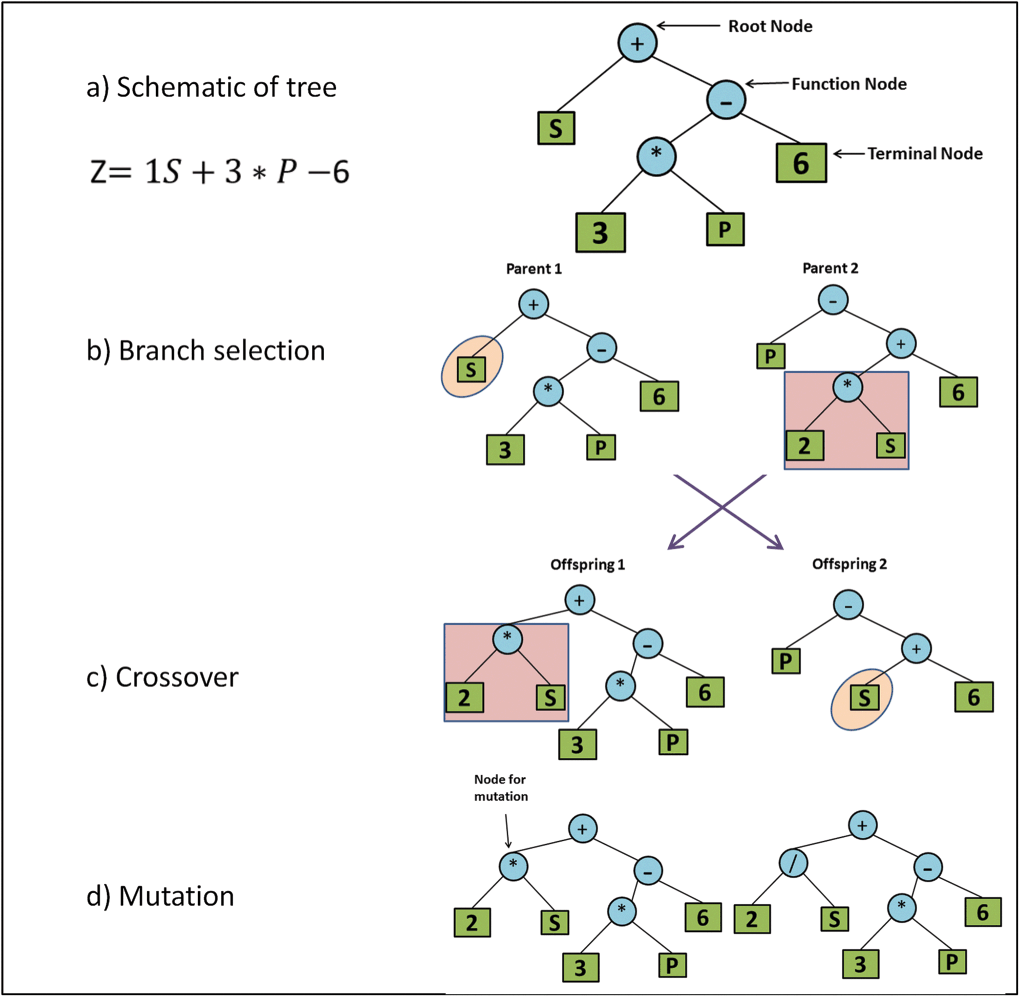

用符号表达式拟合模型内部学得的不同函数;

以等价的符号表达式替换深度模型中的这些函数。

论文地址:https://arxiv.org/pdf/2006.11287.pdf

博客地址:https://astroautomata.com/paper/symbolic-neural-nets/

GitHub 地址:https://github.com/MilesCranmer/symbolic_deep_learning

交互式 demo 地址:https://colab.research.google.com/github/MilesCranmer/symbolic_deep_learning/blob/master/GN_Demo_Colab.ipynb

登录查看更多

相关内容

专知会员服务

37+阅读 · 2020年2月27日

Arxiv

5+阅读 · 2018年7月11日