【泡泡一分钟】城市驾驶环境中使用道路环境进行车辆检测、追踪及行为分析

每天一分钟,带你读遍机器人顶级会议文章

标题:Vehicle Detection, Tracking and Behavior Analysis in Urban Driving Environments using Road Context

作者:Shashwat Verma, You Hong Eng, Hai Xun Kong, Hans Andersen, Malika Meghjani, Wei Kang Leong, Xiaotong Shen, Chen Zhang, Marcelo H. Ang Jr., and Daniela Rus

来源:2018 IEEE International Conference on Robotics and Automation (ICRA)

编译:明煜航

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

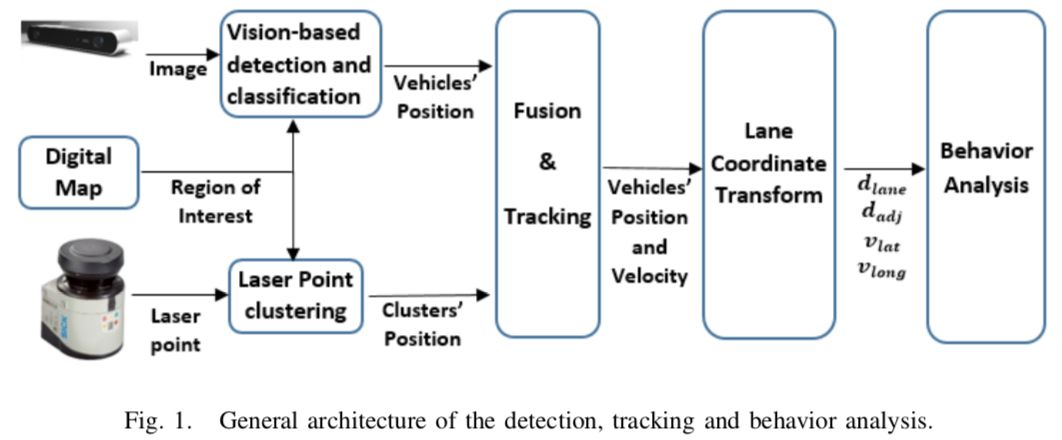

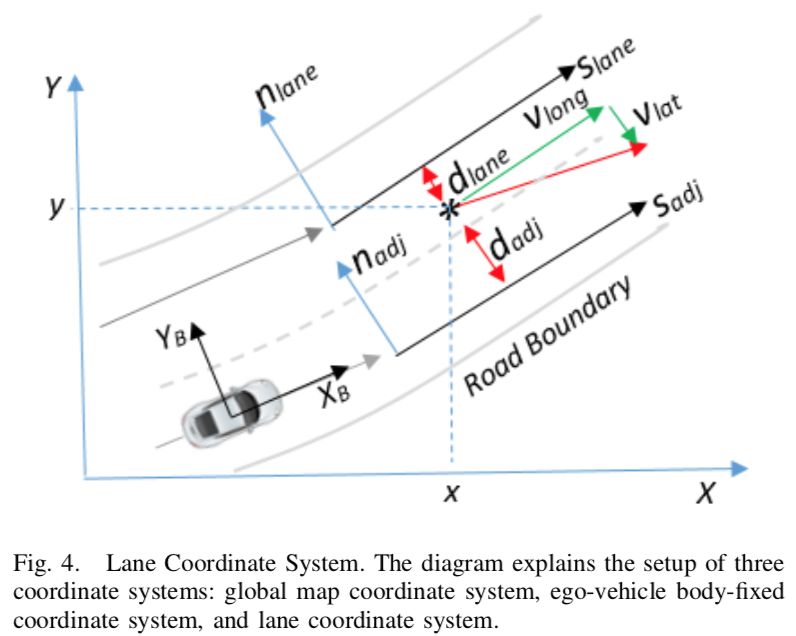

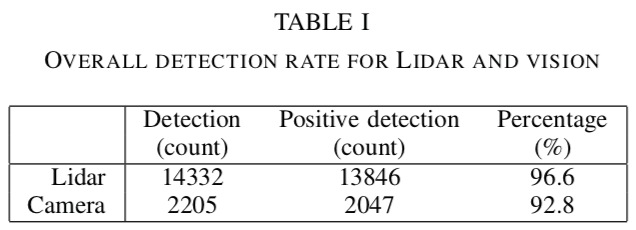

作者展示了一种实时车辆检测及追踪的系统来实现诸如城市环境中驾驶行为分析的复杂任务。作者提出了一种结合了单目相机和2D Lidar的鲁棒的融合系统。该系统充分利用了以下3个关键的部分:使用深度学习技术的鲁棒的车辆检测,从Lidar获得的高精度距离数据,以及预先知道的道路环境。相机与Lidar传感器的融合,数据关联以及跟踪管理全部都在考虑了传感器的特征之后在全局地图坐标系上执行。

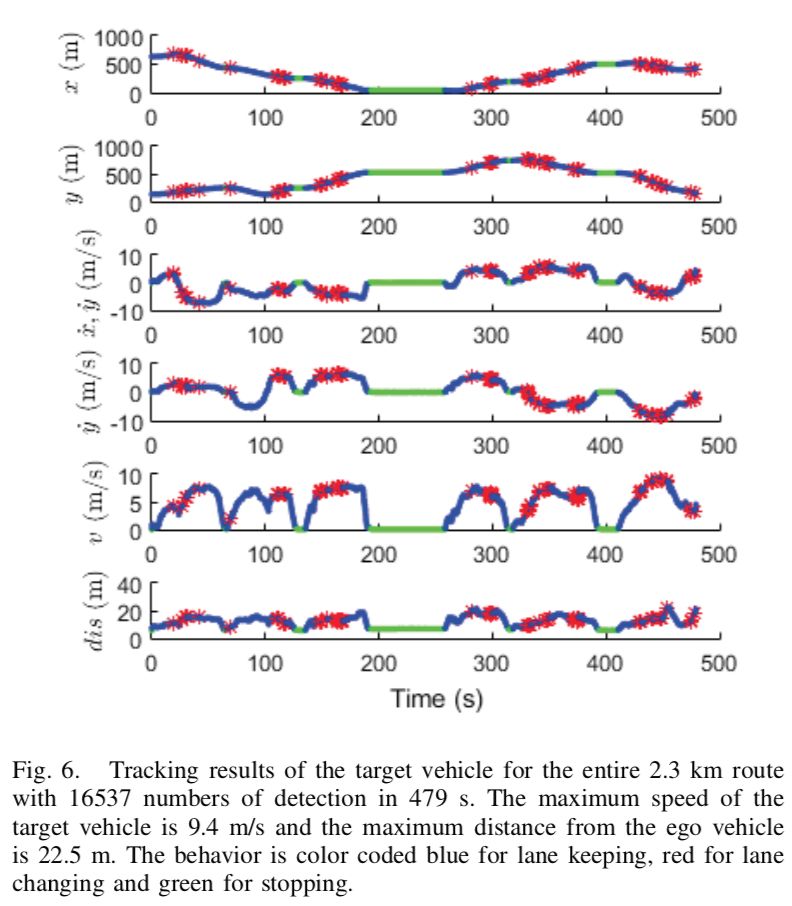

最后,作者提出在编码了道路环境的车道坐标系中执行行为推理来检查被追踪的车辆的状态。作者通过追踪领头车辆在执行诸如保持车道、路口停车启动、变换车道、超车及转向灯常见城市驾驶行为验证了他们提出的方法的可行性。领头车辆在2.3km长的路线上被联系追踪并将其驾驶行为进行了可靠地分类。

Abstract

We present a real-time vehicle detection and tracking system to accomplish the complex task of driving behavior analysis in urban environments. We propose a robust fusion system that combines a monocular camera and a 2D Lidar. This system takes advantage of three key components: robust vehicle detection using deep learning techniques, high precision range estimation from Lidar, and road context from the prior map knowledge. The camera and Lidar sensor fusion, data association and track management are all performed in the global map coordinate system by taking into account the sensors’ characteristics. Lastly, behavior reasoning is performed by examining the tracked vehicle states in the lane coordinate system in which the road context is encoded. We validated our approach by tracking a leading vehicle while it performed usual urban driving behaviors such as lane keeping, stop-and- go at intersections, lane changing, overtaking and turning. The leading vehicle was tracked consistently throughout the 2.3 km route and its behavior was classified reliably.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:zpx0

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com