【泡泡图灵智库】学习场景几何在有挑战条件下进行视觉定位(ICRA)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Learning Scene Geometry for Visual Localization in Challenging Conditions

作者:Nathan Piasco, Desire Sidibe, Valerie Gouet-Brunet and Cedric Demonceaux,Universite Bourgogne Franche-Comte (ComUE),France

来源:ICRA 2019

编译:郑宇

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——Learning Scene Geometry for Visual Localization in Challenging Conditions,该文章发表于2019 International Conference on Robotics and Automation (ICRA).

我们提出了一种新的基于图像的户外大规模图像定位方法,可以处理跨季节、跨天气、昼夜和长时期定位等具有挑战性的场景。该方法的关键部分是一种新的学习全局图像描述符,它可以在训练期间有效地利用场景几何信息。在测试时,我们的系统能够推断与查询图像相关的深度图,并使用它来提高定位精度。

我们能够在跨天气和长期定位场景中提高2.15%的性能,在具有挑战性的冬季/夏季定位序列与现有技术方法相比提高4.24%。我们的方法还可以使用弱标注的参考数据集,实现白天图像定位夜间图像。

主要贡献

本文提出了一种图像描述符,它从图像中学习相应的场景几何特征,以处理具有挑战性的户外大规模基于图像的定位场景。我们在训练步骤中引入几何信息,使我们的新描述符对在不同时间拍摄的图像之间发生的视觉变化具有鲁棒性。一旦训练好模型,我们的系统只需要输入图像即可构建表达描述符实现图像检索。这种系统设计也称为辅助信息学习,因为它仅在训练步骤期间使用几何和辐射信息(激光雷达数据),而且仅使用辐射测量数据实现图像定位。

算法流程

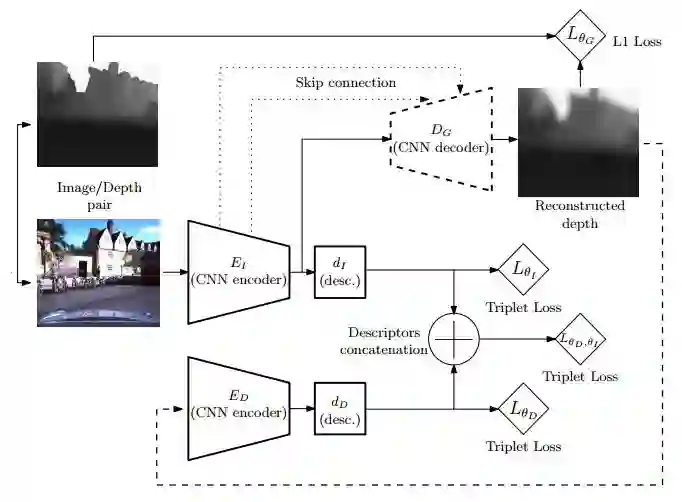

我们为基于图像的定位任务设计了一种新的全局图像描述方法。我们首先使用卷积神经网络编码器(EI)从输入图像中提取密集特征图。随后,这些特征图用于构建场景的紧凑表示(dI)。现有技术特征聚合方法可用于构建图像描述符,例如MAC或NetVLAD。我们使用仅在训练过程中可获得的深度图信息来增强此标准图像描述符。为此,使用深度全卷积神经网络解码器(DG)根据输入图像重建相应的深度图。然后使用重建的深度来提取全局深度图描述符。我们遵循之前使用的相同过程:在构建描述符(dD)之前,我们使用编码器(ED)提取深度特征图。最后,图像描述符和深度图描述符被L2归一化以连接成单个全局描述符。图1总结了我们方法的整个过程。一旦使用几何和辐射信息进行训练,所提出的方法仅用于图像,以创建适合图像定位的描述符。

图一,本文的图像描述符训练流程

图一:使用辅助深度数据进行图像描述符训练(本文的工作):两个编码器用于从主图像形态和辅助重建深度图(从本文的深度解码器推断)中提取深度特征图。这些特征用于创建最猴连接到一个最终图像描中的中间描述符。

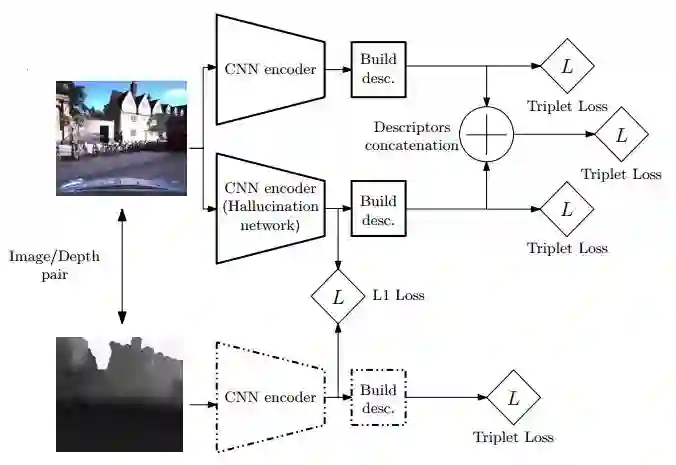

图二,用于图像描述符学习的Hallucination 网络

图二:用于图像描述符学习的Hallucination网络:我们训练了一个Hallucination网络,用于全局图像描述的任务。与所提出的方法(参见图一)不同,Hallucination网络再现了由深度图训练的网络而不是深度图本身获得的特征图。

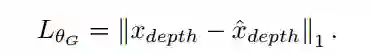

为了训练深度图生成器,我们使用一个简单的l1损失函数:

整个系统根据以下约束进行训练:

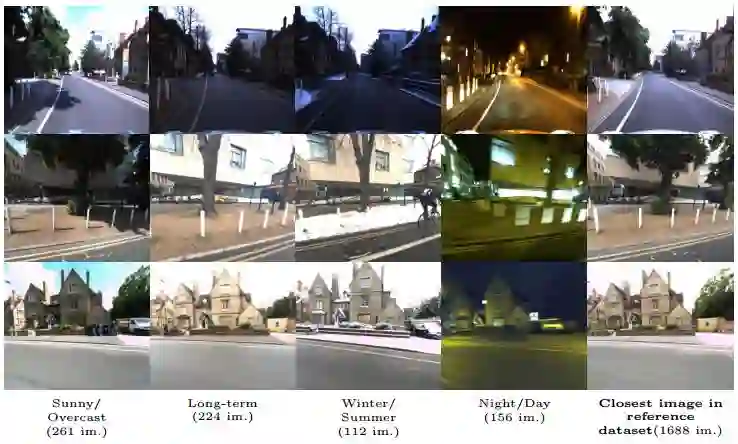

图三,测试图像举例

图三:测试图像举例。我们评估了四个具有挑战性场景的定位序列,共1688张参考图像。

我们在同一空间区域(与用于训练和验证的区域不同)提出了四种测试方案。参考数据集由沿着2km的路径每5米拍摄一次的1688幅图像组成。这四个查询集分别是:

1,晴天/阴天:在晴天时采集的查询集。

2,长期:在相似天气条件下,在采集参考图像7个月后再来采集查询。

3,冬季/夏季:在下雪天采集的查询集。

4,夜间/白天:在夜间采集的查询集,与参考图像相比发生了根本性的视觉变化。

主要结果

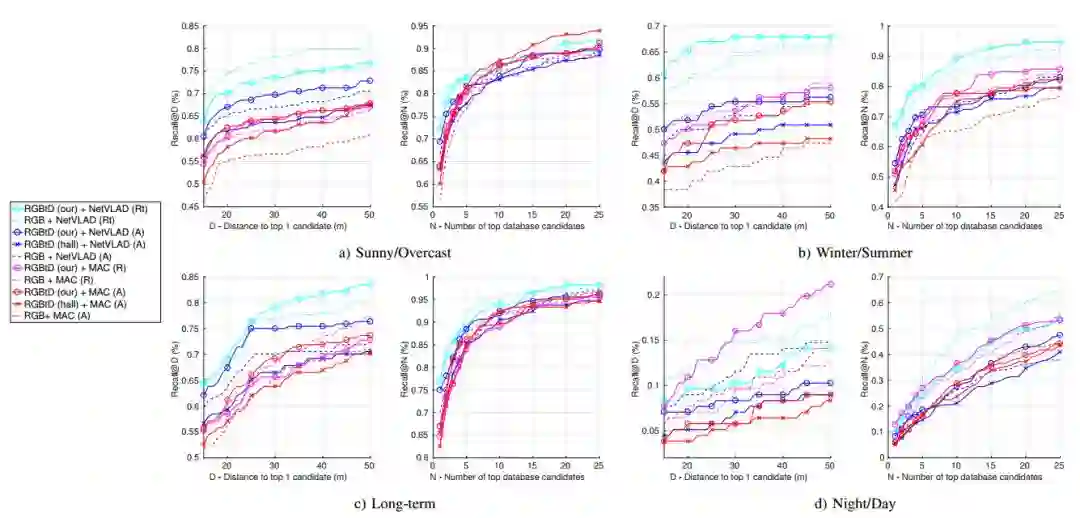

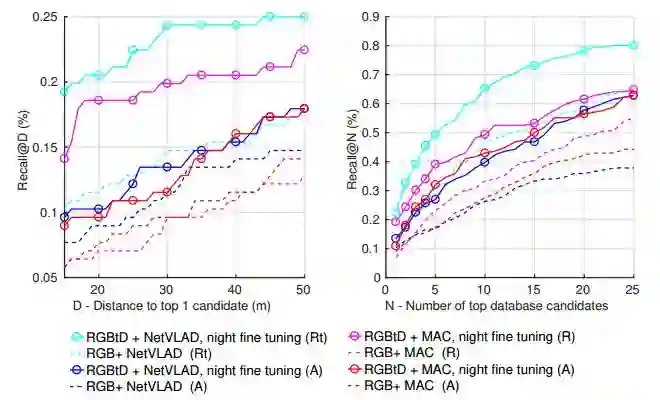

图四. 将我们的方法与Hallucination网络和仅用图像训练的网络的比较:我们的方法(-o-)在几乎所有面对Hallucination网络(-x-)的场景中都是优越的。它还以很大的优势击败仅使用图像(-)训练的网络。NetVLAD描述符(蓝色和青色曲线)优于MAC(红色和品红色曲线),特别是在精度方面(Recall @ D曲线)。夜/日数据集仍然是最具挑战性的数据集。

图四,和不同网络方法的对比

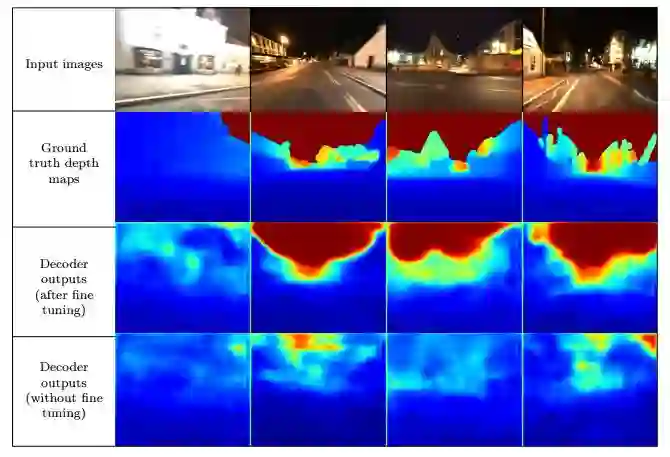

图五. 夜间图像微调对解码器输出的影响:使用白天图像训练的解码器无法重建场景几何图形(底线)。使用少于1000对的图像对网络进行微调,夜间获取的深度图大大改善了生成的深度图的外观,地图最好用颜色查看。

图五,夜间图像微调对解码器输出的影响

图六. 微调后的夜间/日间查询结果:通过仅使用弱注释数据微调我们网络的解码器部分,我们能够极大地改善夜间/日挑战场景的本地化性能,曲线最好用颜色看。

图六,微调后的夜间/日间查询集的结果

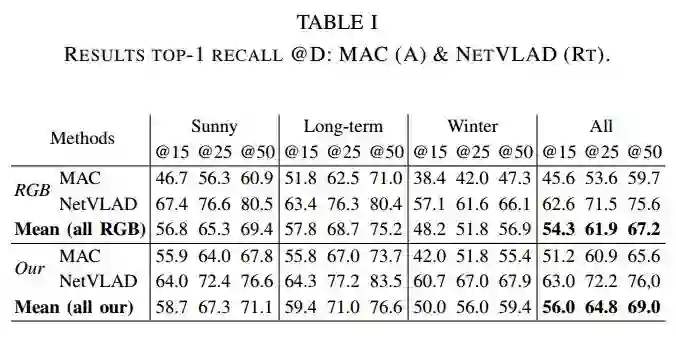

表一展示了MAC和NETVLAD返回结果对比

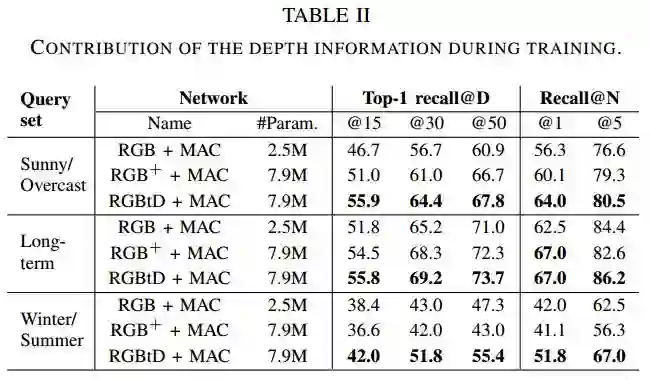

表二展示了训练过程中深度信息的贡献:

Abstract

We propose a new approach for outdoor large scale image based localization that can deal with challenging scenarios like cross-season, cross-weather, day/night and longterm localization. The key component of our method is a new learned global image descriptor, that can effectively benefit from scene geometry information during training. At test time, our system is capable of inferring the depth map related to the query image and use it to increase localization accuracy.

We are able to increase recall@1 performances by 2.15% on cross-weather and long-term localization scenario and by 4.24% points on a challenging winter/summer localization sequence versus state-of-the-art methods. Our method can also use weakly annotated data to localize night images across a reference dataset of daytime images.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com