小样本学习跨域(Cross-domain)问题总结

极市导读

小样本学习利用先验知识,能够快速泛化至仅包含少量具备监督信息的样本的新任务中。但跨域问题阻碍了元学习方法到实际场景的应用。本文引用了四篇相关的论文,分别从图像和声音领域总结小样本学习的跨域问题。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

一:A CLOSER LOOK AT FEW-SHOT CLASSIFICATION

-

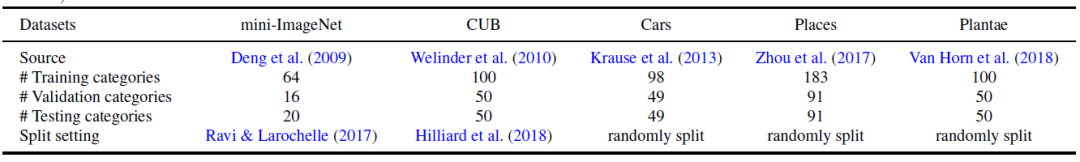

MiniImageNet:此处不再介绍。 -

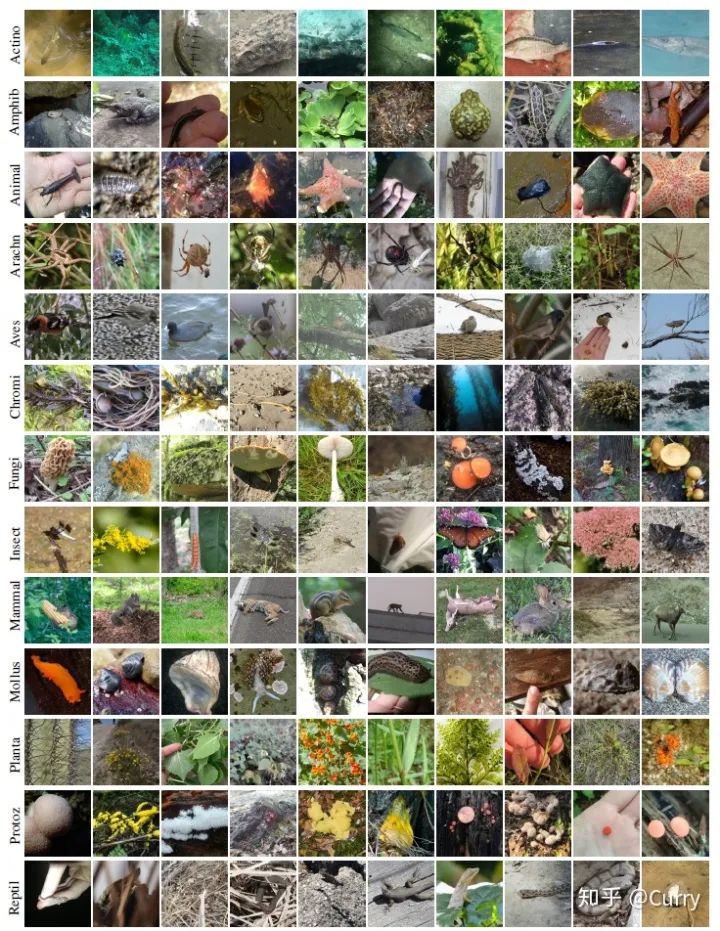

CUB(CUB200-2011):该数据集由加州理工学院再2010年提出的鸟类细粒度数据集,也是目前细粒度分类识别研究的基准图像数据集,如图所示。

-

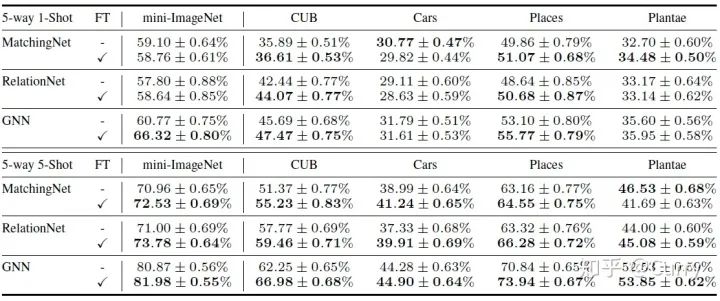

Backbone: ResNet-18 -

N-way k-shot: 5-way 5-shot

-

Baseline = pre-training + fine-tuning(linear layer) -

Baseline++ = pre-training + fine-tuning(Cosine distance)

-

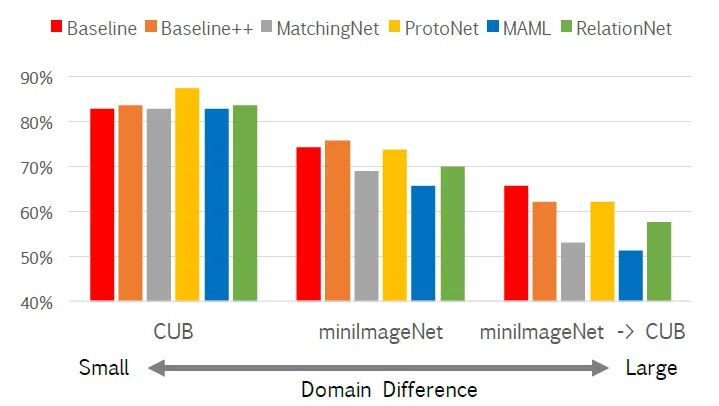

随着域差别的增加,CUB < miniimagenet < CUB-miniimagenet,Accuracy呈现较大幅度下降; -

在miniimagenet和CUB-miniimagenet两组实验中,pre-training + fine-tuning的结果优于各元学习模型,表明在小样本学习的跨域问题上,元学习方法似乎失去了优势;

二:A Broader Study of Cross-Domain Few-Shot Learning

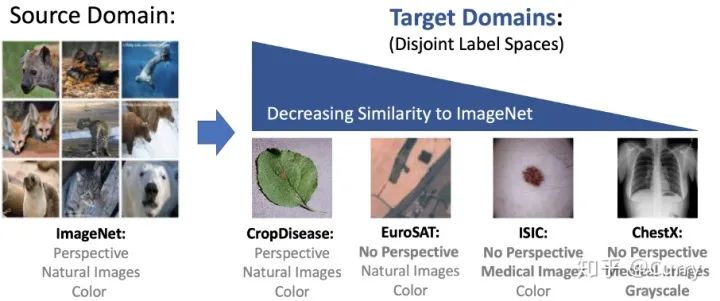

农业: CropDiseases2 彩色, 自然图像, 有自身的特点 (相似度 ⭐⭐⭐⭐) https://link.zhihu.com/?target=https%3A//www.tensorflow.org/datasets/catalog/plant_village 卫星图: EuroSAT3 彩色, 自然图像, 无透视变形 (相似度 ⭐⭐⭐) https://link.zhihu.com/?target=https%3A//www.tensorflow.org/datasets/catalog/eurosat 皮肤病: ISIC20184 彩色, 医学影像, 无透视变形 (相似度 ⭐⭐) https://link.zhihu.com/?target=https%3A//challenge2018.isic-archive.com/ X光片: ChextX5 灰度, 医学影像, 无透视变形 (相似度 ⭐) https://link.zhihu.com/?target=https%3A//nihcc.app.box.com/v/ChestXray-NIHCC

-

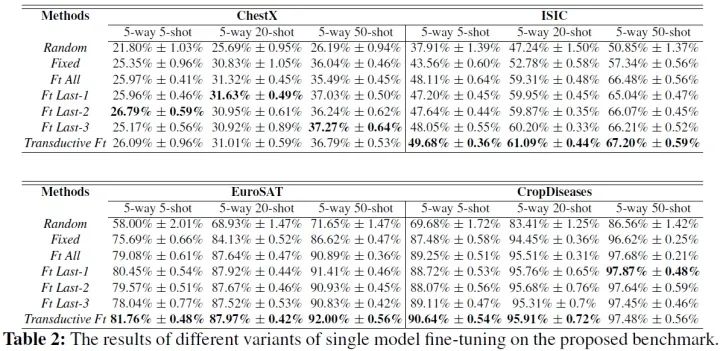

固定特征提取器(Fixed feature extractor):利用预训练的模型作为固定的特征提取器; -

微调所有层(Ft all):使用标准的监督学习调整新任务的所有预训练参数; -

微调last-k(Ft last-k):只有预训练模型的最后k层针对新任务进行优化,在本文中只考虑微调last-1、微调last-2、微调last-3; -

Transductive fine tuning(Transductive Ft):查询图像的统计信息通过BN来使用;

-

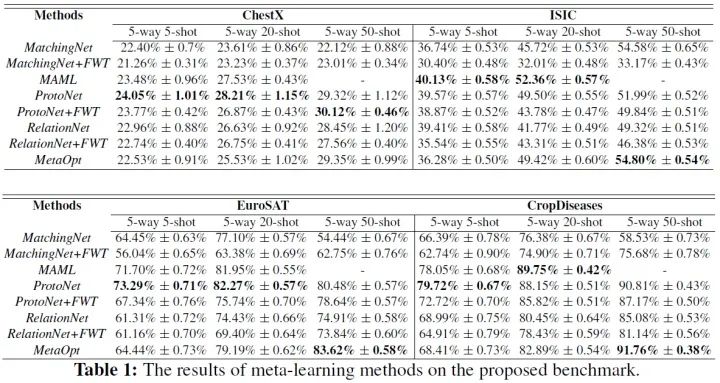

不同元学习模型在同一中目标域下的表现相近,而同一种元学习模型在不同目标域下的性能表现有明显差距,甚至60%的准确率差距; -

随着目标域与源域相似度的逐渐增加,各个模型性能表现整体有较大幅度提升; -

最先进的元学习方法MetaOpt没有比早期的元学习模型表现的更好; -

与微调方法相比,所有的元学习方法的表现都明显不佳,在跨域问题中元学习方法再次被微调方法打败;一些元学习方法甚至被随机权重的网络所击败;

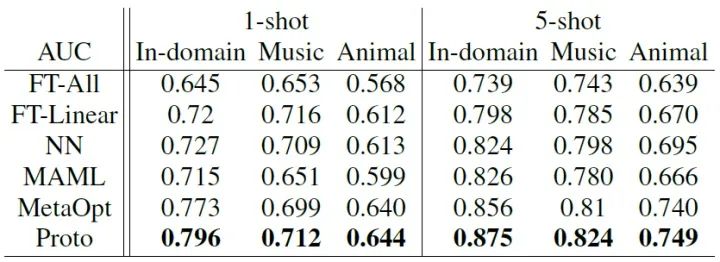

三:FEW-SHOT ACOUSTIC EVENT DETECTION VIA META LEARNING

-

NN是最近邻的缩写,根据相邻的数据点对新数据进行分类。

-

在声事件检测任务上,元学习整体比Fine-tune方法有更好的表现;且Proto原型网络成绩最优; -

随着域差异的增大,FT-liner和NN方法开始优于MAML; -

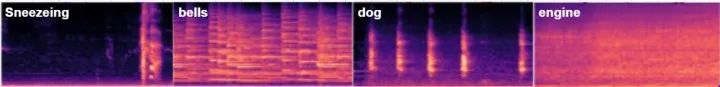

与图像分类相同的是,随着与源域差异的增大,各个模型的表现都会变差;但是最大的下降幅度在15%左右,远小于图像分类最多60%的差异;原因在于所有音频经过了log Mel filterbank特征的提取,提取出来的特征图如下图所示,声音信号由完全不同的域,经过log Mel特征提取后,域差异会减小,因此跨域结果的下降幅度也会变小;

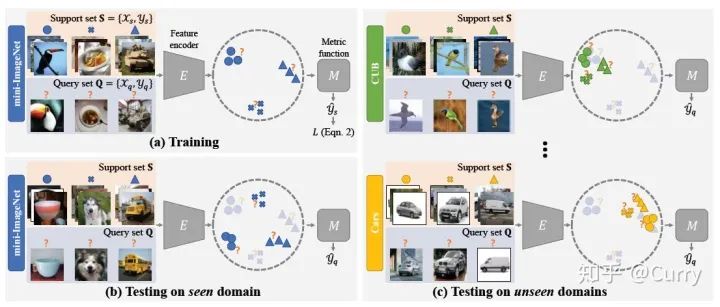

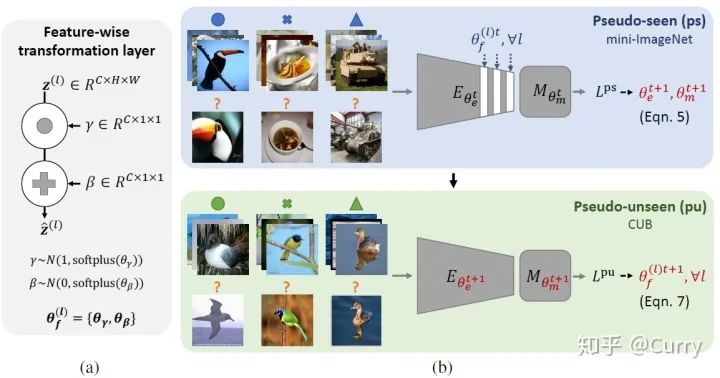

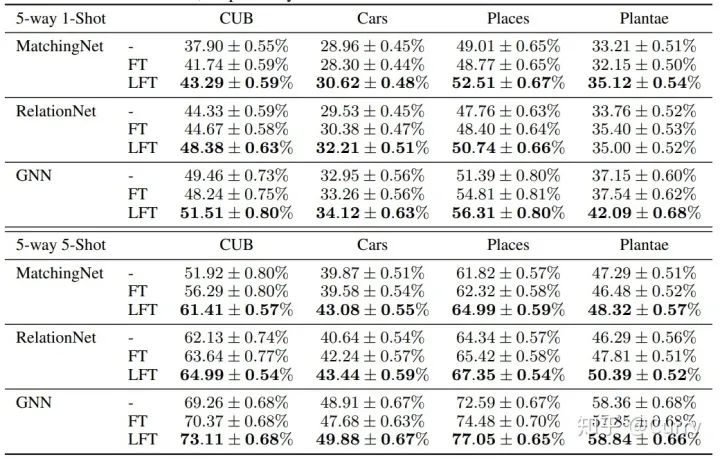

四:CROSS-DOMAIN FEW-SHOT CLASSIFICATION VIA LEARNED FEATURE-WISE TRANSFORMATION

-

5-way 1-Shot / 5-way 5-Shot -

Backbone:ResNet-10

推荐阅读

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年1月27日

Arxiv

6+阅读 · 2018年3月30日