ICLR2019 | 深入了解小样本(Few-shot)分类

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

作者: 长风破浪

https://zhuanlan.zhihu.com/p/64672817

本文已授权,未经允许,不得二次转载

A Closer Look at Few-shot Classification

作者: Chen, Wei-Yu and Liu, Yen-Cheng and Kira, Zsolt and Wang, Yu-Chiang andHuang, Jia-Bin

arXiv:https://arxiv.org/abs/1904.04232

一、文章针对的问题和主要贡献

在小样本学习(Few-shot Learning)方面,近几年各种方法层出不穷,模型结构和学习算法也越来越复杂。而然,这些方法之间没有在统一的框架下进行比较。这篇文章针对几个关键问题,如数据集对小样本学习方法的影响、网络深度对这些方法的性能的影响以及领域漂移下这些方法的表现,对当前的小样本学习方法进行性能比较和阐释。具体地,本文有以下三个主要贡献:

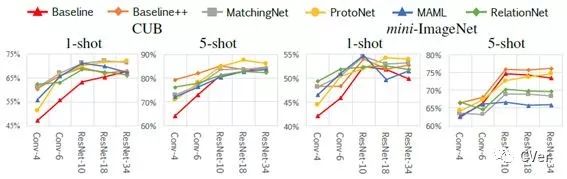

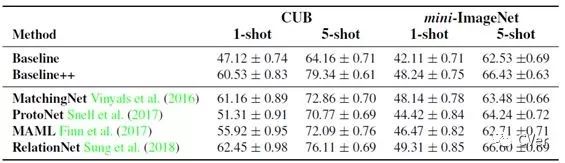

(1) 对集中已有的方法做了比较,特别地,实验了基础模型的能力对这些方法的性能的影响,结果显示,在领域差异比较小的情况下(如CUB这种细粒度分类任务),随着基础即特征提取神经网络的能力的提高(从四层的CNN提升到resnet),这些方法之间的性能差异越来越小;相反地,在领域差异比较大的情况下(如miniImageNet),随着基础即特征提取神经网络的能力的提高,这些方法的性能差异越来越大。

(2) 文章建立了两个普通简单的baseline,发现在CUB和miniImageNet上的性能足以和当前最先进的基于元学习的方法媲美。

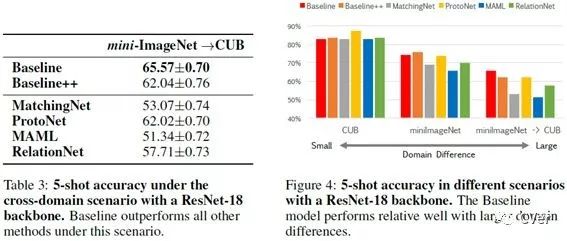

(3) 基于(1)的结果和一些已有的研究,作者特别强调了小样本学习任务中的领域自适应问题,并且设计实验显示当前这些state-of-the-art的小样本学习方法在领域漂移的情况下表现相当不好,没有baseline表现好,提醒人们对这个方向多关注。

二、模型介绍

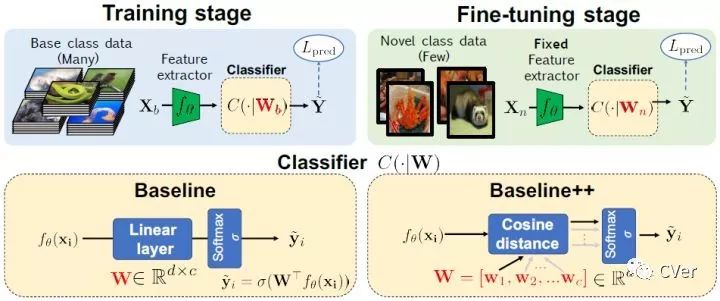

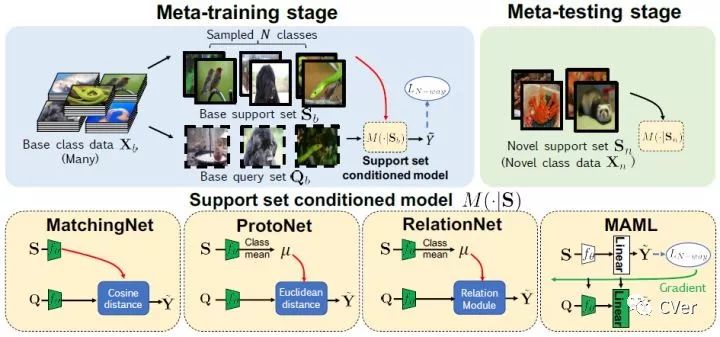

以上两个图片就是本文使用的模型。其中包括两个baseline,第一个在分类时使用了线性分类器,第二个在分类时使用了cos距离的分类器,旨在增加不变性。右图显示了本文比较的四个模型,分别是MatchingNet,ProtoNet, RelationNet, MAML.

三、实验

(1) 基础网络的能力对小样本学习方法性能差异的影响

如下图所示,结果显示,在领域差异比较小的情况下,随着基础即特征提取神经网络的能力的提高(从四层的CNN提升到resnet),这些方法之间的性能差异越来越小;相反地,在领域差异比较大的情况下,随着基础即特征提取神经网络的能力的提高,这些方法的性能差异越来越大。

(2) 文章建立了两个普通简单的baseline,在分类时使用了cos距离的分类器减少了类内的差异性,结果显示其在CUB和miniImageNet上的性能足以和当前最先进的基于元学习的方法媲美.

(3) state-of-the-art的小样本学习方法在领域漂移的情况下表现相当不好,没有baseline表现好.

四、总结

本文没有提出什么先进的模型,但是却进行了一些有意义的实验,提出了几个大家容易忽略的问题,对小样本分类这一问题有了更加深刻的认识,也指出了一些存在的问题,因此是比较有价值的。特别地,文章强调了特征提取网络的能力、数据集的差异性以及领域自适应问题对小样本学习任务的影响,特别强调了应该关注小样本学习中的领域自适应问题。不过在这篇文章的评审过程中,有审稿人觉得领域自适应不应该在小样本学习任务中强调,但是作者坚持自己的看法。

这一研究也启示我们在研究过程中应该全面考虑问题,自己的到的模型性能也很大程度上受限于数据集、基础模型等问题的影响,在其他条件下,可能最简单的模型最具有竞争力。

CVer学术交流群

扫码添加CVer助手,可申请加入CVer-目标检测交流群、图像分割、目标跟踪、人脸检测&识别、OCR、超分辨率、SLAM、医疗影像、Re-ID和GAN等群。一定要备注:研究方向+地点+学校/公司+昵称(如目标检测+上海+上交+卡卡)

▲长按加群

这么硬的论文精读,麻烦给我一个在在看

▲长按关注我们

麻烦给我一个在看!