ICML 2020 | 小样本学习首次引入领域迁移技术,屡获新SOTA结果!

前言

介绍

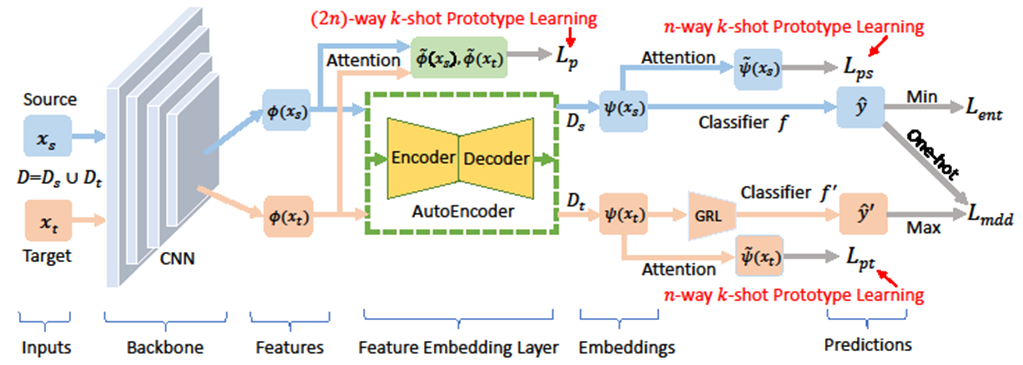

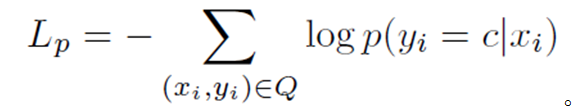

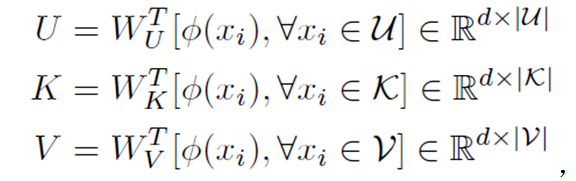

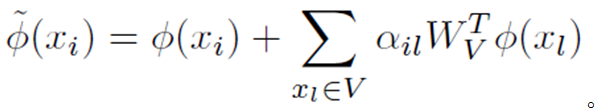

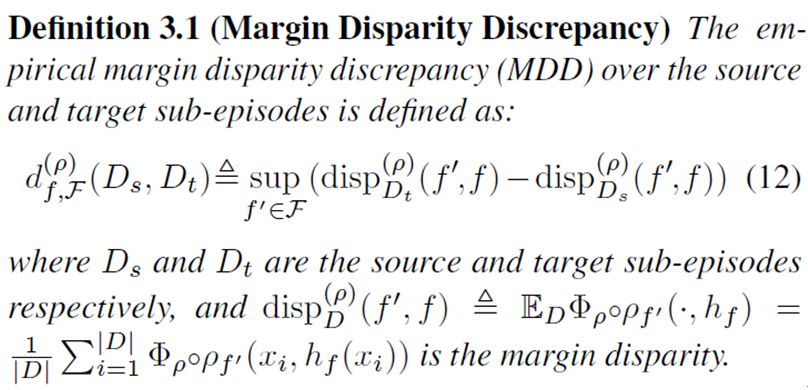

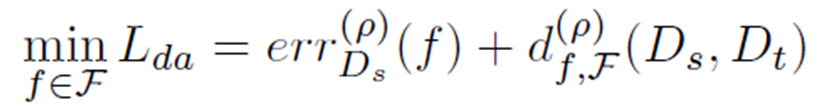

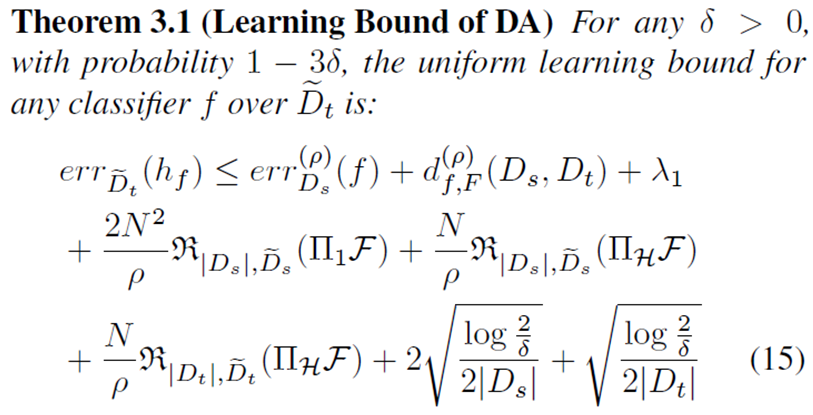

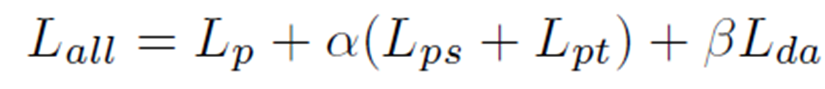

模型方法

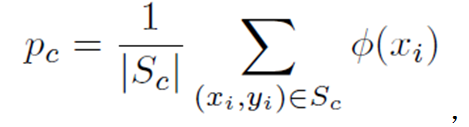

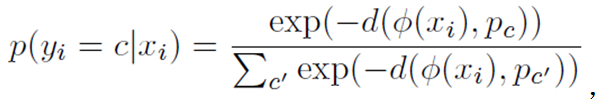

与

与

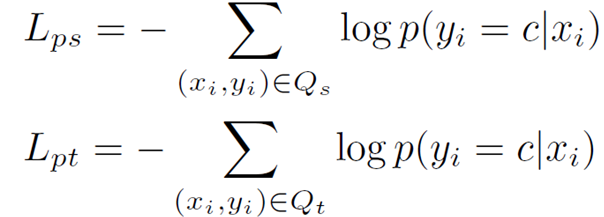

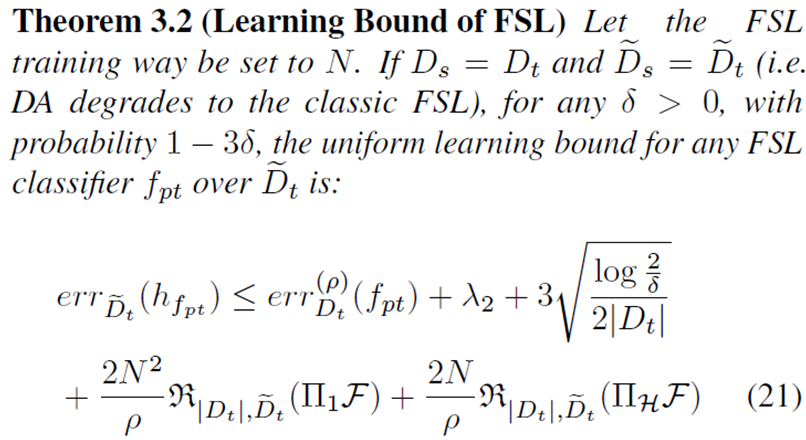

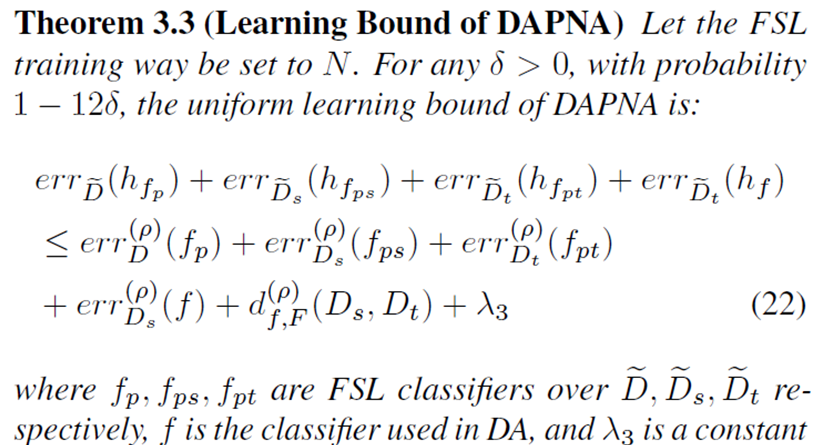

都设置为1的时候,总损失函数就是我们所提算法的泛化误差上界。由此,我们为DAPNA算法建立了理论分析。

都设置为1的时候,总损失函数就是我们所提算法的泛化误差上界。由此,我们为DAPNA算法建立了理论分析。

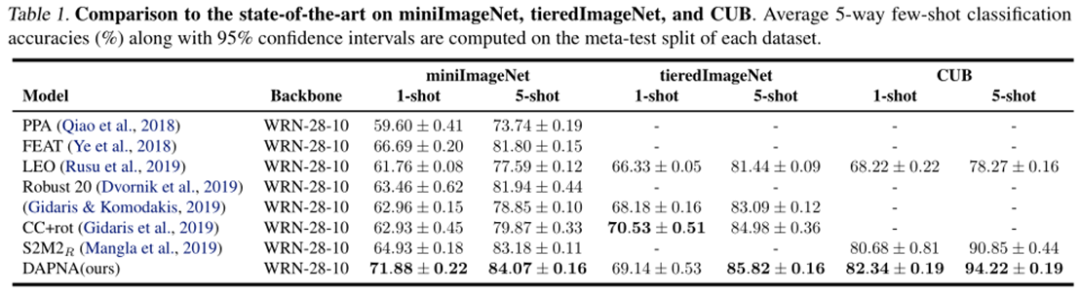

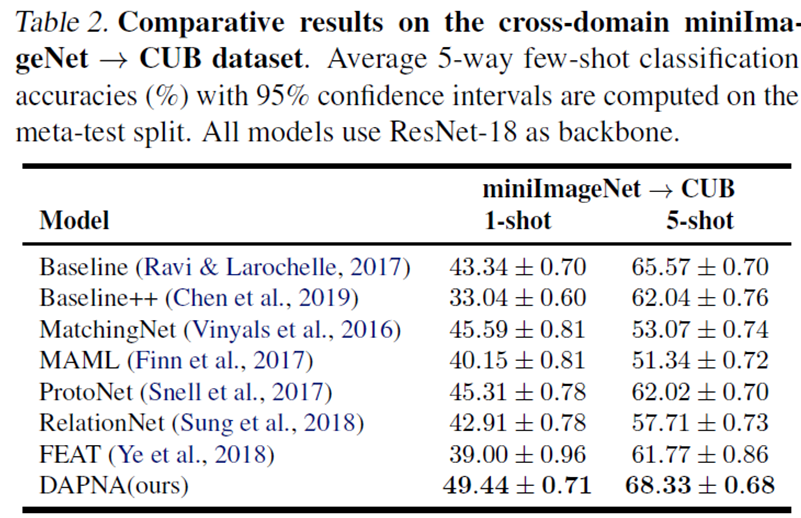

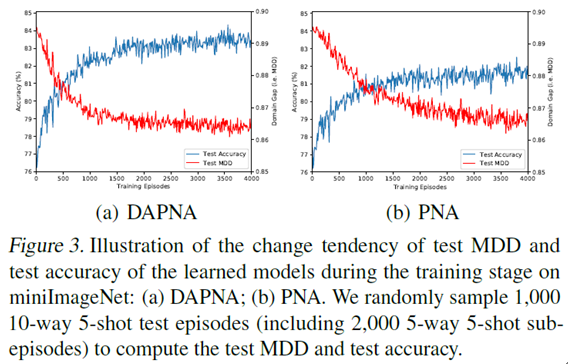

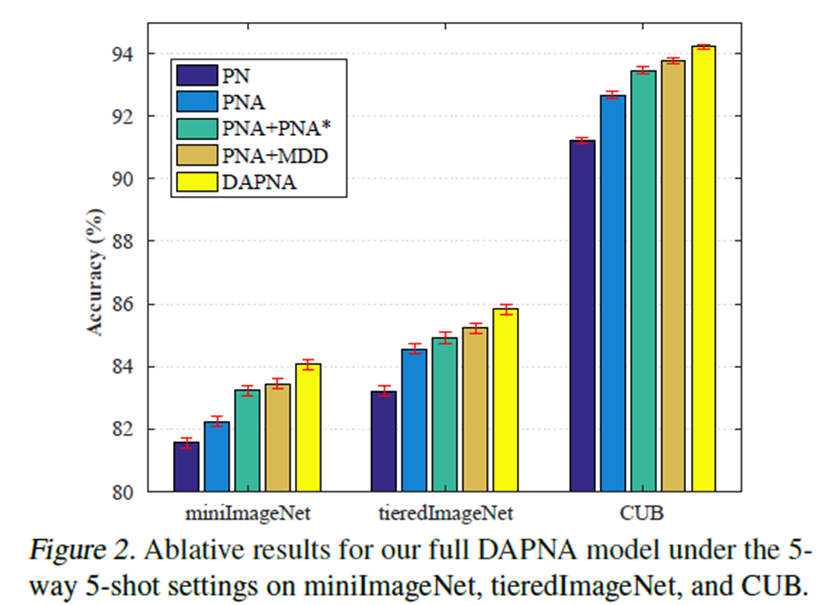

实验

总结

登录查看更多