![]()

本文介绍我们近期的两篇文章 MST 与 MST++,其中 MST 已被 CVPR 2022 接收,MST++ 被 CVPRW 2022 接收,并在 NTIRE 2022 Spectral Reconstruction Challlenge 中取得第一名。

![]()

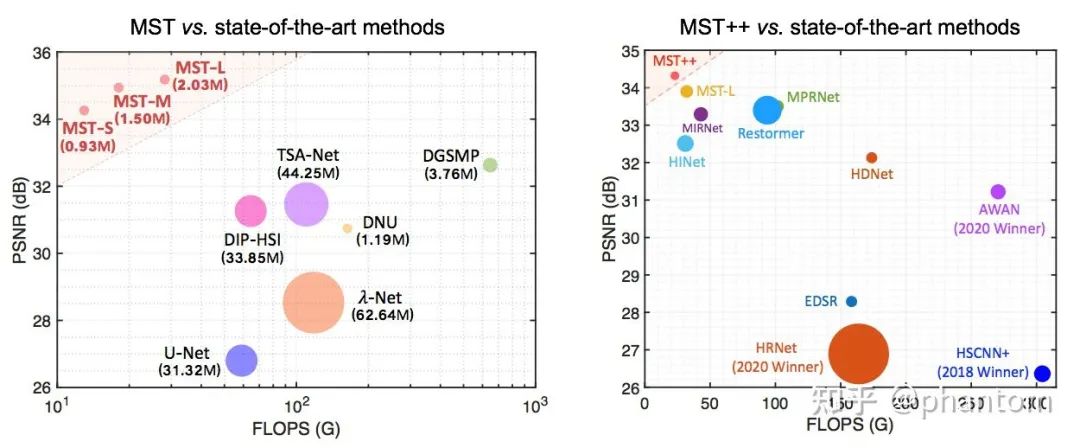

▲ 图1 MST 与 MST++ 与 SOTA 算法的对比图。横轴代表计算量,纵轴代表性能,圆半径代表参数量。

先验货,MST 与 MST++ 与 SOTA 方法对比如图 1 所示,很轴为计算量,纵轴为性能,圆半径代表参数量。MST 与 MST++ 占据了左上角,参数量也非常小,实现多快好省的高光谱图像重建。

![]()

论文标题:

Mask-guided Spectral-wise Transformer for Efficient Hyperspectral Image Reconstruction

收录会议:

CVPR 2022

https://arxiv.org/pdf/2111.07910.pdf

https://github.com/caiyuanhao1998/MS

![]()

论文标题:

MST++: Multi-stage Spectral-wise Transformer for Efficient Spectral Reconstruction

收录会议:

NTIRE 2022

https://arxiv.org/abs/2204.07908

https://github.com/caiyuanhao1998/MST-plus-plus

![]()

高光谱图像简介

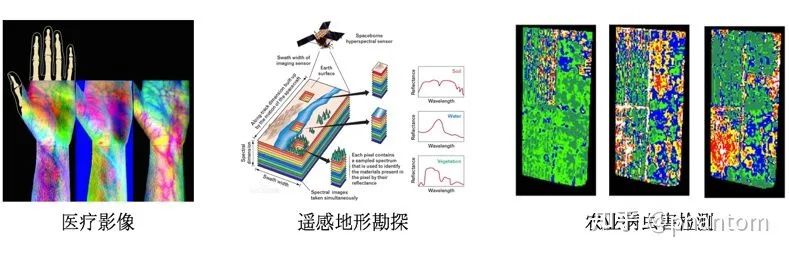

高光谱图像(Hyperspectral Image, HSI)指的是光谱分辨率在

数量级范围内的光谱图像。相较于常规的 RGB 图像而言,高光谱图像有着更多的波段(即通道数更多如 31,28)来更加准确全面的描述被捕获场景的特性。在很多时候,从 RGB 图像中无法观测出异常,但是从高光谱图像的某一个波段中却能一眼看出问题所在。

这么说可能不太好理解,举个例子,比如在深夜,如果直接看 RGB 图像的话,可能是一片漆黑,但是如果通过红外夜视仪的话,就能很清晰看到发热的活物。这个红外夜视仪捕获的就是红外光谱图像。也正因为光谱图像有着这样的特性,它被广泛地应用于目标检测与追踪,图像识别,遥感,医疗影像等领域。

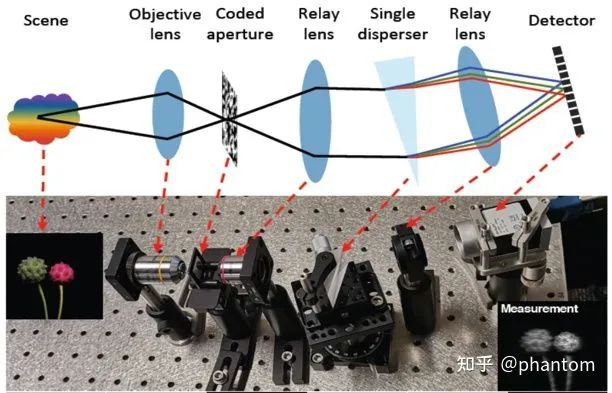

![]()

那么既然高光谱图像那么有用,我们应该如何获取它呢?传统的成像设备采用光谱仪对成像场景进行空间域通道维度的扫描,费时费力,不适用于运动场景。近些年,科学家们专门设计了快照压缩成像(Snapshot Compressive Imaging,SCI)系统来解决这一问题。在诸多 SCI 系统当中,编码孔径快照光谱成像(Coded Aperture Snapshot Spectral Imaging)系统脱颖而出,成为捕获获取光谱图像的重要手段,其结构如图 2 所示

![]()

CASSI 系统首先通过一个编码孔径掩膜对成像场景的各光谱通道进行调制,然后通过一个三棱镜进行色散后在相机上生成一个二维的快照估计图(compressive measurement)。那么有一种获取高光谱图像的方法就是用 CASSI 结合从 measurement 到 HSI 的复原算法,我们将这样的方法记为 SCI-to-HSI。

这种方法好不好?好,但是还不够好。为什么呢?因为 CASSI 的设备很贵,价格在 10,000 到 100,000 美金。不过它有一个优势就是,存储的时候只需要存储二维的 measurement,这可以极大降低存储与传输数据的成本。

那么,聪明的朋友可能就会发现了,既然本质上 RGB 和 HSI 都是同一场景的不同光谱通道成像,既然深度学习模型如 CNN,Transformer 又无所不能,那我何不直接学习一个从 RGB 到 HSI 的映射呢?RGB 相机遍地都是,RGB 图像遍地都是,RGB-to-HSI 的映射要是学得好,那岂不是点石成金,想啥来啥?何必还要破费买 CASSI 系统?没有中间商赚我几万美金的差价,这简直是零糖零卡零负担。正是基于 RGB-to-HSI 的构想,NTIRE 举办了 Spectral Reconstruction Challenge 并提供了相应的数据集。

我们的两个工作 MST 与 MST++ 就分别针对 SCI-to-HSI 与 RGB-to-HSI 设计了历史上第一个用于高光谱图像重建的 Transformer。

高光谱图像复原算法

2.1 MST用于SCI-to-HSI的高光谱图像复原

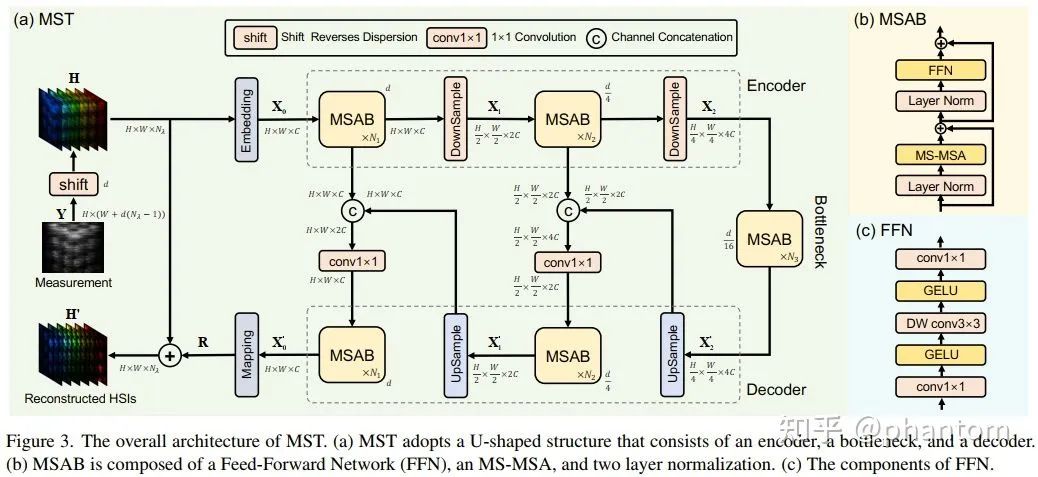

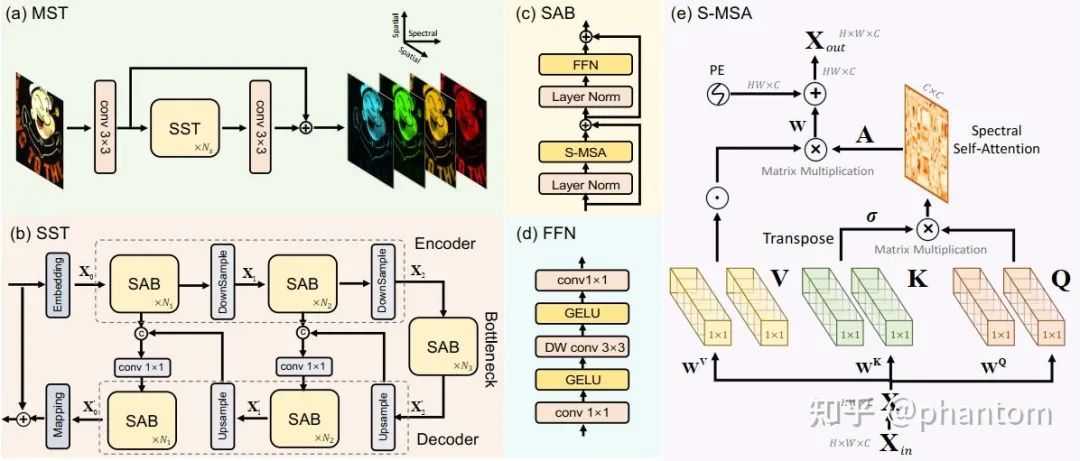

针对从 2D measurement 到 3D HSI cube 的光谱图像复原,我们提出了 Mask-guided Spectral-wise Transformer(MST),如图 3(a)所示。MST 是一个对称的 U 形的网络,其基本组成单元为 Mask-guided Self-Attention Block (MSAB),如图 3(b)所示。MSAB 中最重要的就是 Mask-guided Spectral-wise Multi-head Self-Attention(MS-MSA)。MSAB 包含两个 Layer Normalization(LN),一个 MS-MSA 和一个前向神经网络 Feed Forward Network(FFN),如图 3(c)所示。

![]()

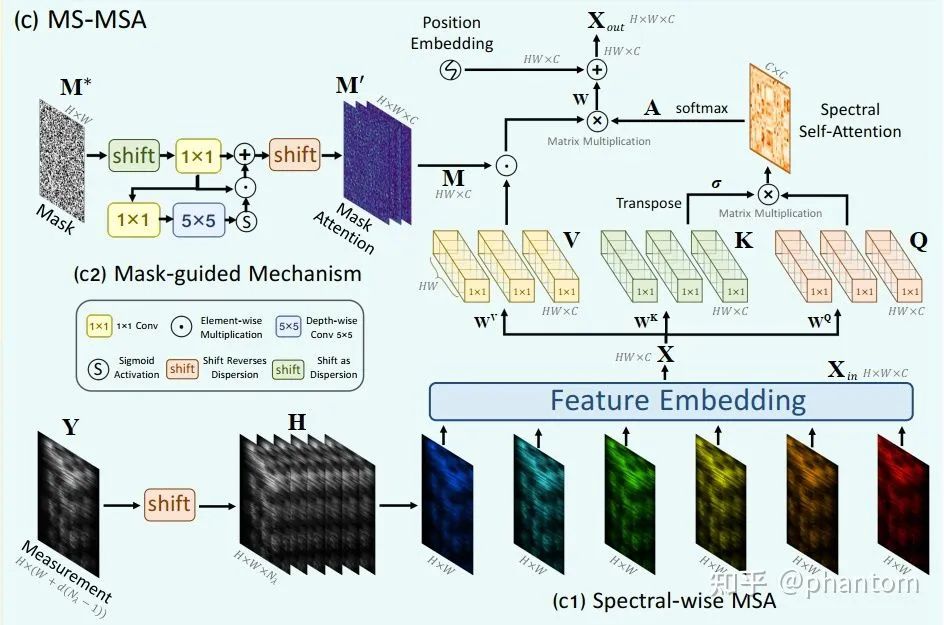

其中的 MS-MSA 又可以拆解为两部分,即 Mask-guided Mechanism(MM)和 Spectral-wise Multi-head Sefl-Attention(S-MSA)。为了避免大家觉得枯燥无味,这里就不给大家看比较琐屑的公式了。下面我会用语言大概介绍一下,相关细节请参照原文。MS-MSA 的结构如图 5 所示

![]()

S-MSA:

其中,S-MSA 的机构示意图如图 5(c1)所示。通常来说,之前的 Transformer 将一个 pixel vector 作为一个 token。然而,高光谱具有空间稀疏而通道上高度相似的特性,因此,计算空间维度的 self-attention 会比计算光谱通道维度的 self-attention 更加低效。基于这样一个 motivation,S-MSA 将每一个光谱通道的特征图作为一个 token 去计算 self-attention。

MM:

在 CASSI 成像过程中,我们注意到编码孔径掩膜(mask)被用来进行调制,而 mask 上各个位置的透光率不同,导致了生成 measurement 上的各个位置的保真度不同。因此为了获得保真度随空间位置变化的信息,我们将 mask 作为输入生成 Mask Attention Map,然后作用在 S-MSA 的 value 上,如图 5 (c2) 所示。

我们通过改变 MST 中各层 block 的数量(

,

,

)来得到一簇 MST family,他们是 MST-S(2, 2, 2),MST-M(2, 4, 4),MST-L(4, 7, 5)。

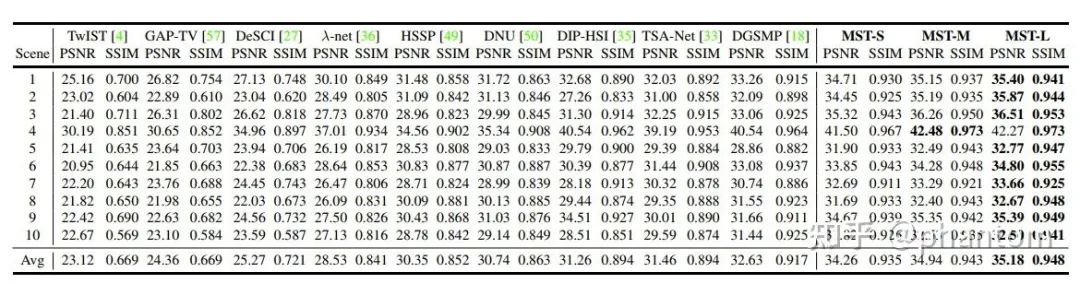

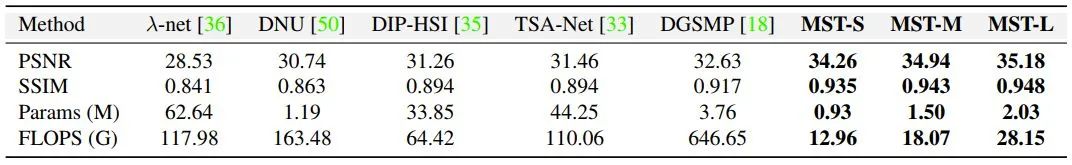

定量对比:

在 KAIST 数据集上的效果如表 1 所示。参数量-计算量-性能对比如表2 所示,可以看到,我们的 MST 采用更少的参数量与计算量,取得了更好的效果。画成对比图的话就如图 1 所示。MST 占据了左上角。

![]()

▲ 表1 MST与SOTA方法在KASIT数据集上的性能内对比

![]()

▲ 表2 MST与部分开源SOTA方法的性能-参数量-计算量对比

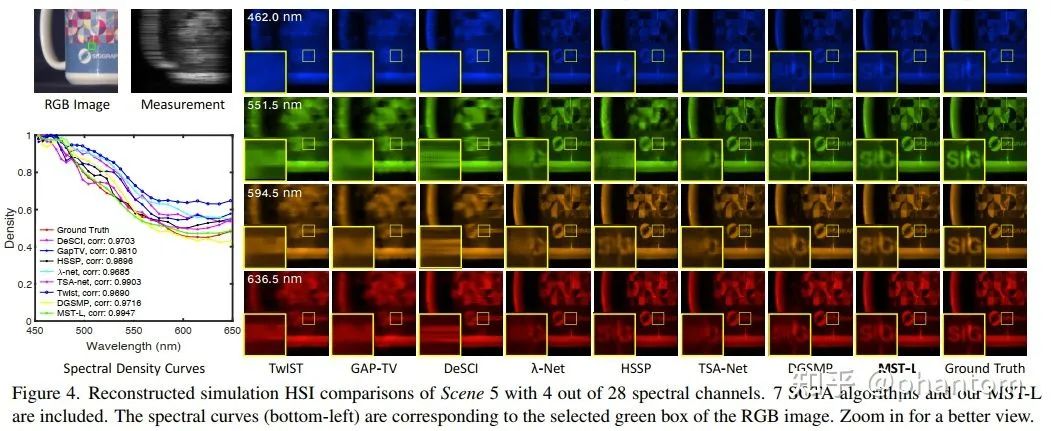

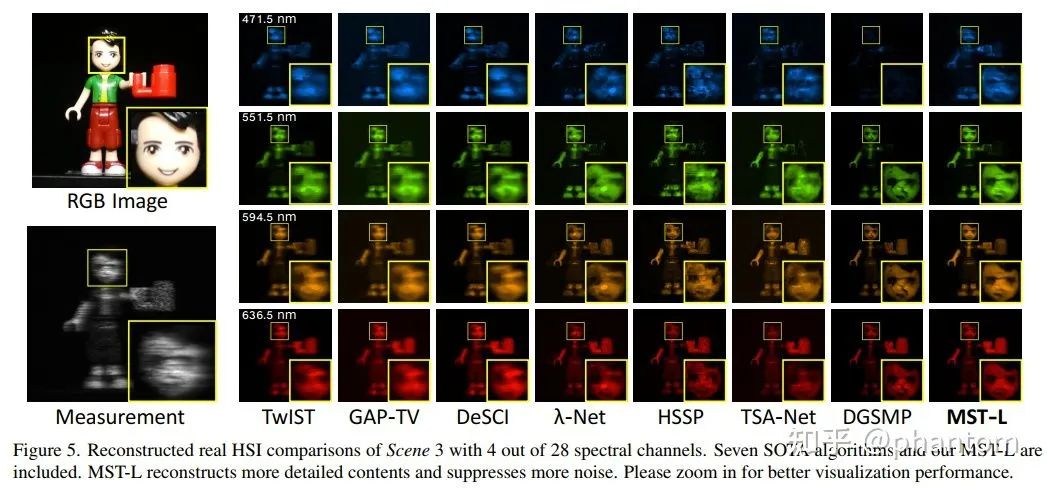

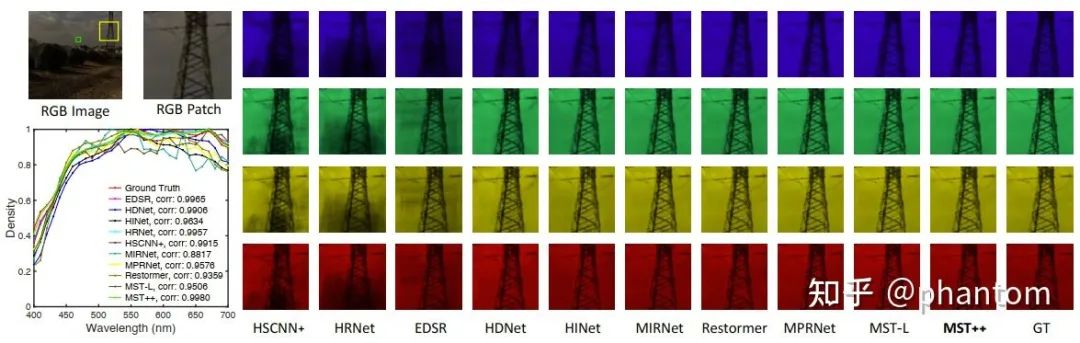

定性对比:

在 simulation 和 real 数据上的定性对比分别如图 6 和图 7 所示。MST 恢复出更多的光谱细节,同时从光谱曲线上来看,也取得了更高的 consistency, 更印证了我们方法的优越性。

▲ 图6 MST与SOTA方法在simulation数据上的定性对比图

▲ 图7 MST与SOTA方法在real数据上的定性对比图

2.2 MST++用于RGB-to-HSI的高光谱图像复原

MST++ 是 MST 的后续工作,其全称为 Multi-stage Spectral-wise Transformer。顾名思义,这很好理解,就是将 MST 的 MM 去掉,然后改成首尾串联的多阶段网络。输入变成 RGB 图像,输出还是 HSI。其框架如图 8 所示。

![]()

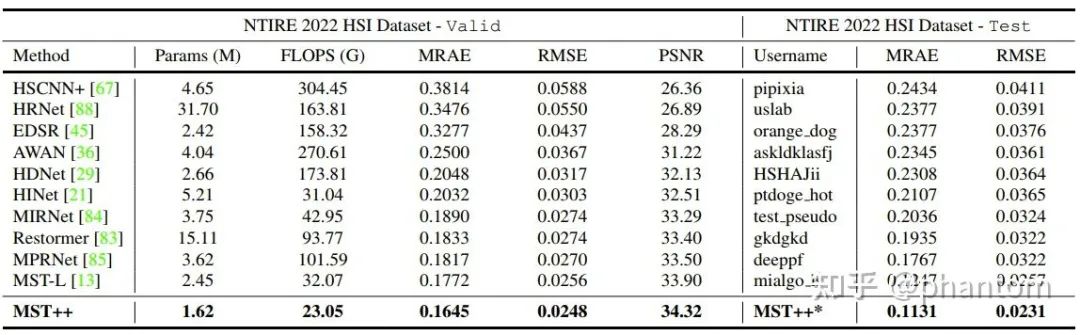

定量对比:

MST++ 与其他 SOTA 方法在 NTIRE 2022 的 validation 和 test 数据集上的对比如表 3 所示。我们的 MST++ 依旧使用更少的计算量和参数量,达到了更高的性能指标,同时取得了 NTIRE 2022 Challenge on Spectral Reconstruction from RGB 的冠军。

▲ 表3 MST++与SOTA方法在NTIRE 2022的validation和test数据集上的性能对比

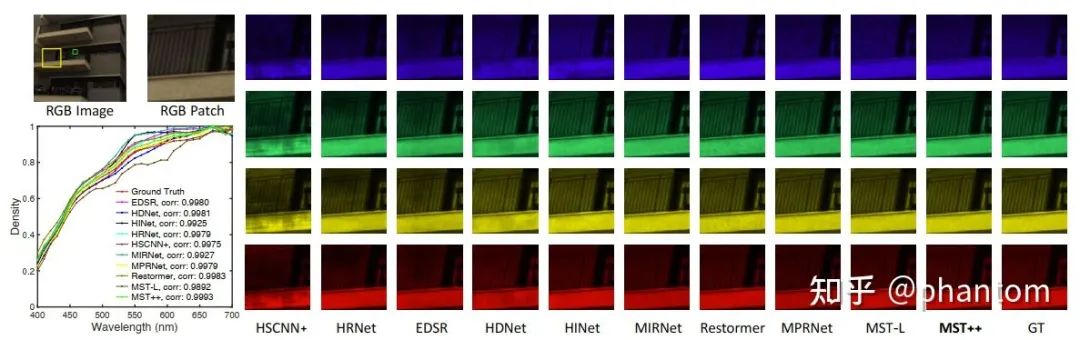

定性对比:

MST++ 与 SOTA 方法在 NTIRE 2022 的 validation 数据集上的定性对比如图 9 和图 10 所示。

▲ 图9 MST++与SOTA方法在NTIRE 2022的validation数据集上的定性对比

![]()

▲ 图10 MST++与SOTA方法在NTIRE 2022的validation数据集上的定性对比

目前为止,从 RGB 到 HSI 图像复原的研究缺乏一个好用的 baseline,我们将我们的方法连同 10 个 SOTA 复原算法,预训练模型,都开源在了

MST++

,希望推动这个方向的发展。

![]()

小结

针对从快照压缩估计图(measurement)和从常规图像(RGB)重建出高光谱图像,我们分别提出了领域内第一个基于 Transformer 的方法,MST 与 MST++,以更少的参数量,更低的计算量取得了更高的性能。同时,我们的 MST++ 还取得了 NTIRE 2022 Challenge on Spectral Reconstruction 的第一名。

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()