The Devil Is in the Details: Window-based Attention for Image Compression

Renjie Zou, Chunfeng Song, Zhaoxiang Zhang

近年来,基于深度学习的图像压缩方法表现出比传统图像压缩方法具有更好的RD Performance。目前基于深度学习的图像压缩模型大都基于CNN。其主要缺点是CNN结构不是为捕捉局部细节而设计的,尤其是局部冗余信息,影响了重建质量。因此,如何充分利用全局结构和局部纹理成为基于深度学习图像压缩的核心问题。

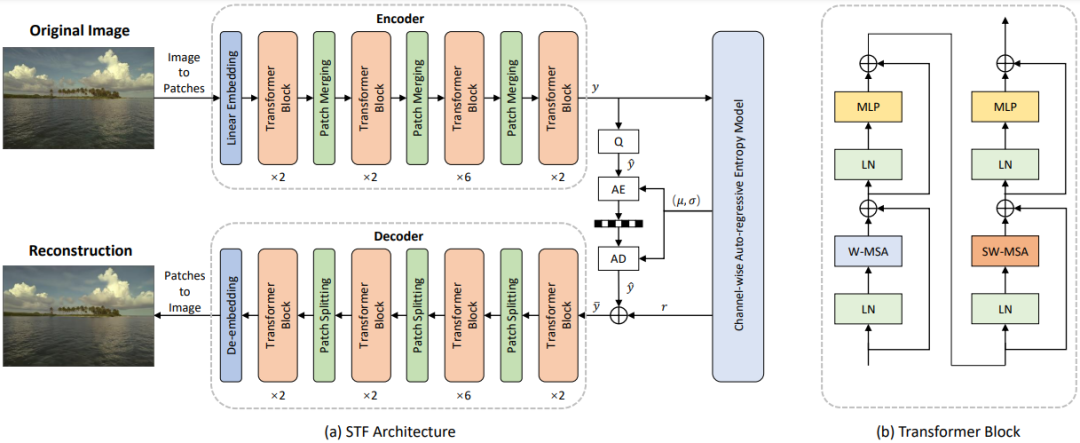

受到ViT和 Swin的启发,我们发现将局部感知注意力机制与全局相关特征学习相结合可以满足图像压缩的预期。在本文中,我们首先广泛研究了多种注意力机制对局部特征学习的影响,然后介绍了一种更直接有效的基于窗口的局部注意力块。所提出的基于窗口的注意力非常灵活,可以作为即插即用组件来增强图像压缩模型。此外,本文提出了一种新颖的Symmetrical Transformer框架,是Transformer在图像压缩领域的第一次探索。

基于本文设计的Symmetrical Transformer框架和CNN框架在基于PSNR和MS-SSIM的量化指标上,均取得了新的SOTA性能。此外,在主观质量上,也有明显的改善。代码近期将会开源:https://github.com/Googolxx/STF

Symmetrical Transformer结构设计

成为VIP会员查看完整内容

相关内容

【CVPR 2022】AME:超参数优化中的注意力和记忆增强,AME: Attention and Memory Enhancement in Hyper-Parameter Optimization

专知会员服务

11+阅读 · 2022年3月19日

专知会员服务

11+阅读 · 2022年3月19日

专知会员服务

15+阅读 · 2022年3月19日

专知会员服务

54+阅读 · 2020年3月3日

Arxiv

0+阅读 · 2022年4月18日