CVPR2019 | R-MVSNet: 一个高精度高效率的三维重建网络

点“计算机视觉life”关注,置顶更快接收消息!

1. 导读

目标读者:对MVS(multi-view stereo,多视几何)问题感兴趣的人群。MVS旨在利用多张影像(影像及对应的相机几何)恢复出三维场景。

论文作者:香港科技大学和深圳Altizure公司的研究团队。

简介: 该团队于2018年提出了一个高精度高效率的三维重建网络 —— MVSNet,被ECCV2018选为Oral。而今针对原MVSNet由于过于耗费内存而难以应用到大尺度场景的问题,提出了“R-MVSNet”(Recurrent MVSNet),该网络在原MVSNet的基础上进行改进,引入循环神经网络架构,可依序地在深度方向通过GRU单元正则化2D的代价图,较大程度地缓解了内存消耗,进而使大尺度的三维场景重建成为可能,该文章已被CVPR2019接收。

2. MVSNet回顾

由于R-MVSNet是在原MVSNet上进行的改进,故对MVSNet进行回顾有一定必要性。

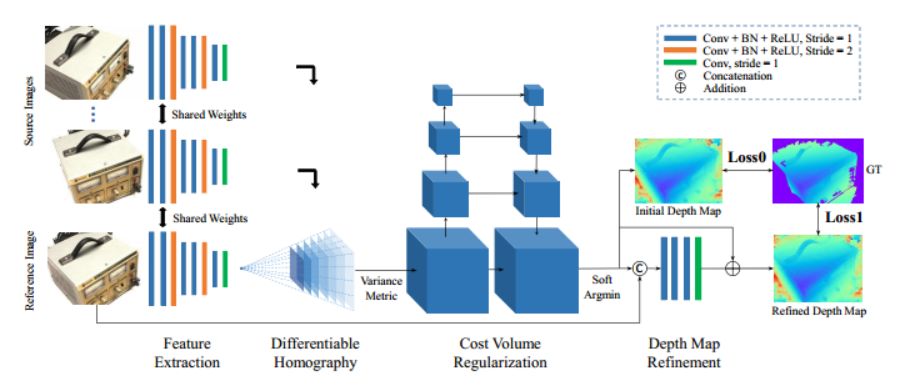

MVSNet网络架构如图一所示:

图一:MVSNet网络架构

输入进网络的多视影像首先经由2D的特征提取层以及可微的单应矩阵变换以构建代价量,再经由三维卷积网络的优化得到三维概率空间,最后基于参考影像进行进一步优化。

MVSNet主要贡献在于:

通过可微单应矩阵(Differentiable Homography)将相机几何嵌入到网络,以帮助实现端到端的深度神经网络。

设计了基于方差的多视匹配代价计算准则,将任意数量的像素特征向量映射为一个匹配代价向量,以帮助网络适用于不定数量的图像输入。

3. R-MVSNet介绍

R-MVSNet相较于MVSNet,引入了循环神经网络架构,依序地在深度方向通过GRU单元正则化2D的代价图,以减少内存消耗进而使其适用于大尺度的三维场景重建。

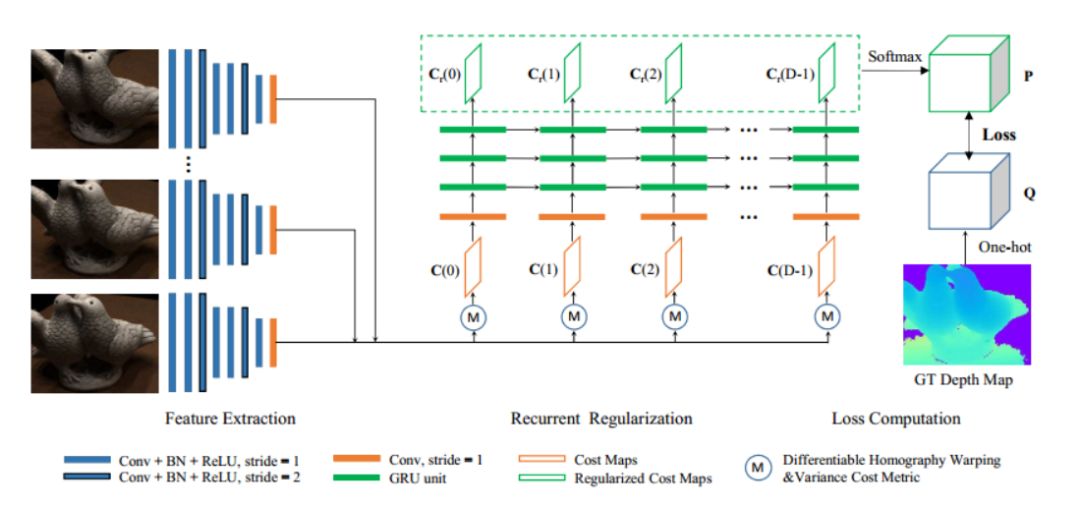

MVSNet网络架构如图二所示:

图二:R-MVSNet网络架构

输入的多视影像首先经由2D的特征提取层提取特征,经由可微的单应矩阵变换到参考影像的相机视锥体的正面平行面上,然后在不同深度计算代价,并经由卷积的GRU单元进行正则化,使在深度方向获取几何和单向的语义信息成为可能。该网络将问题视为分类问题,以交叉熵作为损失函数。

在完整的三维重建的流程中,除去R-MVSNet所担任的生成深度图的模块,其他非学习的模块还包括预处理,深度图优化,深度图滤波与融合。

4. 实验及结果

网络在DTU数据集上进行训练,实现框架为tensorflow。

测试数据集有DTU,Tanks and Temples,ETH3D( 图二:数据集具体结介绍见论文 )。

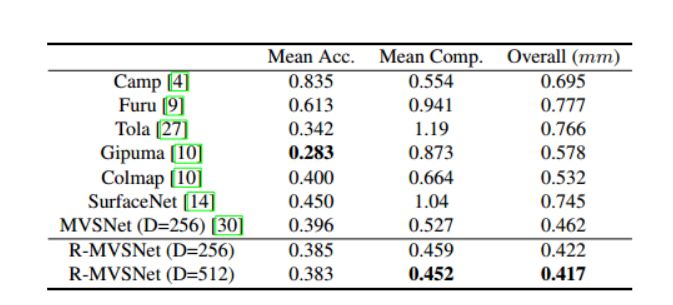

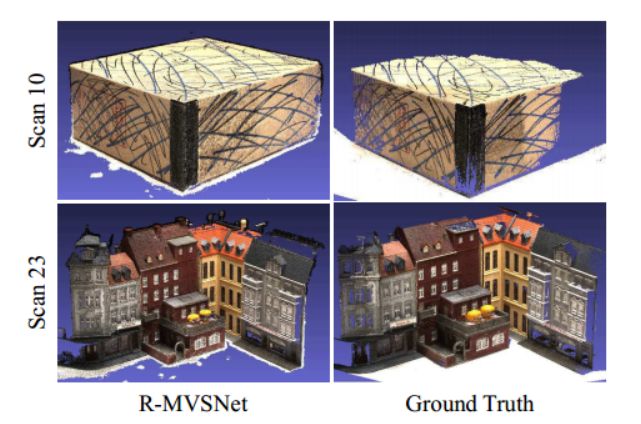

在DTU数据集上进行测试的定量结果图如图三所示,结果表明就重建的完整性和整体的质量而言该方法优于其他的方法。重建效果如图四所示。

图三:以DTU为测试集的定量结果

图四:在DTU数据中Scan23和Scan10上的重建结果及Groud Truth

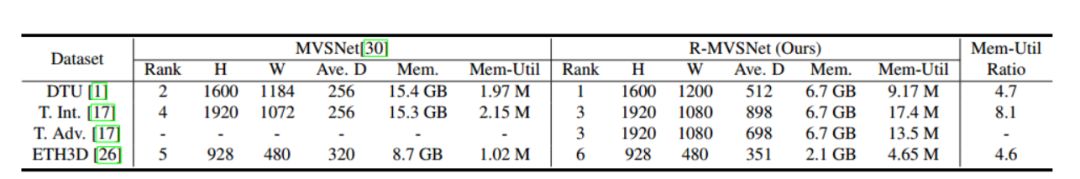

R-MVSNet和MVSNet在各测试数据集上的表现对比如图五所示,结果表明R-MVSNet的表现明显优于MVSNet,成倍地减小了内存消耗,可处理更大尺度的三维场景。

图五:R-MVSNet与MVSNet在各测试数据集上的表现对比。

5. 论文及代码链接

论文链接:

https://arxiv.org/abs/1902.10556

代码链接:

https://github.com/YoYo000/MVSNet

相关文章

欢迎关注公众号:计算机视觉life,一起探索计算机视觉新世界~

好文!给个好看啦~