【泡泡图灵智库】用于单目深度估计的深度有序回归网络

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Deep Ordinal Regression Network for Monocular Depth Esitimation

作者:Huan Fu Mingming Gong Chaohui Wang Kayhan Batmanghelich Dacheng Tao

来源:CVPR 2018

编译:尹双双

审核:杨健博

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——用于单目深度估计的深度有序回归网络,该文章发表于CVPR 2018。

单目的深度估计作为理解3D场景几何的重要部分,其求解是一个不适定问题。利用深度卷积神经网络(DCNNs)获取的影像级信息和分层特征,目前的解决方法已有很大进步。这些方法把深度估计建模为一个回归问题,并且用均方差最小化来训练回归网络,但缓慢的收敛速度和不理想的局域解都会对其产生影响。另外,现有的深度估计网络采用重复空间池化,会导致不理想的低分辨率特征图。为了获得高分辨的深度图,需要跳连接层或者多层去卷积的网络,这使得网路训练变得复杂,消耗更多的计算量。为了消除或者至少很大程度地减少这些问题,本文引入一个空间增加离散化(SID)策略来离散化深度,再当作一个有序回归问题来重塑深度深度网络学习。通过用一个有序回归损失训练网络,本文的方法可以同时取得更高的精度和更快的收敛。我们还采用了一个多尺度网络结构,避免了不必要的空间池化,平行地捕获多尺度信息。提出的深度有序回归网络(DORN)在KITTI,make3D和NYU Depth v2这3个数据集上的测试结果达到了最先进的水平。

主要贡献

采用一个空间增加离散(SID)策略来将连续的深度值离散化为一些整数。

考虑离散深度值的等级,采用有序回归损失来训练深度卷积神经网络。

提出一个避免不必要子抽样的网络框架,可以不用跳跃连接而更简单地获取多尺度信息。

算法流程

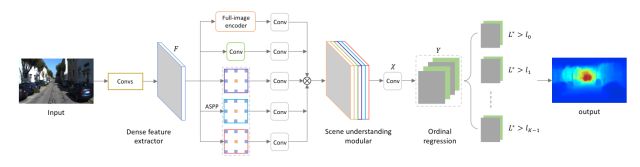

图1 网络架构图

包含一个密集特征提取器,多尺度特征学习(ASPP),跨通道信息学习(纯1*1卷积分支),一个全影像编码器和有序回归优化器。Conv组成全是用1*1内核。ASPP模块包含3个3*3内核的扩张卷积层,扩张比率分别是6,12和18。网络的监督信息是用SID策略离散化输出的深度值。用一个端对端的有序回归训练损失优化整个网络。

第一步:构建网络。

特征提取器:移去DCNNs中最后几个降采样操作,在随后的conv层的过滤中插入空洞,即扩张卷积来扩大过滤的视场。

场景理解模块:3个组成部分,atrous空间金字塔池化,跨通道学习和全影像编码。

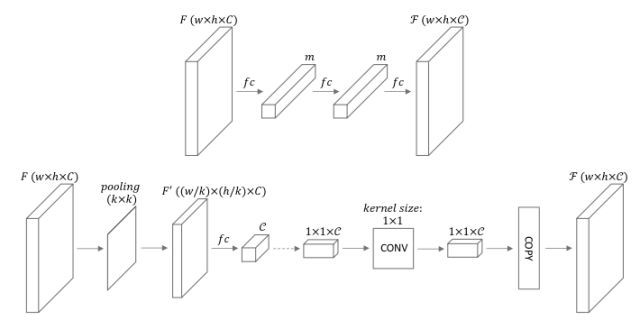

图2 全影像编码器。

上:用纯fc层(δ <1.25:0.910)实现的编码器;下:本文编码器(δ < 1.25: 0.915)。

首先用一个小内核和步长的平均池化层来降低空间维度,然后用一个fc层来获得维度为C的特征矢量,把它看做空间维度为1*1的C通道的特征地图,并加入一个内核大小1*1的卷积层来作为跨通道参数池化结构。最后我们沿着空间维度将特征向量复制到F,这样F的每个位置都对整个图像有相同的理解。

第二步:Spacing-Increasing离散化。

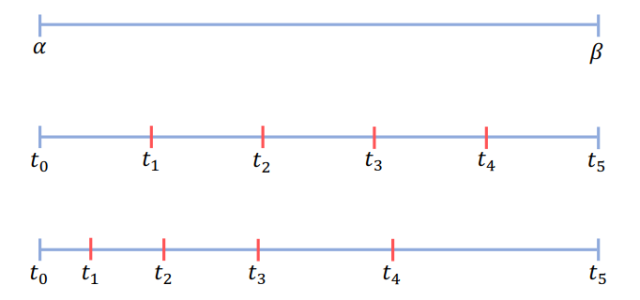

图3 离散间隔。

UD(中)和SID(下)把离散深度区段[α, β]分成5个子区段。

ti∈{t0,t1,...,tk}表示离散化阈值。本文中给α 和β都加了一个偏移值ξ来得到α∗和β∗,α∗=α +ξ =1.0,在[α∗, β∗]区间应用SID。

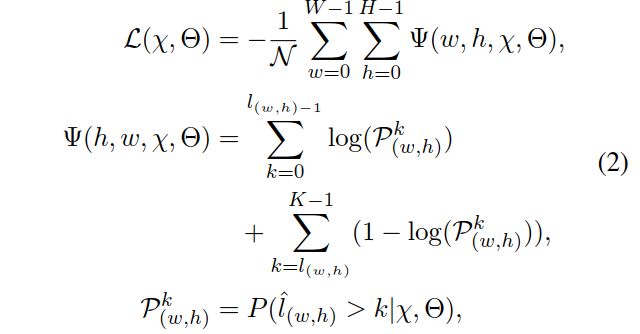

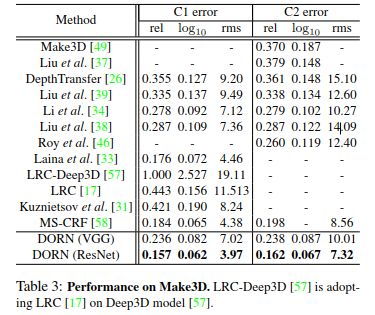

第三步:学习和推理

获得离散深度值后,将标准回归问题直接转化为一个序数回归问题,采用softmax回归损失学习在深度估计网络中的参数。

在获得影像I上每个位置的有序标签后,预测的深度值被解译为:

主要结果

文章结果:

1. 数据集测试。

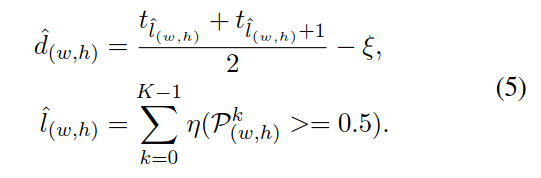

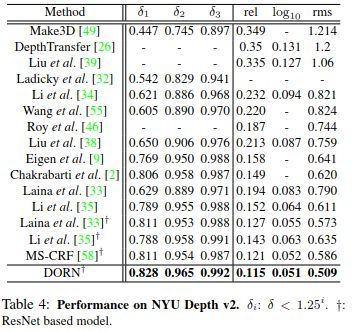

表1 KITTI上所有方法结果

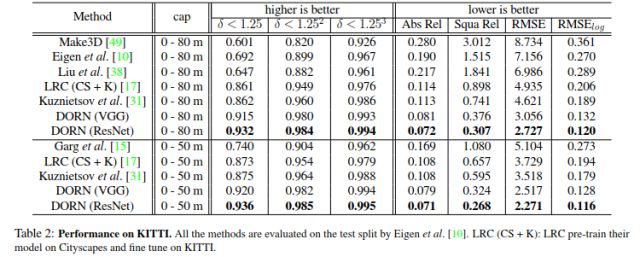

表2 Make3D上的实验结果

表3 NYU Depth v2上的实验结果

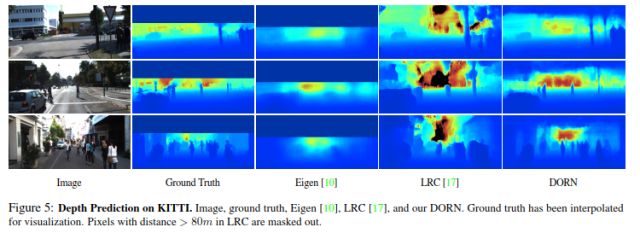

图4 在KITTI上的深度预测

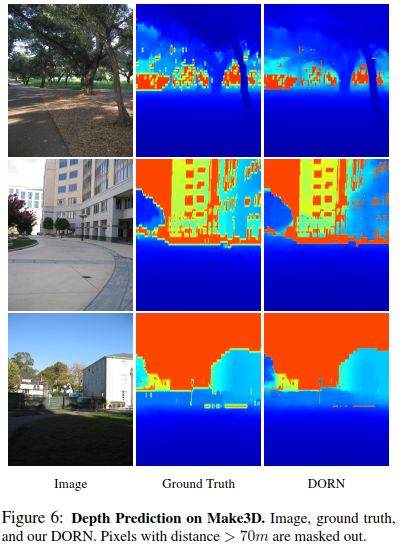

图5 在Make3D上的深度预测

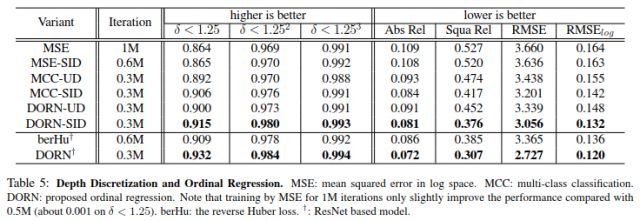

2、深度离散化

表4 深度离散化和有序回归。根据表中的得分可知,对连续深度的回归训练似乎比其他两种方法收敛的更差,我们的有序回归网络的性能最好。SID和UD离散化有很明显的区别,且用BerHu代替我们的有序回归损失时,DORN仍然能得到更高的分数。

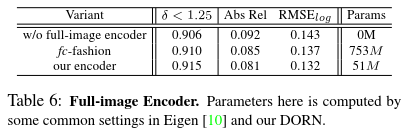

3、全影像编码器

表5 我们的全影像编码器可以比fc类的编码器有高一点的分数,但是显著减少了参数量。

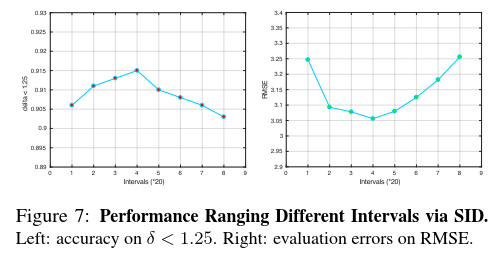

4、深度区间数

图6 用SID将深度值离散化成多个区间,在40~120个区间中,DORN得分范围为[0.908,0.915], δ < 1.25,在RMSE方面得分为[3.056,3.125],因此对一个较长的区间数是鲁棒的。

Abstract

Monocular depth estimation, which plays a crucial role in understanding 3D scene geometry, is an ill-posed problem. Recent methods have gained significant improvement by exploring image-level information and hierarchical features from deep convolutional neural networks (DCNNs).These methods model depth estimation as a regression problem and train the regression networks by minimizing mean squared error, which suffers from slow convegence and unsatisfactory local solutions. Besides, existing depth estimation networks employ repeated spatial pooling operations,resulting in undesirable low-resolution feature maps. To obtain high-resolution depth maps, skip-connections or multi-layer deconvolution networks are required, which complicates network training and consumes much more computations. To eliminate or at least largely reduce these problems, we introduce a spacing-increasing discretization(SID) strategy to discretize depth and recast depth network learning as an ordinal regression problem. By training the network using an ordinary regression loss, our method achieves much higher accuracy and faster convergence in synch. Furthermore, we adopt a multi-scale network structure which avoids unnecessary spatial pooling and captures multi-scale information in parallel. The proposed deep ordinal regression network (DORN) achieves state-of-the-art results on three challenging benchmarks, i.e., KITTI ,Make3D, and NYU Depth v2, and outperforms existing methods by a large margin.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com