题目: NETWORK DECONVOLUTION

摘 要:

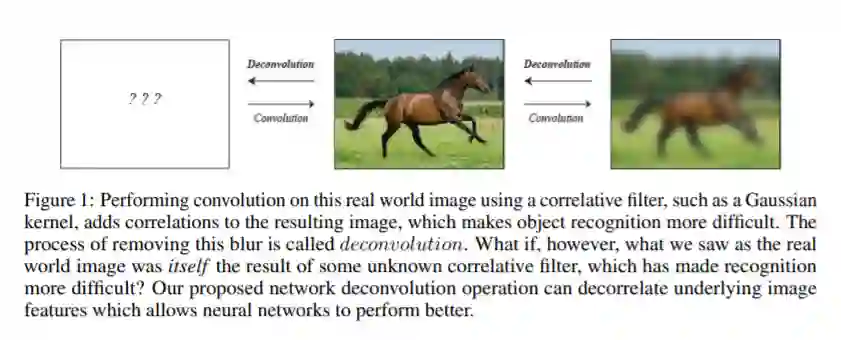

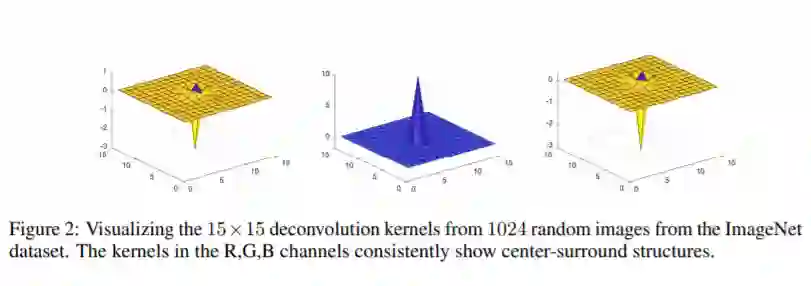

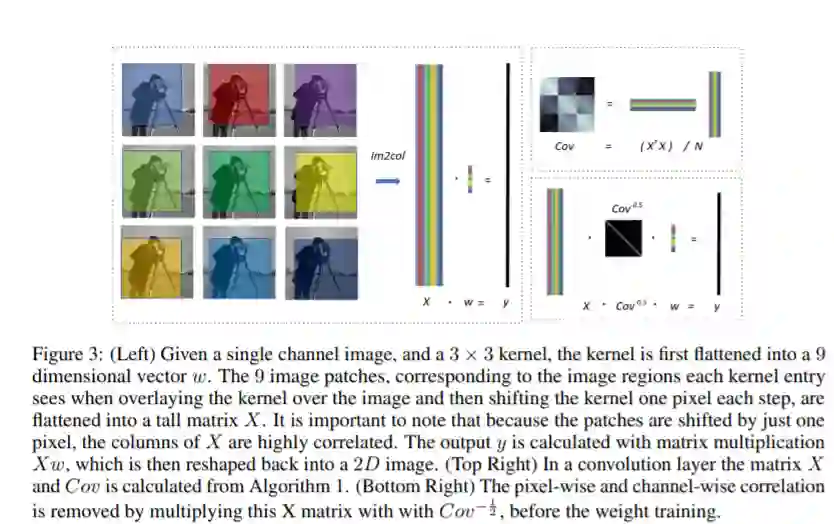

卷积是卷积神经网络(CNNs)的核心操作,它将一个核函数应用于图像上移位的重叠区域。然而,由于实际图像数据具有很强的相关性,卷积核实际上是对冗余数据的再学习。在这项工作中,我们证明了这种冗余使神经网络训练具有挑战性,并提出了网络反褶积,这是一种在数据被输入到每一层之前最优地去除像素和信道相关的方法。网络反褶积可以有效地计算在一个卷积层的计算成本的一小部分。我们还发现,网络第一层的反褶积滤波器与大脑视觉区域的生物神经元中发现的中央环绕结构相似。使用这种内核进行过滤会得到一个稀疏表示,这是神经网络训练中所缺少的一个理想特性。在不使用批处理标准化的情况下,从稀疏表示中学习可以促进更快的收敛和更好的结果。我们将我们的网络反褶积操作应用到10个现代神经网络模型中,在每个模型中替换批量归一化。大量的实验表明,在CIFAR-10、CIFAR-100、MNIST、Fashion-MNIST、Cityscapes和ImageNet数据集的所有情况下,网络反卷积操作都能够提供性能改进。

成为VIP会员查看完整内容

相关内容

专知会员服务

26+阅读 · 2020年3月26日

专知会员服务

14+阅读 · 2020年1月1日

专知会员服务

26+阅读 · 2019年11月23日

Arxiv

9+阅读 · 2019年2月21日