用于RGB-D室内场景语义分割的门式融合局部感知反卷积网络

摘要

大家好,今天为大家带来的文章是"Locality-Sensitive Deconvolution Networks with Gated Fusion for RGB-D Indoor Semantic Segmentation"——用于RGB-D室内场景语义分割的门式融合局部感知反卷积网络,该文章选自CVPR2017。

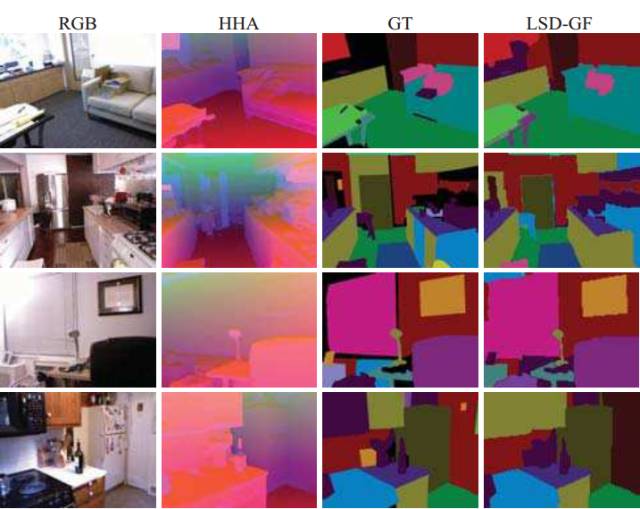

从左至右依次是彩色图,HHA图,Ground Truth和网络的预测结果

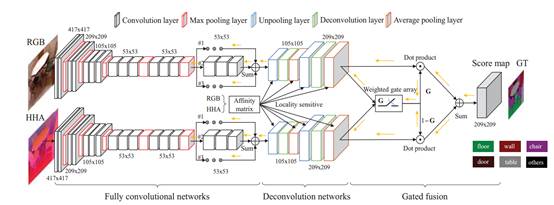

这篇文章使用RGB-D数据进行室内场景的语义分割。尽管常用的反卷积网络在这一问题上实现了令人印象深刻的效果,但我们发现这一问题在以下两方面还有继续提升的空间。

其中之一是边缘分割。反卷积网络使用更多的像素来预测每个像素的类别。这一行为隐含的限制了物体边缘的分割精度。另一方面是彩色图像和深度图像数据融合的问题。近些年来最好的方法一般都使用相等的权值来融合两者。但是这一做法并没有考虑到这两者对于不同场景下不同类别的表达能力的差异。

为了解决这两个问题,我们第一个提出了局部感知的反卷积神经网络(LS-DeconvNet)。LS-DeconvNet使用RGB-D数据,在每一个反卷积层结合了局部视觉信息和几何信息。我们的做法使网络不仅能够有更大的感受域,同时也可以恢复出更加精细的物体边缘。对于RGB-D数据的融合,我们引入了一个门式融合的层来有效的结合两个LS-DeconvNets。这一层可以学习RGB和Depth数据在每一个像素上的融合权值。

我们的算法在 SUN RGB-D和NYU-Depthv2取得了最好的效果。

转自:泡泡机器人SLAM

登录查看更多

相关内容

Arxiv

7+阅读 · 2019年8月28日