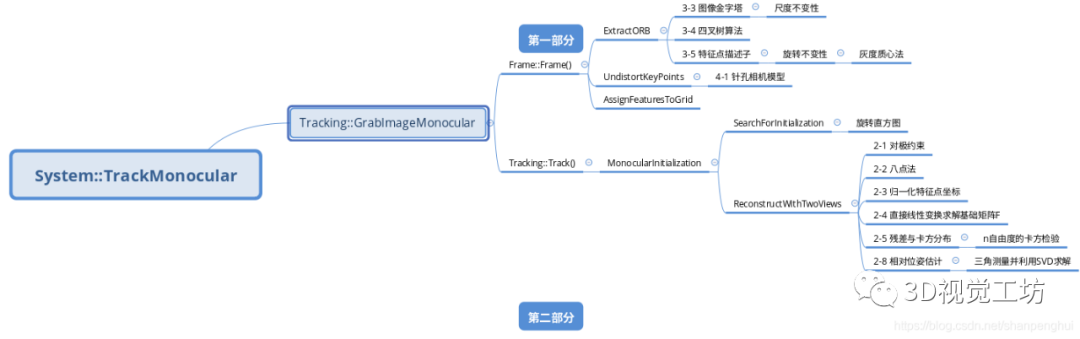

ORB-SLAM3 细读单目初始化过程(上)

点击上方“计算机视觉life”,选择“星标”

快速获得最新干货

本文转自3D视觉工坊

1.Frame::Frame()

1)作用

2)主要的三个函数 ExtractORB UndistortKeyPoints AssignFeaturesToGrid

对这个单目图像进行提取特征点 Frame::ExtractORB

用OpenCV的矫正函数、内参对提取到的特征点进行矫正 Frame::UndistortKeyPoints

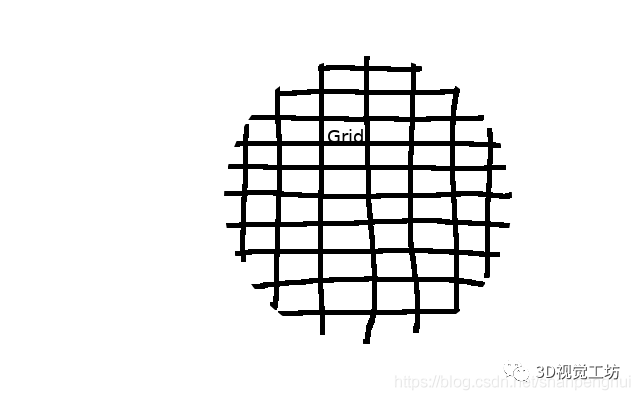

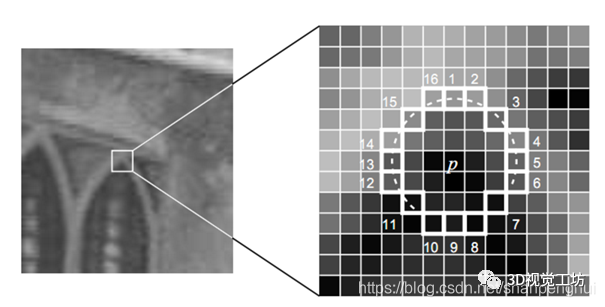

将特征点分配到图像网格中 Frame::AssignFeaturesToGrid

3)Frame::ExtractORB

3-1)作用

3-2)主要的函数 ComputePyramid ComputeKeyPointsOctTree computeDescriptors

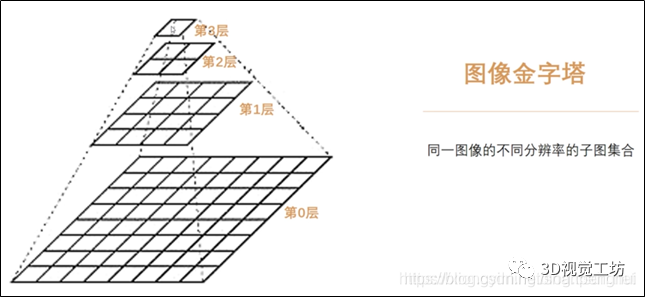

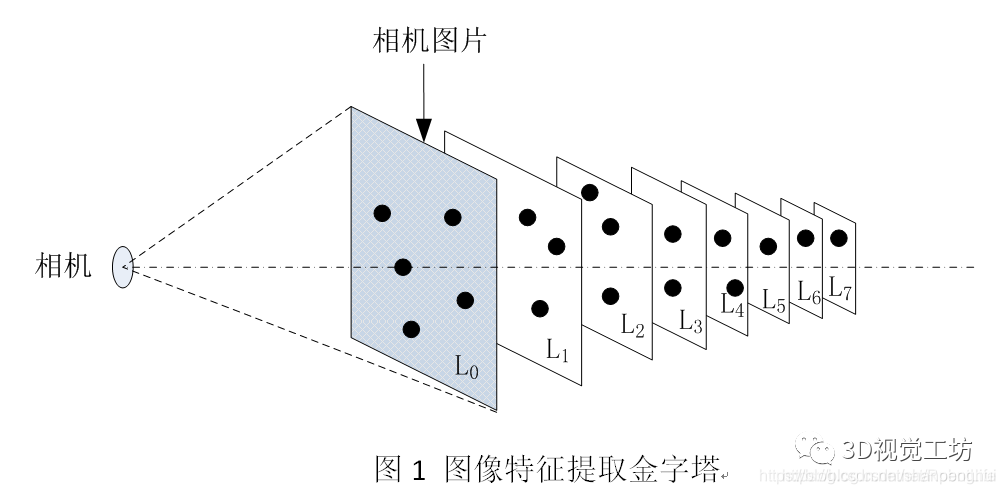

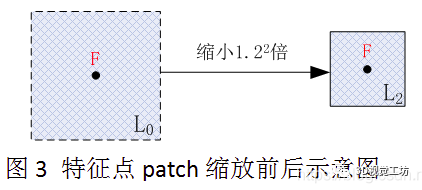

构建图像金字塔 ORBextractor::ComputePyramid

利用四叉树算法均分特征点 ORBextractor::ComputeKeyPointsOctTree

计算某层金字塔图像上特征点的描述子 static ORBextractor::computeDescriptors

3-3)构建图像金字塔 ComputePyramid

3-3-1图像金字塔是什么东东?

3-3-2代码怎么实现图像金字塔?

resize(mvImagePyramid[level-1], mvImagePyramid[level], sz, 0, 0, INTER_LINEAR);

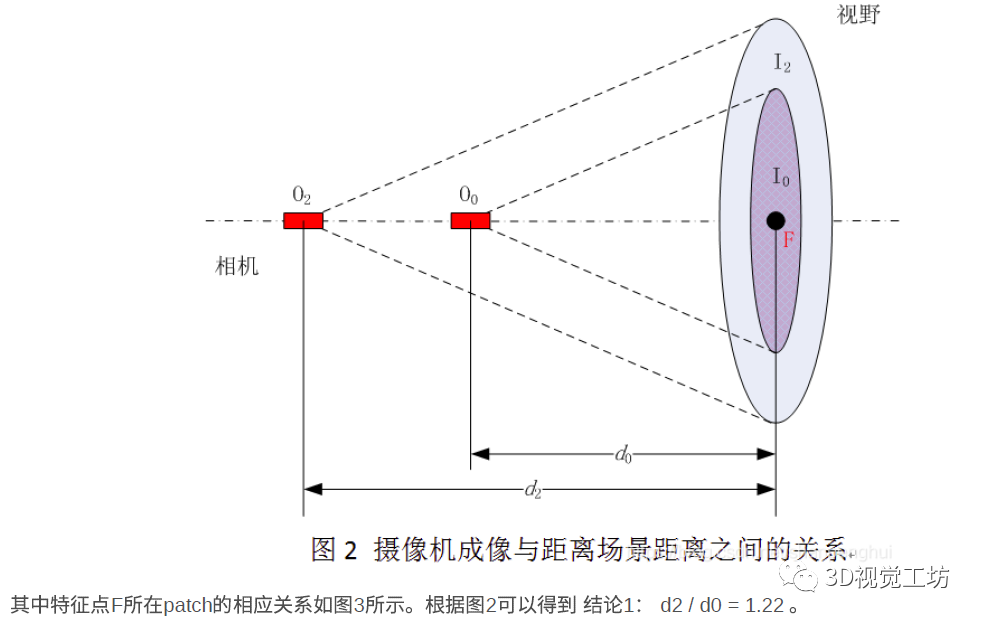

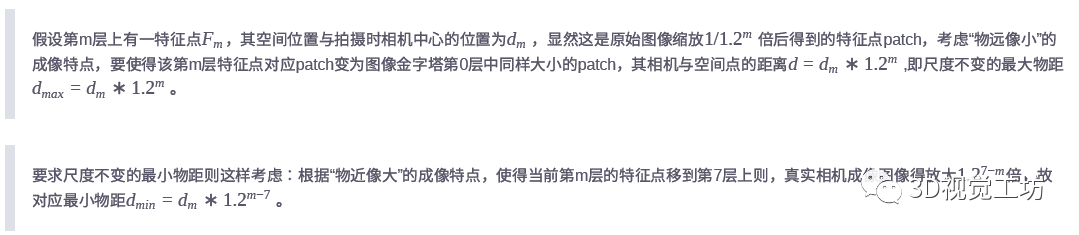

3-3-3尺度不变性是什么东东?

3-3-4代码哪里用到了尺度不变性?

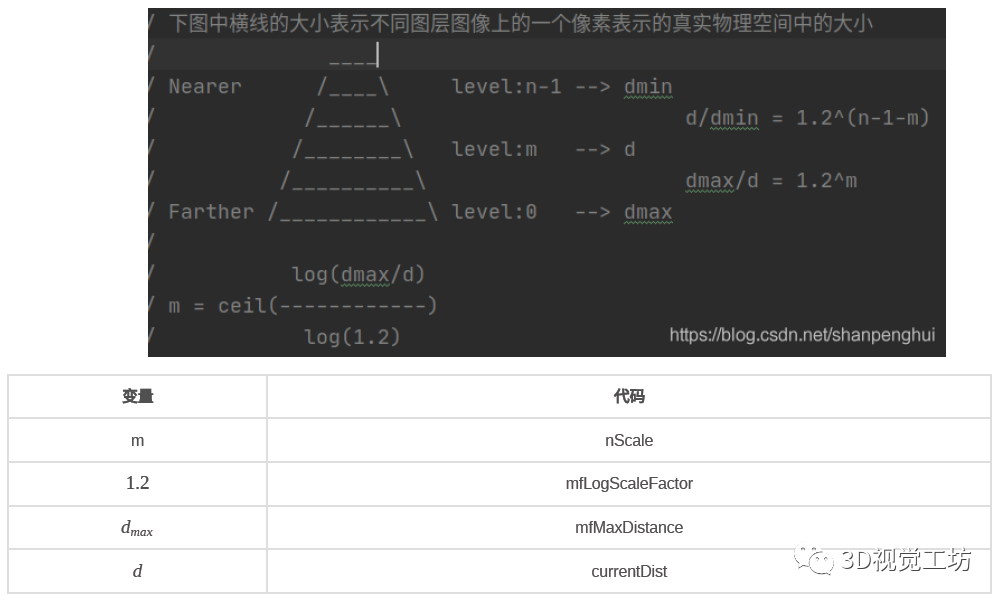

3-3-4-1MapPoint::PredictScale

ratio = mfMaxDistance/currentDist;

int nScale = ceil(log(ratio)/pKF->mfLogScaleFactor);

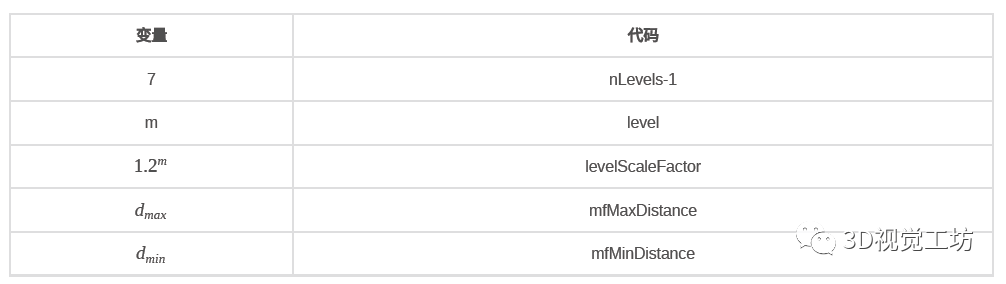

3-3-4-2MapPoint::UpdateNormalAndDepth

// 观测相机位置到该点的距离上限

mfMaxDistance = dist*levelScaleFactor;

// 观测相机位置到该点的距离下限

mfMinDistance = mfMaxDistance/pRefKF->mvScaleFactors[nLevels-1];

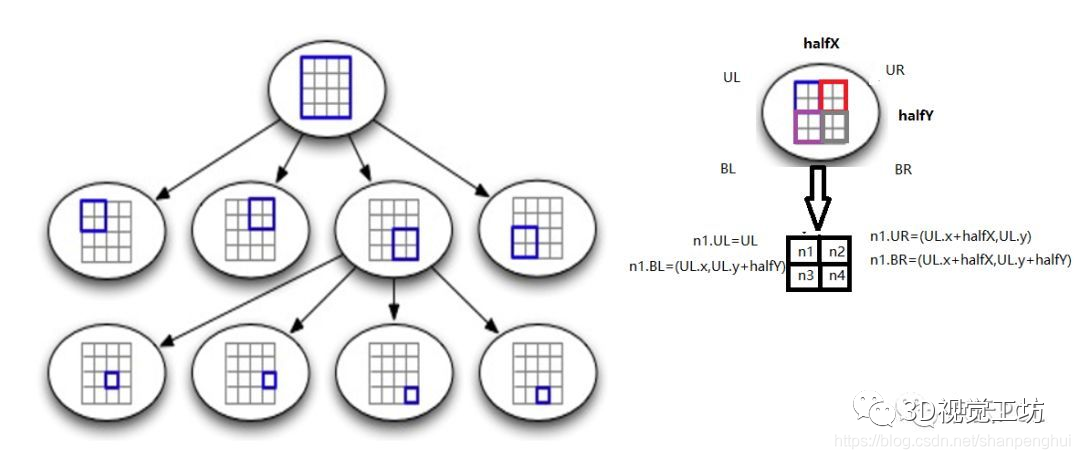

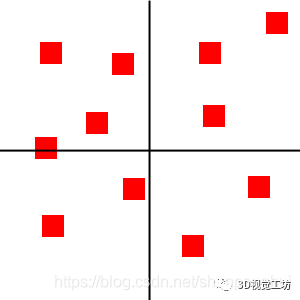

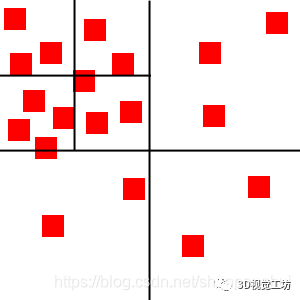

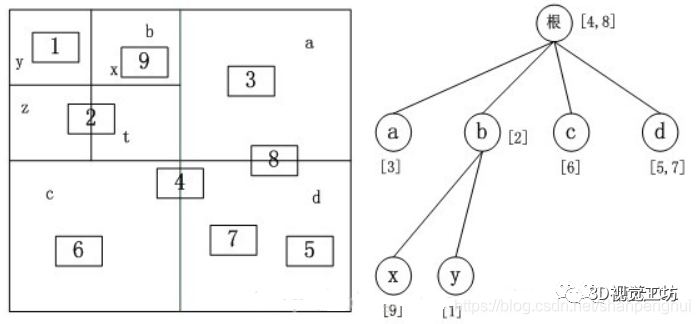

3-4)四叉树算法 ComputeKeyPointsOctTree

3-4-1四叉树是什么东东?

3-4-2四叉树用来干嘛?

3-4-3代码怎么实现的?

-

输入图像未分的关键点 对应ORBextractor::DistributeOctTree函数中的形参 vToDistributeKeysORBextractor.cc#L537 -

根据图像区域构造初始的根结点,每个根结点包含图像的一个区域,每个根结点同样包括4个子结点 定义一个提取器 ExtractorNode ni;ORBextractor.cc#L552设置提取器节点的图像边界 ni.UL ni.UR ni.BL ni.BRORBextractor.cc#L552-L556将刚才生成的提取节点添加到列表中 lNodes.push_back(ni);ORBextractor.cc#L559存储这个初始的提取器节点句柄 vpIniNodes[i] = &lNodes.back();ORBextractor.cc#L560 -

将未分的所有关键点分配给2中构造的根结点,这样每个根节点都包含了其所负责区域内的所有关键点 按特征点的横轴位置,分配给属于那个图像区域的提取器节点 vpIniNodes[kp.pt.x/hX]->vKeys.push_back(vToDistributeKeys[i]);ORBextractor.cc#L567 -

根结点构成一个根结点list,代码中是lNodes用来更新与存储所有的根结点 遍历lNodes,标记不可再分的节点,用的标记变量是 lit->bNoMoreORBextractor.cc#L576

-

当列表中还有可分的结点区域的时候: while(!bFinish)ORBextractor.cc#L592 -

开始遍历列表中所有的提取器节点,并进行分解或者保留: while(lit!=lNodes.end())ORBextractor.cc#L604 -

判断当前根结点是否可分,可分的意思是,它包含的关键点能够继续分配到其所属的四个子结点所在区域中(左上,右上,左下,右下),代码中是判断标志位 if(lit->bNoMore)ORBextractor.cc#L606意思是如果当前的提取器节点具有超过一个的特征点,那么就要进行继续细分 -

如果可分,将分出来的子结点作为新的根结点放入INodes的前部,e.g. lNodes.front().lit = lNodes.begin();ORBextractor.cc#L626,就是在四个if(n*.vKeys.size()>0)条件中执行。然后将原先的根结点从列表中删除,e.g.lit=lNodes.erase(lit);ORBextractor.cc#L660。由于新加入的结点是从列表头加入的,不会影响这次的循环,该次循环只会处理当前级别的根结点。 -

当所有结点不可分,e.g (int)lNodes.size()==prevSizeORBextractor.cc#L667,或者结点已经超过需要的点(int)lNodes.size()>=NORBextractor.cc#L667时,跳出循环bFinish = true;ORBextractor.cc#L669。

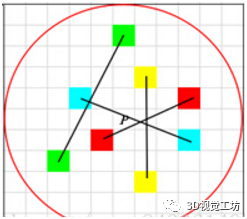

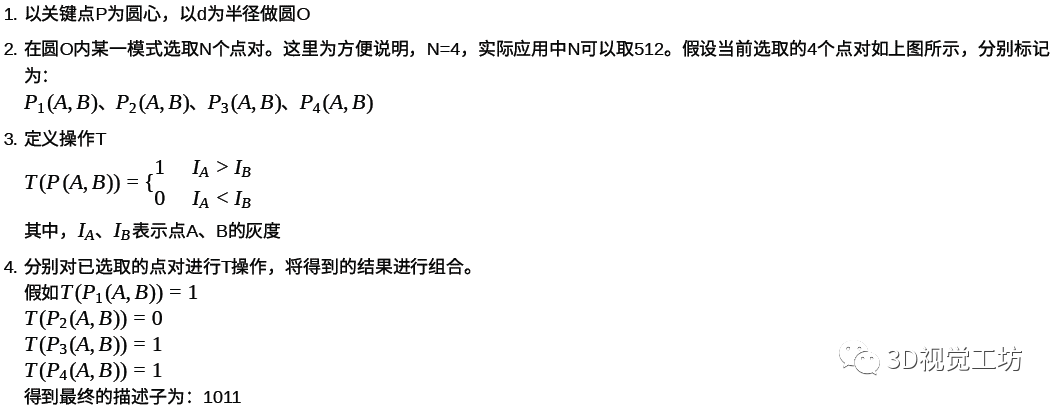

3-5)计算特征点描述子 computeDescriptors

3-5-1描述子是什么东东?

3-5-2计算特征描述子

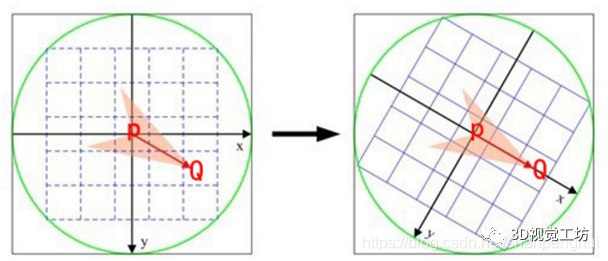

3-5-3如何保证描述子旋转不变性?

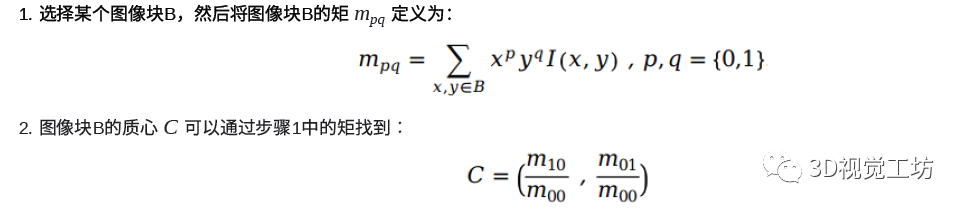

3-5-4如何计算上面提到的质心?灰度质心法

3-5-5代码如何实现?

-

首先取出关键点P。 const uchar* centerORBextractor.cc#L79 -

因为实现中利用了一个技巧,就是同时计算圆对称上下两条线的和,这样可以加速计算过程。所以计算中间的一条线上的点的和进行单独处理。 m_10 += u * center[u];ORBextractor.cc#L82 -

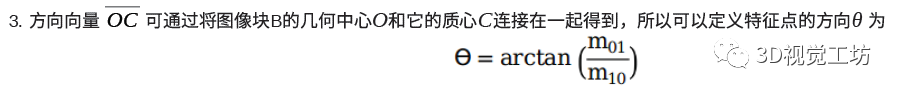

要在一个图像块区域 HALF_PATCH_SIZE中循环计算得到图像块的矩,这里结合四叉树算法,要明白在ORBSLAM中一个图像块区域的大小是30,而这里说过,用了一个技巧是同时计算两条线,因此分一半,就是15,所以HALF_PATCH_SIZE=15 -

一条直线上的像素坐标开头和结尾分别是-d和d,所以 for (int u = -d; u <= d; ++u)ORBextractor.cc#L92 -

位于直线关键点P上方的像素点坐标是 val_plus = center[u + v*step]ORBextractor.cc#L94 -

位于直线关键点P下方的像素点坐标是 val_minus = center[u - v*step]ORBextractor.cc#L94 -

因为$m_{10}$只和X有关,像素坐标中对应着u,所以$m_{10}$ = X坐标*像素值 = u * (val_plus+val_minus) -

因为$m_{01}$只和Y有关,像素坐标中对应着v,所以$m_{01}$ = Y坐标*像素值 = v * v_sum = v * (循环和(val_plus - val_minus))ORBextractor.cc#L95

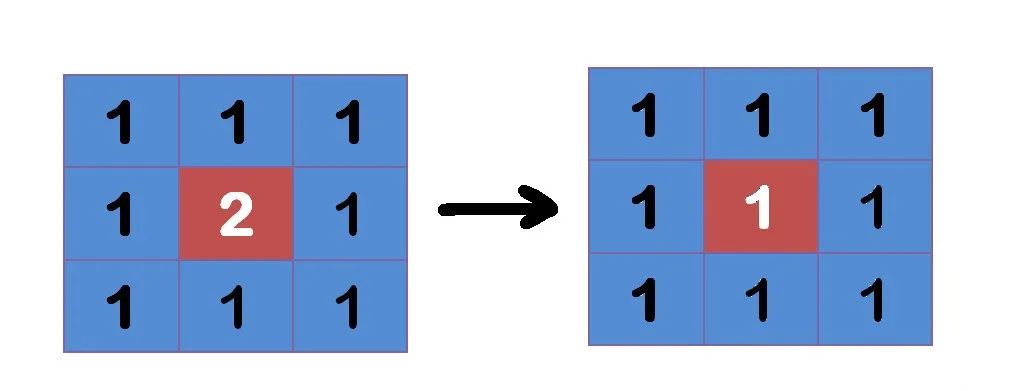

3-5-6高斯模糊是什么?有什么用?怎么实现?

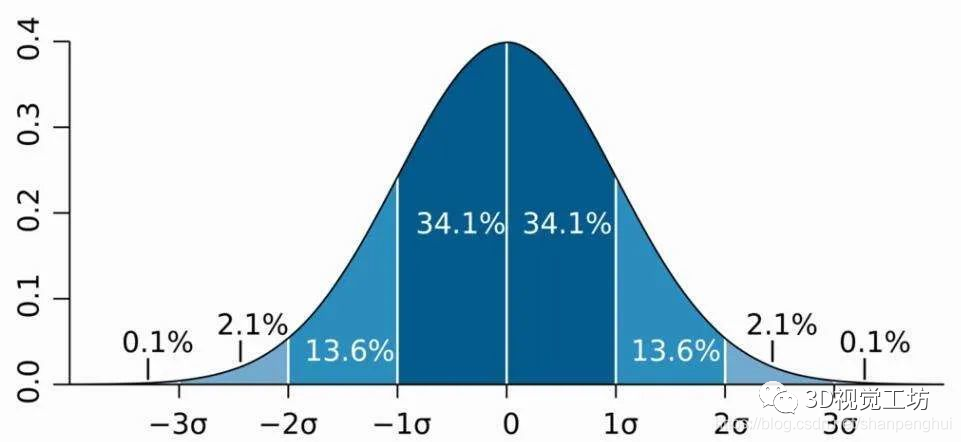

正态分布

卷积

卷积核

for (int level = 0; level < nlevels; ++level)

ORBextractor.cc#L1105,ORBSLAM都进行高斯模糊:ORBextractor.cc#L1115

GaussianBlur(workingMat, workingMat, Size(7, 7), 2, 2, BORDER_REFLECT_101);

3-5-7怎么实现描述子的计算?

desc[i]

为一个字节

val

8位,每一位是来自于两个像素点灰度的直接比较:ORBextractor.cc#L124

t0 = GET_VALUE(0); t1 = GET_VALUE(1);

val = t0 < t1; //描述子本字节的bit0

t0 = GET_VALUE(2); t1 = GET_VALUE(3);

val |= (t0 < t1) << 1; //描述子本字节的bit1

t0 = GET_VALUE(4); t1 = GET_VALUE(5);

val |= (t0 < t1) << 2; //描述子本字节的bit2

t0 = GET_VALUE(6); t1 = GET_VALUE(7);

val |= (t0 < t1) << 3; //描述子本字节的bit3

t0 = GET_VALUE(8); t1 = GET_VALUE(9);

val |= (t0 < t1) << 4; //描述子本字节的bit4

t0 = GET_VALUE(10); t1 = GET_VALUE(11);

val |= (t0 < t1) << 5; //描述子本字节的bit5

t0 = GET_VALUE(12); t1 = GET_VALUE(13);

val |= (t0 < t1) << 6; //描述子本字节的bit6

t0 = GET_VALUE(14); t1 = GET_VALUE(15);

val |= (t0 < t1) << 7; //描述子本字节的bit7

pattern += 16

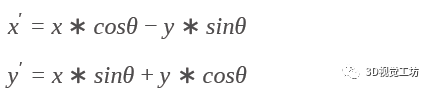

#define GET_VALUE(idx) center[cvRound(pattern[idx].x*b + pattern[idx].y*a)*step + cvRound(pattern[idx].x*a - pattern[idx].y*b)]

a = (float)cos(angle)

和

b = (float)sin(angle)

3-6)总结

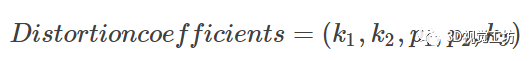

4)Frame::UndistortKeyPoints

Our goal is to abstract the camera model from the whole SLAM pipeline by extracting all properties and functions related to the camera model (projection and unprojection functions, Jacobian, etc) to separate modules. This allows our system to use any camera model by providing the corresponding camera module.In ORB-SLAM3 library, apart from the pinhole model, we provide the Kannala-Brandt fisheye model.

EVO Evaluation of SLAM 4 --- ORB-SLAM3 编译和利用数据集运行(https://blog.csdn.net/shanpenghui/article/details/109354918)

其中,矫正就是用的Pinhole模型,就是针孔相机模型,在代码中有体现Frame.cc#L751

cv::undistortPoints(mat,mat, static_cast<Pinhole*>(mpCamera)->toK(),mDistCoef,cv::Mat(),mK);

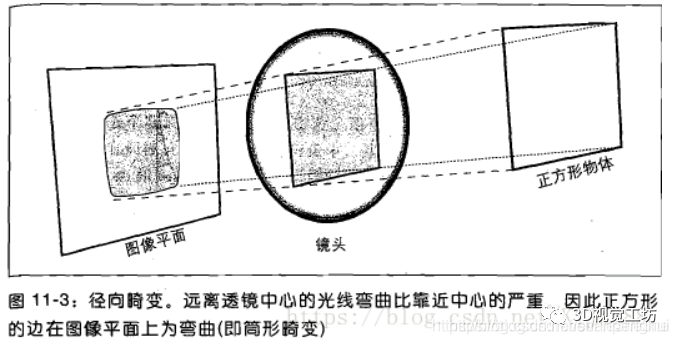

4-1为什么要矫正?

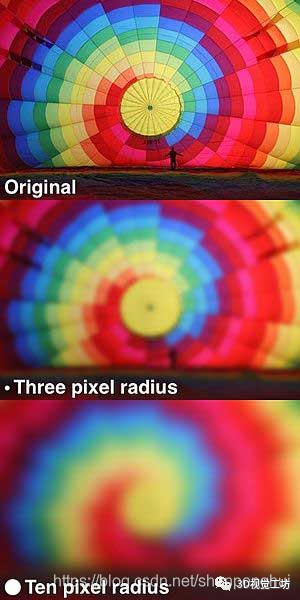

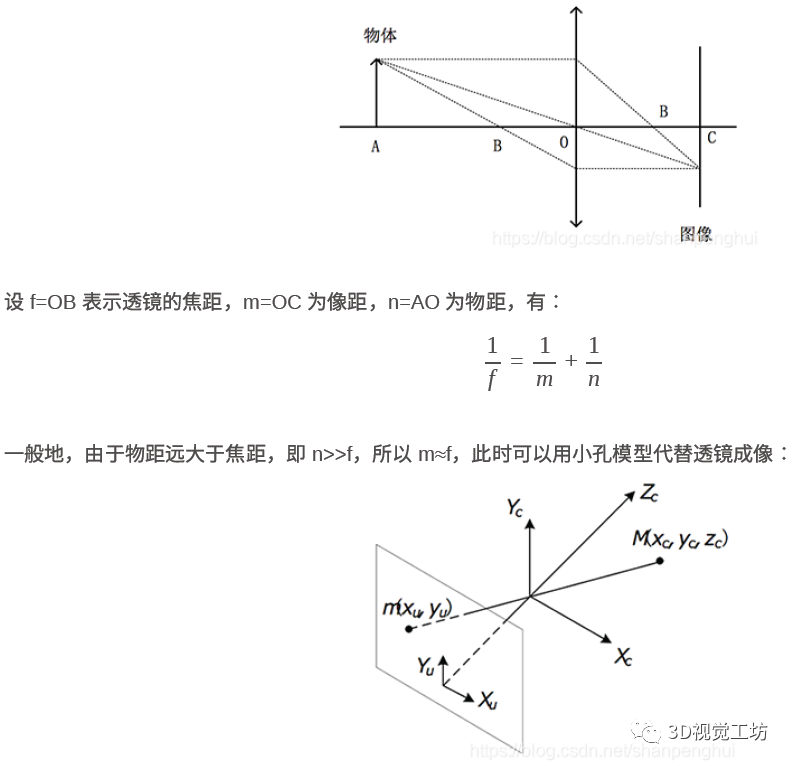

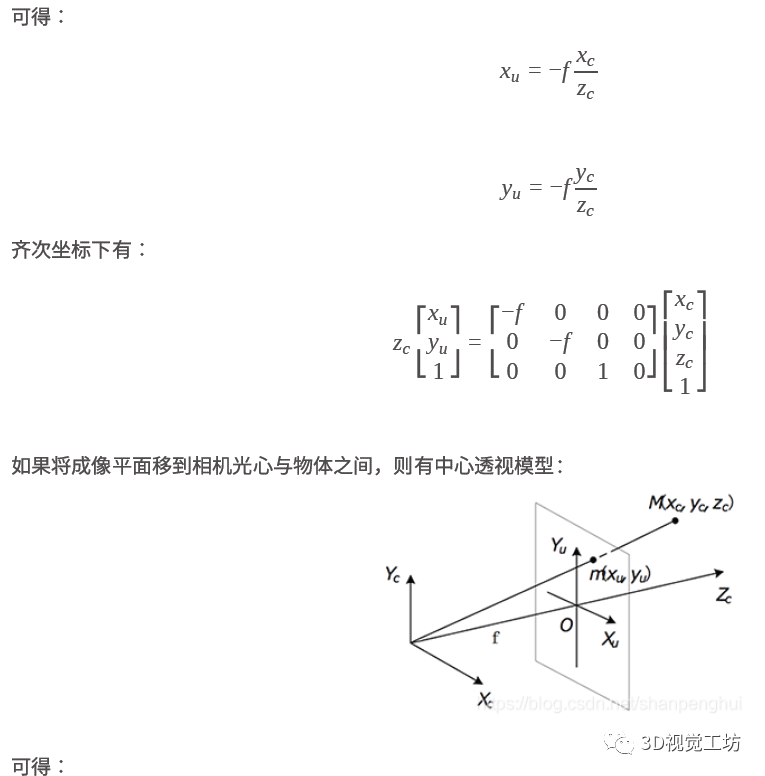

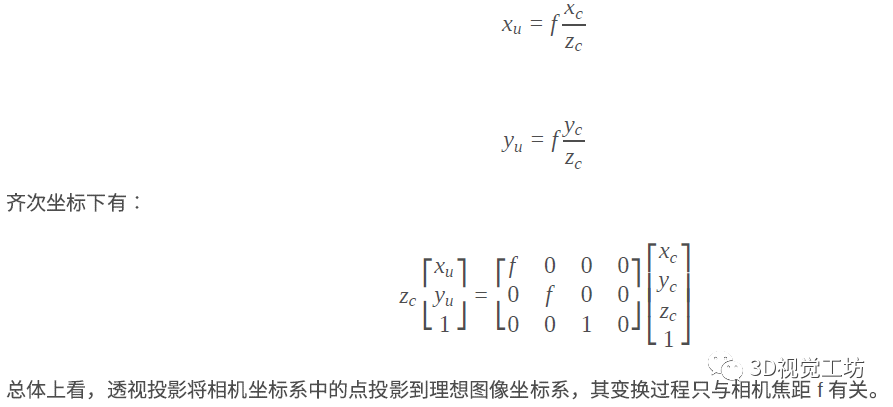

图像成像模型

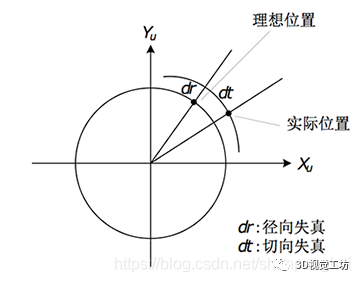

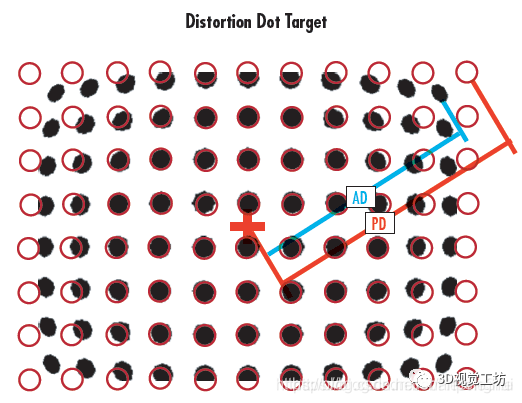

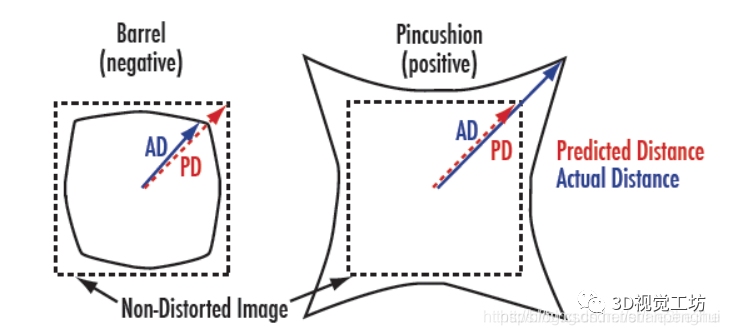

畸变校正

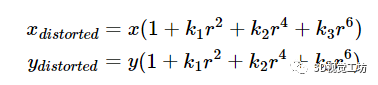

径向畸变(Radial Distortion)

-

正向畸变(枕型畸变):从图像中心开始,径向曲率逐渐增加。 -

负向畸变(桶形畸变):边缘的径向曲率小于中心的径向曲率。(鱼眼相机)

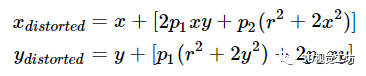

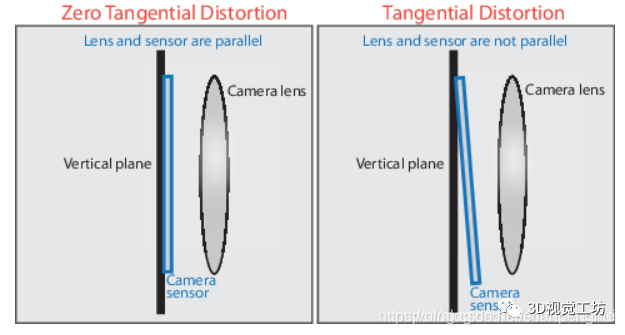

切向畸变(Tangential Distortion)

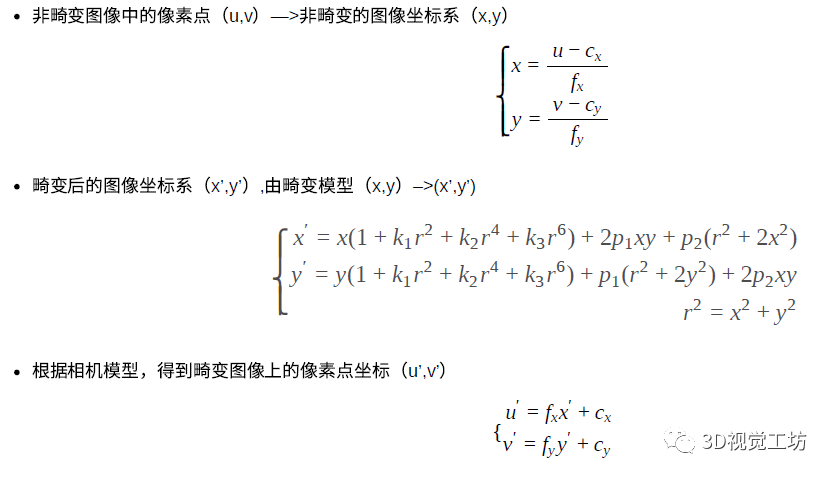

4-2怎么矫正?

4-3代码怎么实现?

-

首先判断是否需要去畸变。

if(mDistCoef.at<float>(0)==0.0)

-

利用OpenCV的函数进行矫正

cv::undistortPoints(mat,mat, static_cast<Pinhole*>(mpCamera)->toK(),mDistCoef,cv::Mat(),mK);

5)Frame::AssignFeaturesToGrid

Frame::GetFeaturesInArea

函数里面用的方法,变量

mGrid

联系了 AssignFeaturesToGrid 的结果和其他函数:Frame.cc#L676

for(int ix = nMinCellX; ix<=nMaxCellX; ix++)

{

for(int iy = nMinCellY; iy<=nMaxCellY; iy++)

{

const vector<size_t> vCell = (!bRight) ? mGrid[ix][iy] : mGridRight[ix][iy];

mGrid

这个结果在代码中,后面的流程里,有几个函数都要用:

SearchForInitialization 函数 单目初始化中用于参考帧和当前帧的特征点匹配

SearchByProjection 函数 通过投影地图点到当前帧,对Local MapPoint进行跟踪

-

先分配空间

mGrid[i][j].reserve(nReserve);

-

如果找到特征点所在网格坐标,将这个特征点的索引添加到对应网格的数组mGrid中

if(PosInGrid(kp,nGridPosX,nGridPosY))

mGrid[nGridPosX][nGridPosY].push_back(i);

6)总结

从0到1学习SLAM,戳↓

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

投稿、合作也欢迎联系:simiter@126.com

扫描关注视频号,看最新技术落地及开源方案视频秀 ↓

登录查看更多

相关内容

专知会员服务

14+阅读 · 2020年6月18日

专知会员服务

132+阅读 · 2020年3月22日

Arxiv

0+阅读 · 2021年4月23日

Arxiv

0+阅读 · 2021年4月22日