主题: An operator view of policy gradient methods

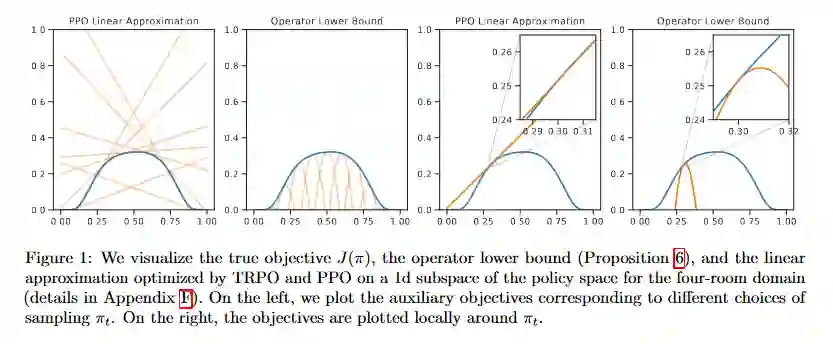

摘要: 我们将策略梯度方法转换为两个运算符的重复应用:策略改进运算符I(将任何策略π映射到更好的Iπ)和投影运算符P,其在可实现策略集中找到Iπ的最佳近似。 我们使用此框架来引入传统策略梯度方法(如Reinforce和PPO)的基于操作员的版本,从而更好地理解了它们的原始版本。 我们还利用对I和P作用的认识,提出了预期收益的新的全局下限。 这种新的视角使我们能够进一步弥合基于策略的方法和基于价值的方法之间的鸿沟,例如,展示了如何将Reinforce和Bellman最优算子视为同一枚硬币的两个方面。

成为VIP会员查看完整内容

相关内容

专知会员服务

17+阅读 · 2020年7月14日

专知会员服务

131+阅读 · 2020年4月19日

Arxiv

9+阅读 · 2018年4月22日