ICLR’22 最佳脑洞奖提名:《GPT 如何进行布朗运动?》

文 | 付瑶

编 | 小轶

今天给大家介绍一篇斯坦福大学的 ICLR'22 论文。该文在 OpenReview 中获得了8/8/8/8的高分。在写这篇推送之前,小编身边有多位朋友都私下向我推荐过这篇文章。虽然这几位朋友所研究的任务并不相同,却都认为这篇文章“极具启发性,可能可以应用于自己的任务”——这对一篇研究工作来说,大概是极高的评价了。故在此与大家分享。

文章解决的是预训练模型的长文本生成问题。做过文本生成的同学应该都见识过,如今的 GPT2 等一众大规模生成模型在生成短文本时可以做到十分流畅;但是做长文本生成的时候就开始前言不搭后语,一致性很差。比如,可能前面还在严肃地针砭时事,后面就突然画风走偏,聊起自己的兴趣爱好、家长里短。这是完全有可能的,因为预训练语言模型在做生成时是完全没有长期规划能力的。

那早此之前的解决方法,基本就是把长文本生成问题拆解为两个步骤:先写提纲,再根据提纲做条件生成。那列提纲的方式也有两种。常见的一种是列“显式的提纲”。和我们平时写提纲的方式差不多,把核心内容先提前规划出来。

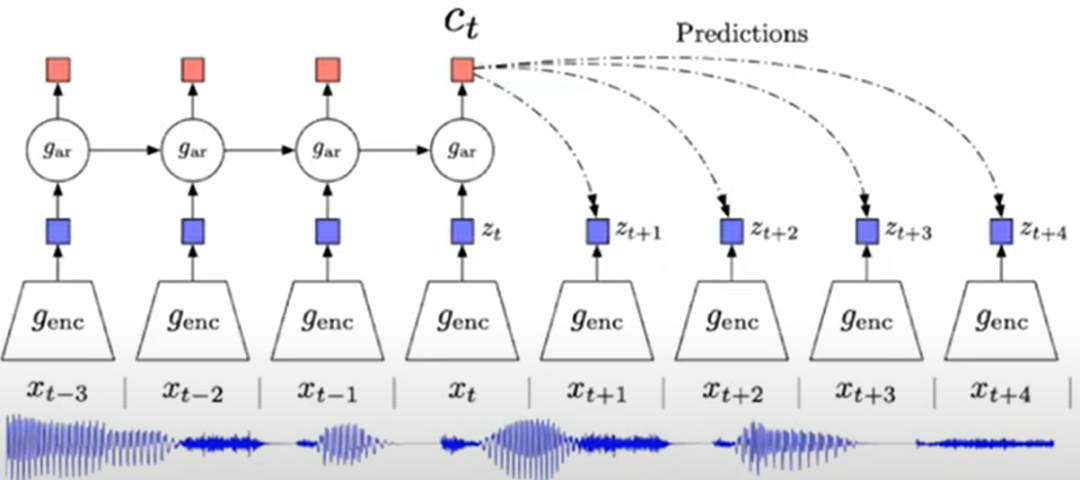

而本文的方法可以理解为“隐式的提纲”:假设每个词背后都有一个隐向量,而该词是基于该隐向量条件生成的,如下图所示。于是,长文本生成的规划问题就变成了学习预测文本在隐空间中的移动轨迹。本文进一步提出了两个假设:

-

文本在隐空间中的移动可以 建模为布朗运动的过程。通俗一点解释就是:相邻文本应该有相近的隐空间表示。这也就保证了局部流畅性。 -

目标导向的长文本规划中,文本在隐空间中的移动轨迹应当 有固定的起点和重点,也就是应当遵从布朗桥过程。

接下来,我们具体看看方法部分——本文是如何基于以上两个假设,实现有规划的文本生成?

论文标题:

Language modeling via stochastic processes

论文链接:

https://arxiv.org/abs/2203.11370

![]() 方法

方法![]()

本文中提出Time Control的方法,主要分为两个部分:

1. 基于布朗桥过程的编码器

首先训练一个编码器,将句子从文本空间X映射到隐空间Z,记为 。在隐空间中的移动轨迹应遵循布朗桥运动。也就是说,该轨迹的起点和终点固定,设为 和 ,则在时间点 t 时, 服从以下正态分布:

其均值是

和

之间随时间变化的线性插值。方差部分,可以直观理解为:在靠起点和终点处方差较小,而中间部分则方差较大(如下图左侧所示)。

那么,应该怎样训练一个编码器来拟合这个过程呢?对于句子序列 ,我们从中随机采样顺序(但未必相邻)的三个句子 。优化目标为:使得 遵循布朗桥运动轨迹。其目标函数可以写为:

这个目标函数与对比学习中思想类似,可以理解为:使得 更加接近布朗桥过程,而其他负样本三元组与布朗桥过程的差异变大(见图3中的示例)。其中,函数 用于度量编码器预测结果到布朗桥轨迹的距离:

2. 基于GPT微调解码器生成

用上述编码器得到隐空间中的布朗桥轨迹后,需要再使用一个解码器,以该轨迹为条件生成对应的文本。对于该解码器的训练,作者直接对GPT2进行微调。

在 inference 时,给定隐空间起点 与终点 ,只需随机采样一个两点之间的布朗桥过程,然后用上述解码器进行生成即可,如下图所示:

![]() 实验

实验![]()

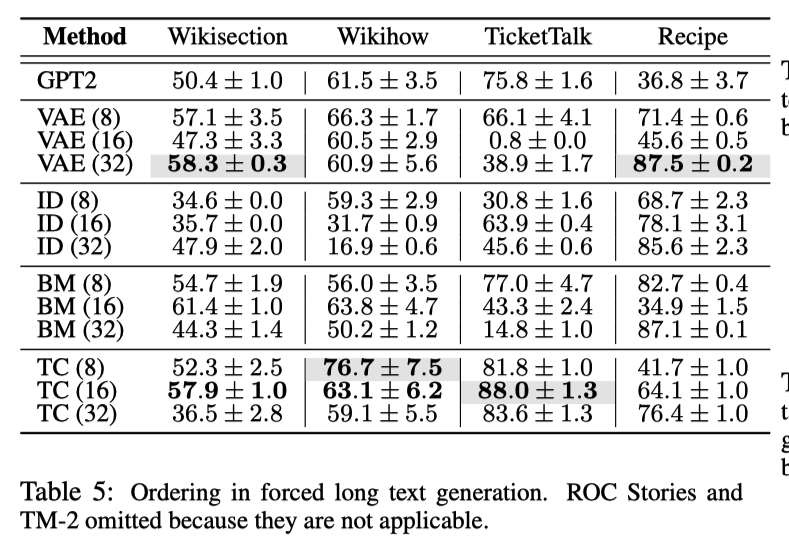

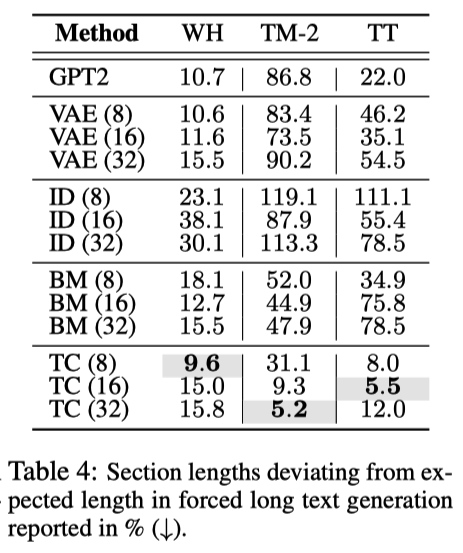

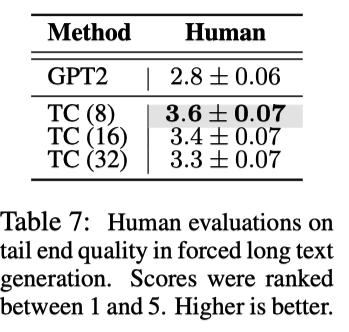

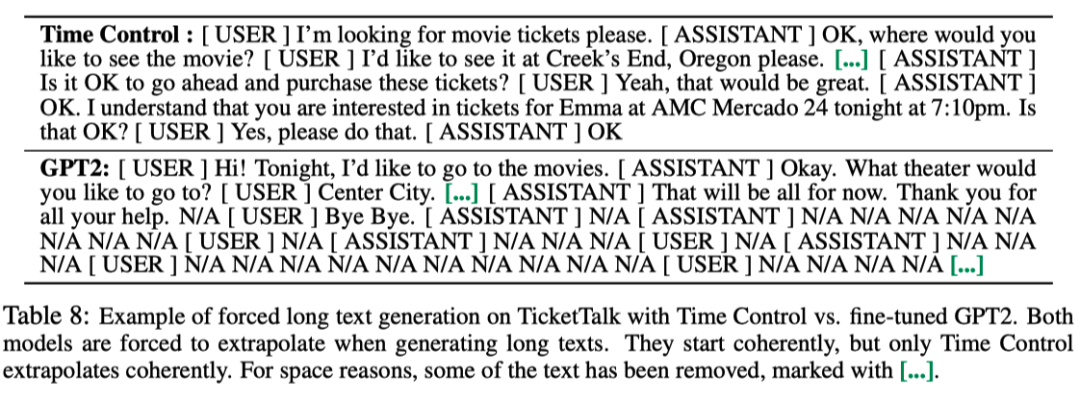

原文的实验部分非常充分,列举了TimeContorl在句子排序、文本填充等四个实验的结果:

(1)排序 模型维护文档结构的程度

(2)长度的一致性

(3)人工评价

![]() 总结与感想

总结与感想![]()

本文提出 Time Control 模型,将连贯的文本序列映射为平滑的布朗桥轨迹,以此来优化长文本生成的语言一致性。充分的实验结果也确实证明了其方法所带来的优化。在文章的末尾,作者提到:本文的思路亦可延伸至其他具有序列数据的领域,例如视频、音频等。

当读完这篇论文,笔者脑海里的浮现第一个词语是“浑然天成”。从大家在中学期间都学过的经典原理布朗运动入手到与生成任务的改进,可以说是完全意料之外的创新性结合,但是带来了巨大的改进。从抽象的想法,到施施然落地于任务,确实担得起8/8/8/8的评分。

其次,本文被许多拜读过的同学都誉为极具启发性的文章。无论是做序列数据的预测、去噪,还是对话系统、机器翻译的小伙伴,都认为该文的想法可能可以在自己所研究的领域有所借鉴。

另外,本文的想法依托于布朗运动、随机过程等经典的数学理论。作为人类探索世界收割的宝石,数学基础在当下全民炼丹的大环境下是否值得AI界研究者更多的瞩目?希望这篇文章对能各位带来不一样的视角和思考。欢迎大家在评论区探讨。

萌屋作者:付奶茶

新媒体交叉学科在读Phd,卖萌屋十级粉丝修炼上任小编,目前深耕多模态,希望可以和大家一起认真科研,快乐生活!

作品推荐

后台回复关键词【入群】

加入卖萌屋NLP、CV与搜推广与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

![]()

[1]Fan, Angela, Mike Lewis, and Yann Dauphin. "Strategies for Structuring Story Generation." ACL. 2019.

方法

方法

萌屋作者:付奶茶

萌屋作者:付奶茶 后台回复关键词【

后台回复关键词【