ICML 2022 | 基于有偏不对称对比学习的长尾分布外检测

Motivation

常用的 OOD Detection 策略有如下几种:

Softmax-based: 这类方法利用 pre-trained model 输出的最大 softmax 概率进行统计分析,统计发现 OOD 样本和 ID 样本 softmax 概率的分布情况,试图将二者的分布差距加大,然后选取合适的阈值来判断一个样本属于 OOD 还是 ID。这类方法简单且有效,不用修改分类模型的结构,也不需要训练一个 OOD 样本分类器。

Uncertainty: 由于模型的概率输出并不能直接表示模型的置信度(confidence)。因此这类方法让模型学习一个对输入样本的不确定性属性。面对测试数据,如果模型输入为 ID 样本,则不确定性低,相反,如果模型输入为 OOD 样本,则不确定性高。这类方法需要修改模型的网络结构来学习不确定性属性。

Generative Model: 这类方法主要利用 Variational Autoencoder 的 reconstruction error 或者其他度量方式来判断一个样本是否属于 ID 或 OOD 样本。主要的假设是,Autoencoder 的隐含空间(latent space) 能够学习出 ID 数据的明显特征(silent vector),而对于 OOD 样本则不行,因此OOD样本会产生较高的 reconstruction error. 这类方法只关注 OOD 检测性能,不关注 ID 数据本来的任务。

Classifier: 这类方法比较直接,使用分类器对提取的特征进行分类来判断是否为OOD样本。这类方法简单直接,也取得了不错的效果,有的方法修改网络结构为一个 n+1 类分类器,n 为原本分类任务的类别数,第 n+1 类则是 OOD 类;有的方法直接取提取特征来进行分类,不需要修改网络的结构。

该介绍来自:

https://zhuanlan.zhihu.com/p/102870562

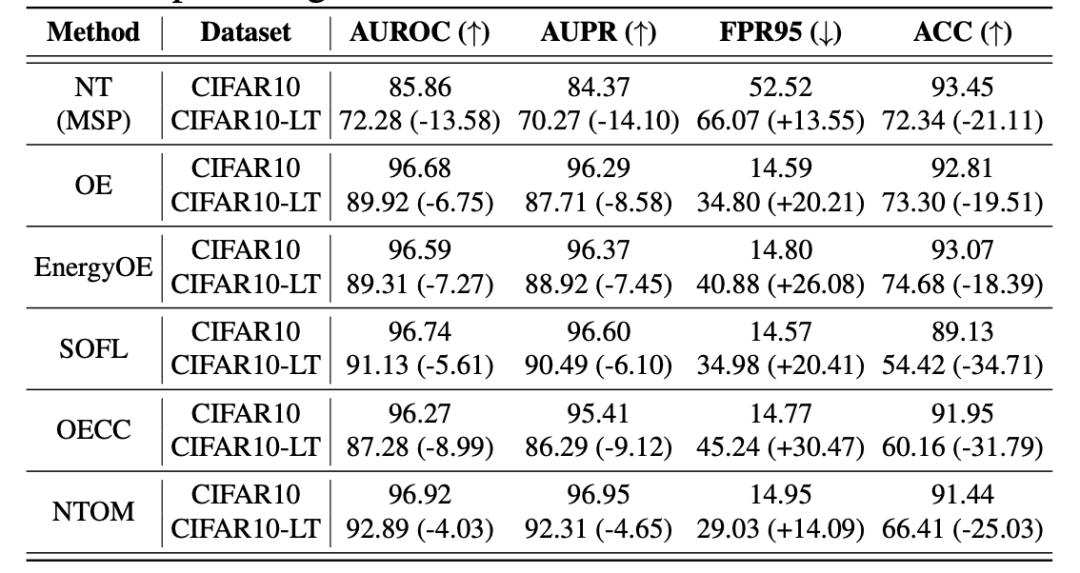

不仅如此,将 OOD Detection 方法与长尾分类方法的简单组合,取得的效果也不是特别理想:

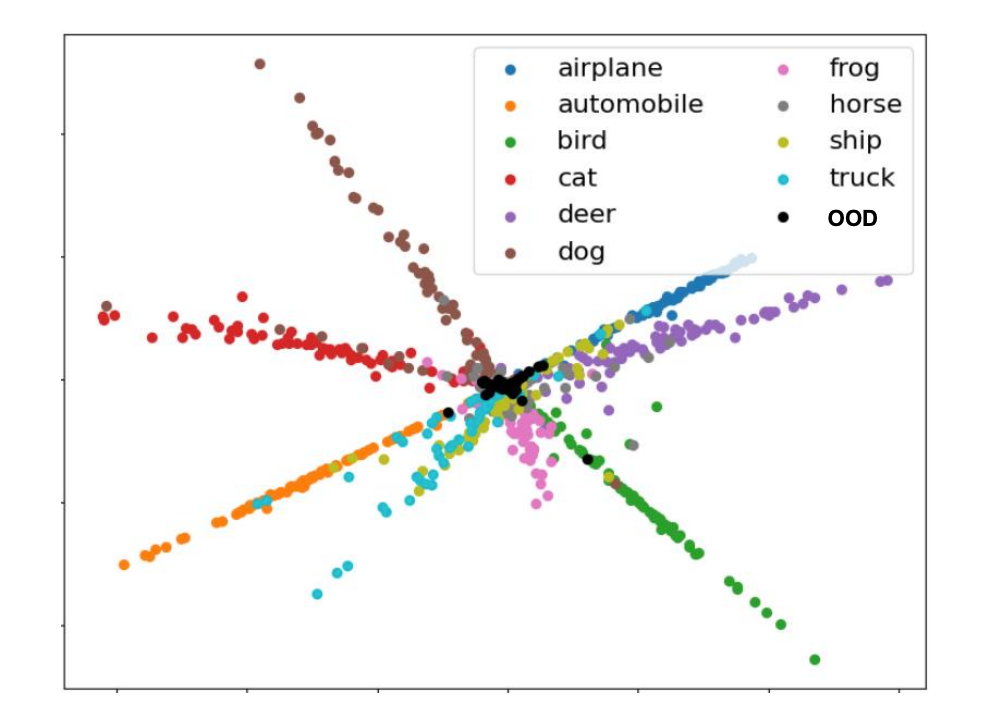

为了探究原因,作者对在长尾 ID 数据分布上的 OOD Detection 任务(OE)进行实验,使用 ResNet18 网络作为框架,提取网络的倒数第二个输出层特征,进行可视化:

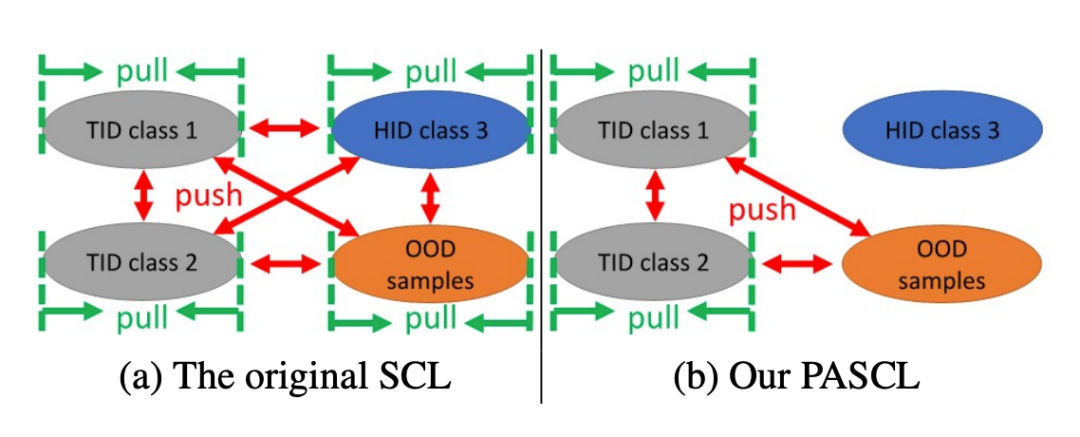

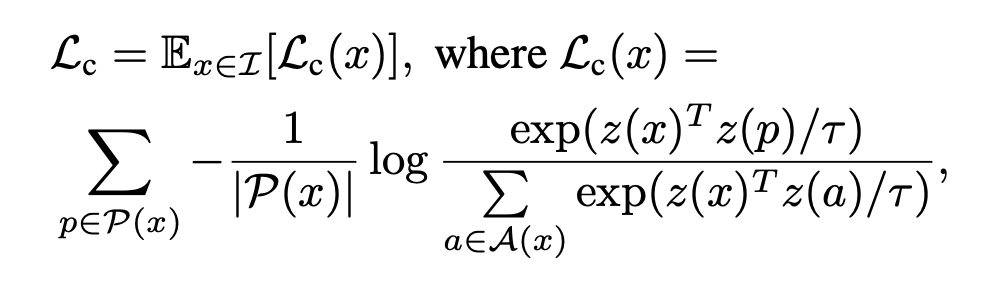

Contribution

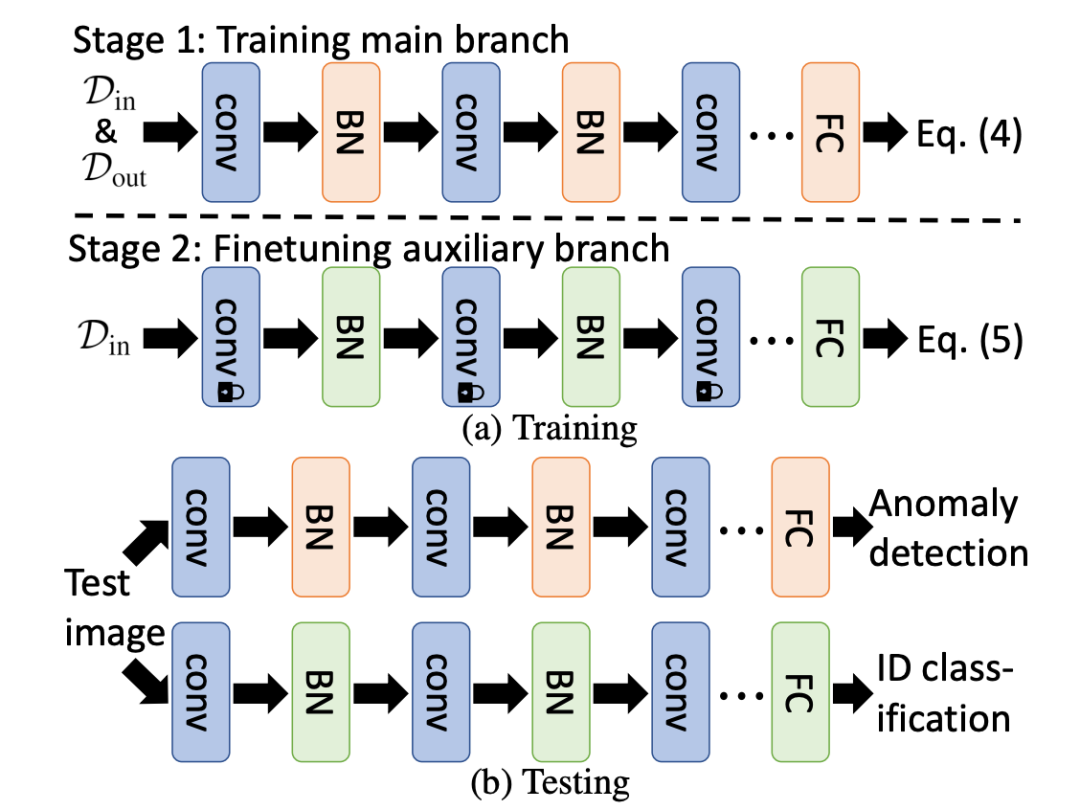

2. 提出网络结构微调策略 APF,对分类器的 BN 和预测层进行微调,提升 ID 分类和 OOD Detection 性能。

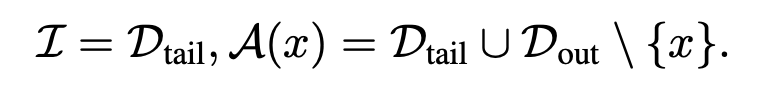

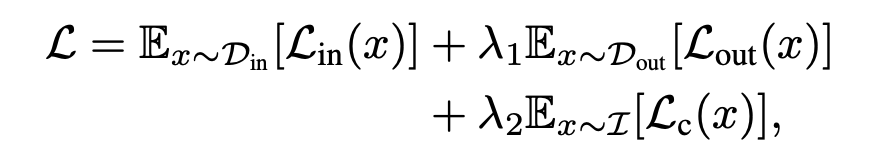

Approach

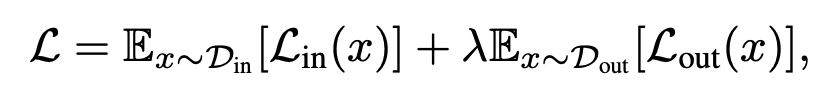

3.1 基于OE的OOD Detection方法

其中,为 ID 数据使用交叉熵损失进行类别预测:

BN:BN 的问题来自于其数据规范化过程本身,BN 在进行推断时,会使用所有 Batch 数据的均值和方差进行规范化,对于 OOD Detection 任务而言,意味着在推断时,使用了 ID 数据和 OOD 数据的混合信息,这对于 OOD 数据的推断是有利的,但是对于 ID 数据的分类而言是不利的,作者认为,BN 在进行 OOD Detection 时应该使用 ID 和 OOD 混合数据信息,而进行·ID 分类时应该只使用 ID 数据信息。

预测层:预测层通常是神经网络最后一个全连接层,目前有一些长尾分布的研究表明,预测层的参数对于长尾数据分类结果具有重要作用,作者认为在进行 ID 数据分类时,最好使用只在 ID 数据上进行训练的预测层。

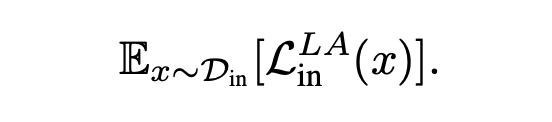

因此,作者首先使用前述损失函数训练一个深度神经网络,在训练完成后,将该网络记为网络 1,然后固定网络中除 BN 和预测层之外的所有网络参数,并以网络 1 的参数作为 BN 和预测层的初始化,使用 Google 在 2021 年所提出来的 LA 交叉熵损失。

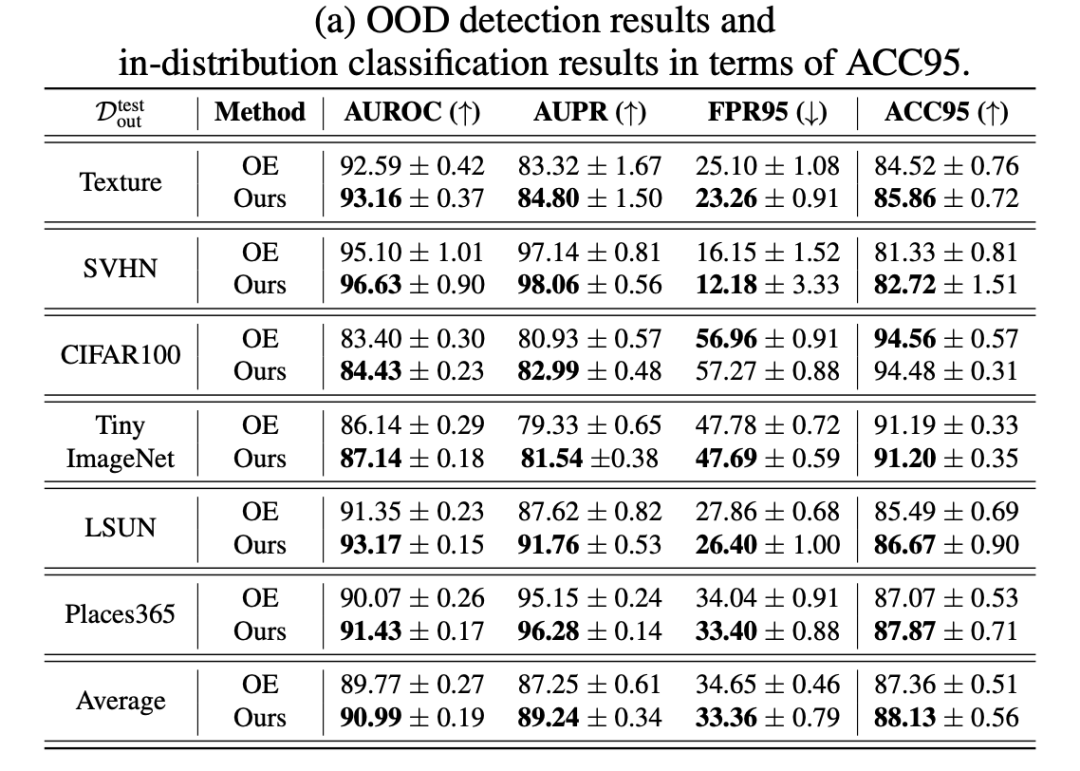

实验

4.1 数据集和网络框架

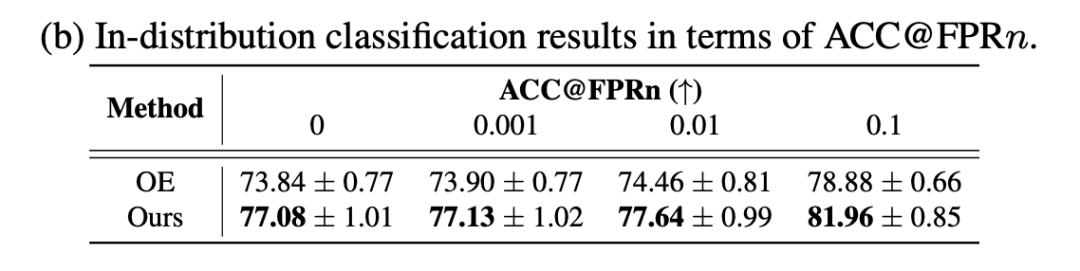

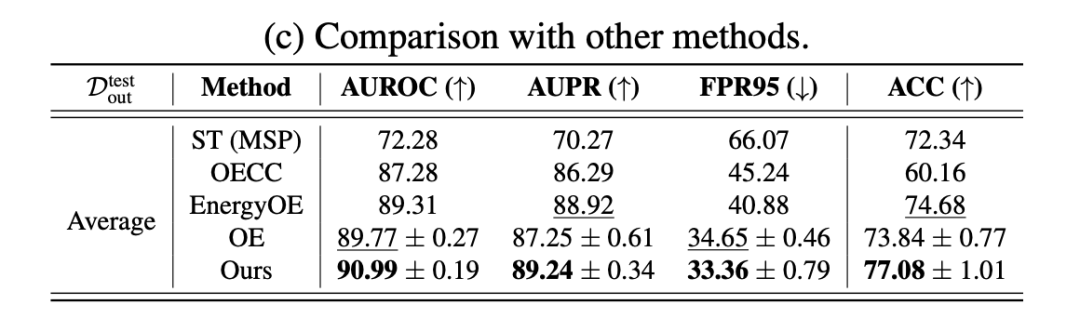

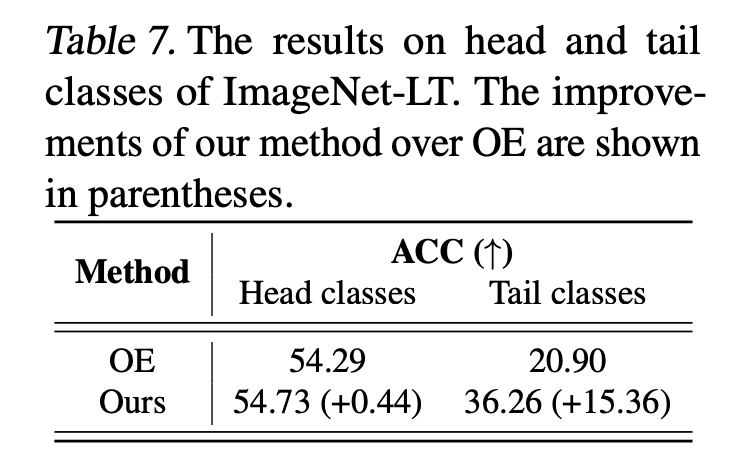

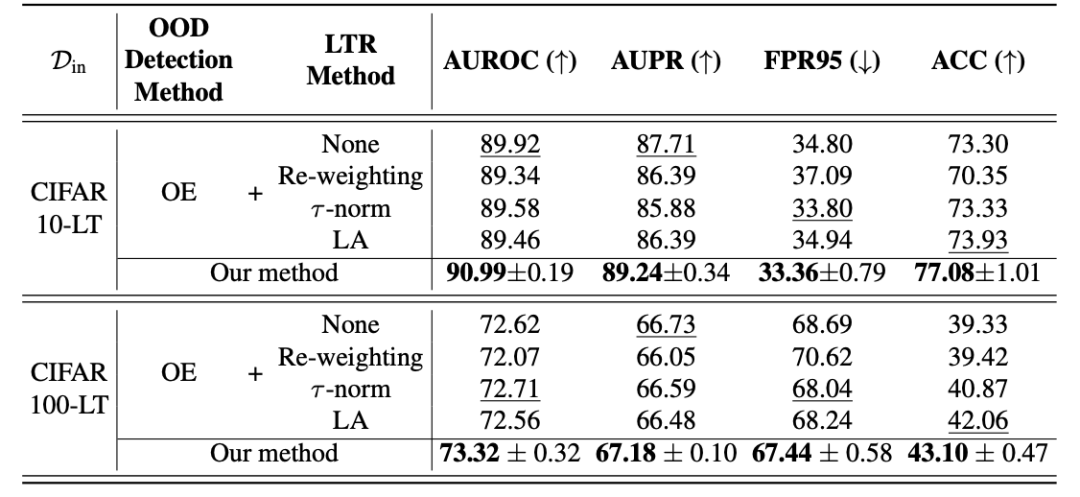

以及对比了他们的方法和其他一些方法的性能差异:

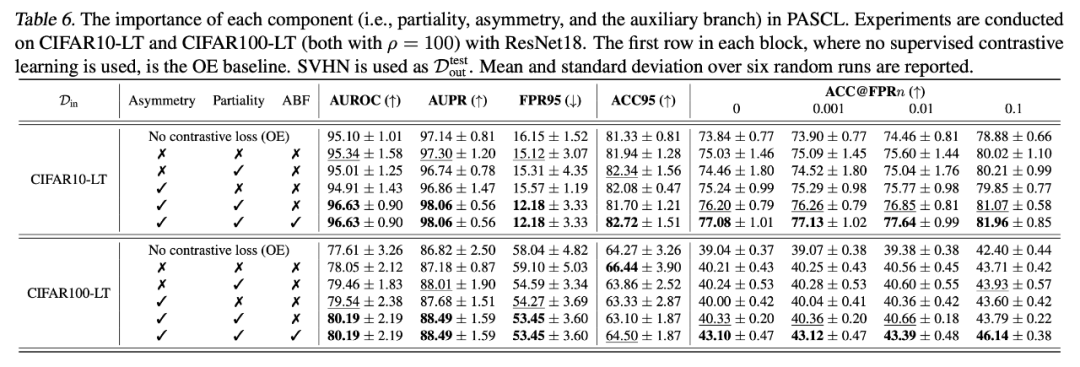

4.3.2 消融实验

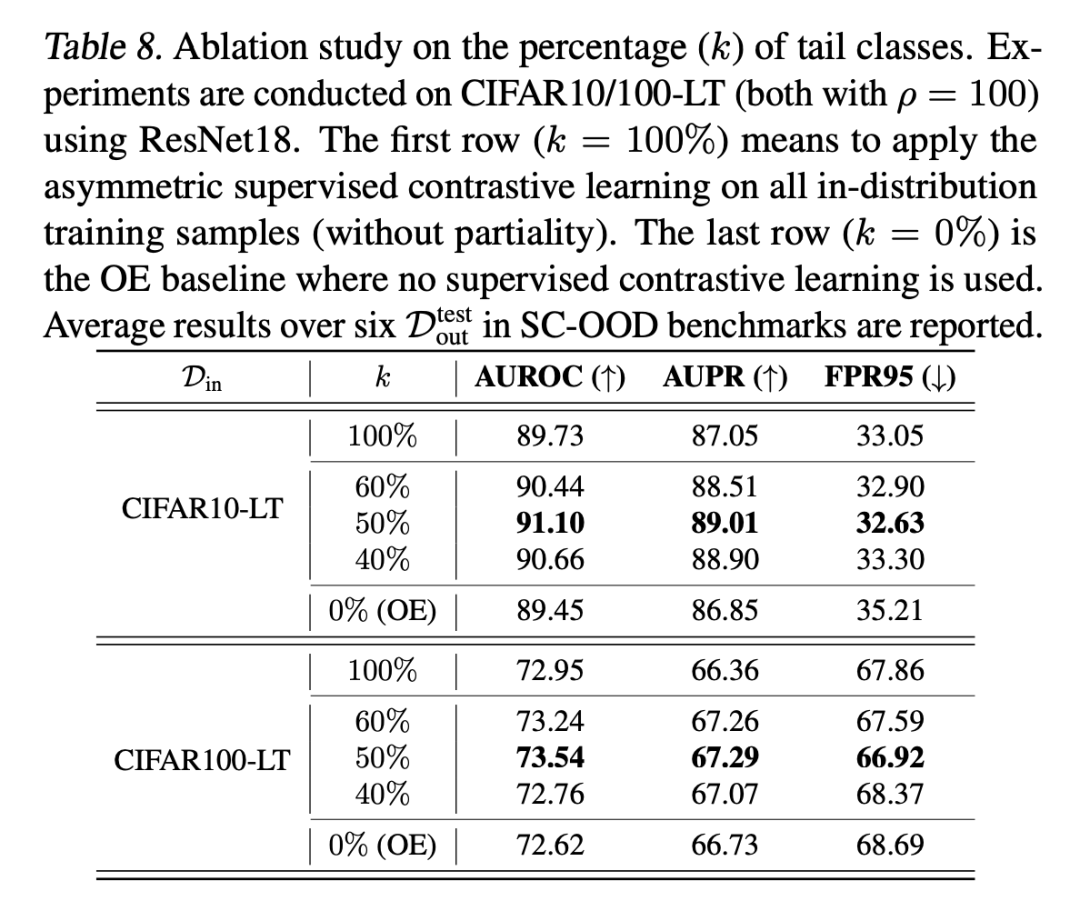

同时,作者研究了进行对比损失计算的尾部样本比例 k 对于模型性能的影响,发现他们的方法在 k 为 50% 时可以取得最好的效果,并且在较大区间内具有鲁棒性:

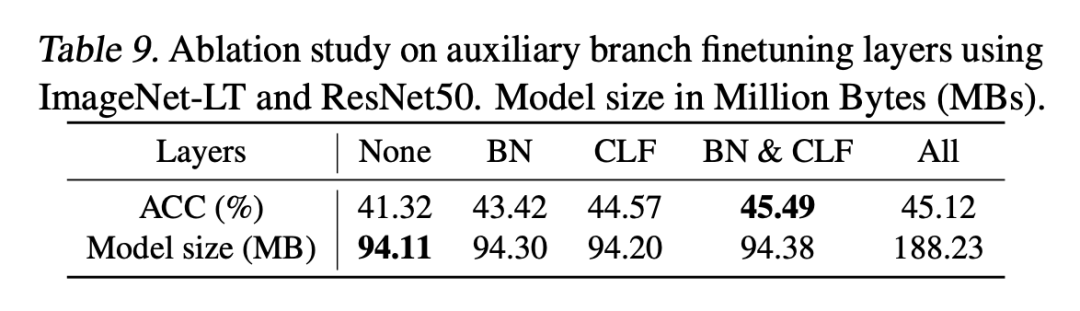

此外,作者对于微调策略进行了研究,结果显示,单独微调 BN 或分类层对于性能都有提升,并且微调二者的效果会比微调整个网络的效果更好:

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编