将隐式神经表示(INR)用于2D图像

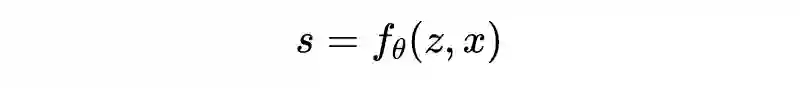

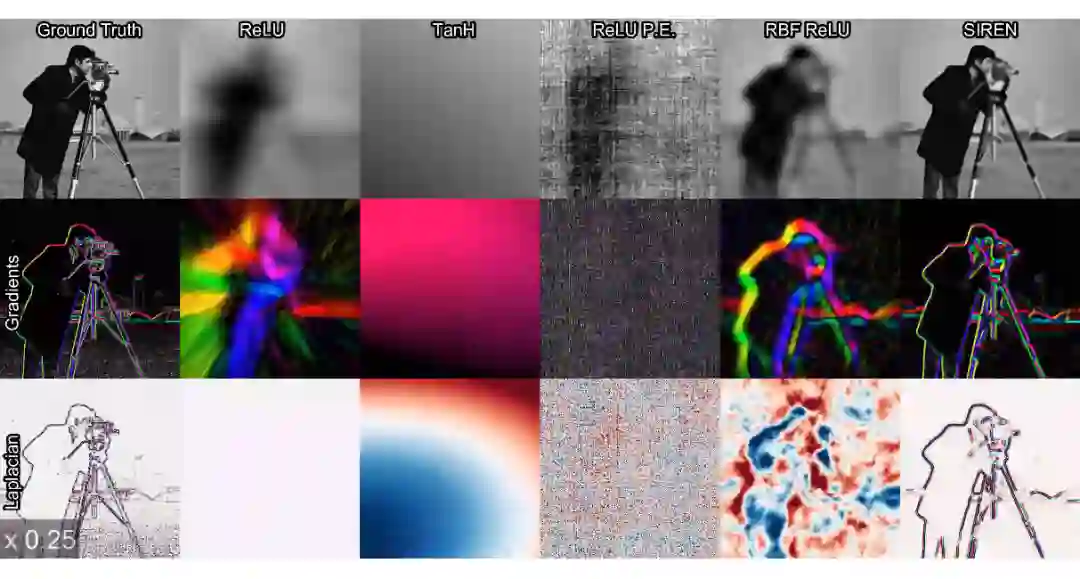

以图像为例,其最常见的表示方式为二维空间上的离散像素点。但是,在真实世界中,我们看到的世界可以认为是连续的,或者近似连续。于是,可以考虑使用一个连续函数来表示图像的真实状态,然而我们无从得知这个连续函数的准确形式,因此有人提出用神经网络来逼近这个连续函数,这种表示方法被称为“隐式神经表示“ (Implicit Neural Representation,INR)。

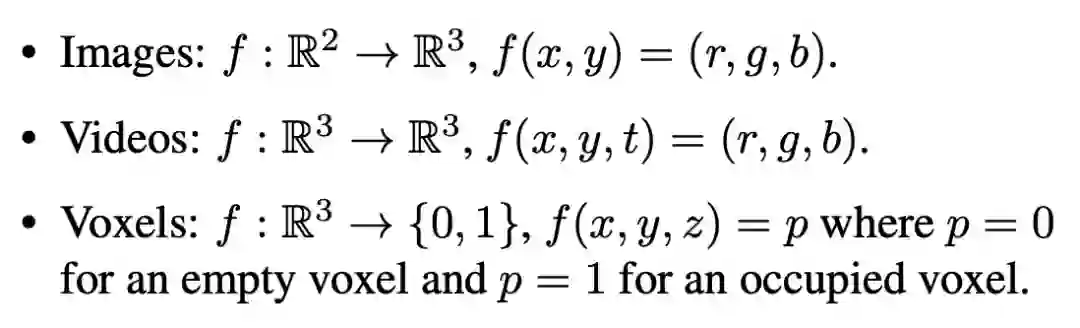

对于图像,INR 函数将二维坐标映射到 rgb 值。

对于视频,INR 函数将时刻 t 以及图像二维坐标 xy 映射到 rgb 值。对于一个三维形状,INR 函数将三维坐标 xyz 映射到 0 或 1,表示空间中的某一位置处于物体内部还是外部。当然还有其他形式,如 NERF 将 xyz 映射到 rgb 和 sigma。总而言之,这个函数就是将坐标映射到目标值。一旦该函数确定,那么一个图像/视频/体素就确定了。

论文标题:

Implicit Neural Representations with Periodic Activation Functions

https://arxiv.org/abs/2006.09661

NeurIPS 2020

https://vsitzmann.github.io/siren/

X-Fields

论文链接:

收录会议:

项目地址:

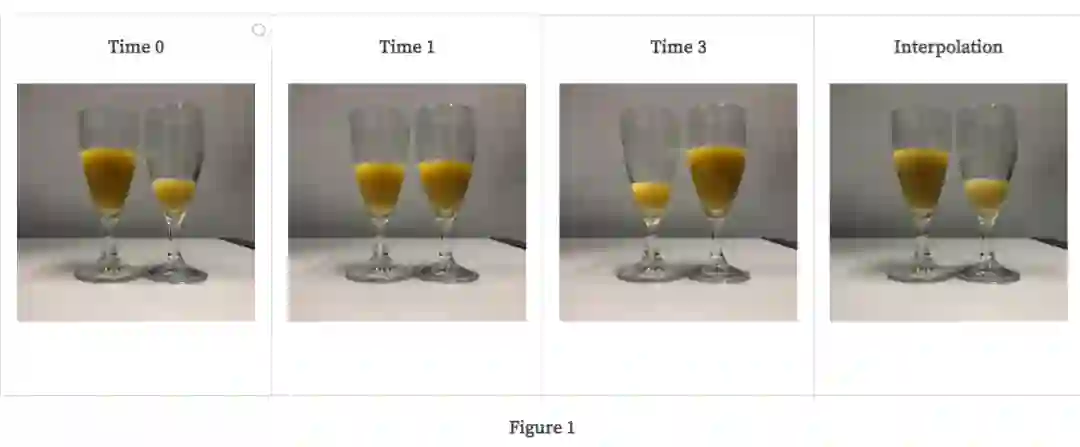

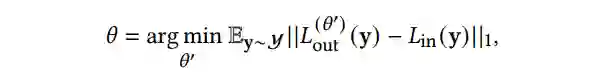

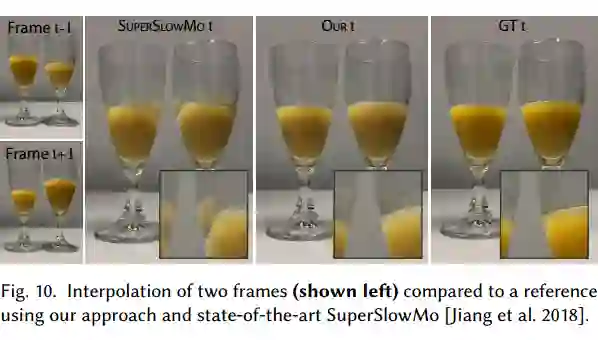

它提出了一种新颖的方法来对 2D 图像的时间、光线和视图进行无缝插值,即使用稀疏数据 X-field。这个 X-field 是通过学习一个神经网络来表征,将时间、光线或视图坐标映射到 2D 图像上。

传感器从不同的点(视频)、角度(光场)或在变化的照明(反射场)下捕获场景的图像。人们可以利用这种多样化的信息来改善 VR(虚拟现实)的体验。利用此信息,可以插入新视图、光线等,实现从一个场景到另一个场景的无缝过渡。但是,无缝插值需要密集采样,从而导致过多的存储、捕获和处理需求。稀疏采样是一种替代方法,但很明显,这需要在时间、光线和视野范围内进行精确插值。

Overview of the Proposed Method

Architecture Design

本文的网络架构也是一个创新点,主要通过四个步骤来实现:

-

分离阴影和反照率:阴影是指在 3D 模型(3D 计算机图形学领域)或插图(2D 计算机图形学范围)中,通过改变暗度来进行深度感知的描述。反照率是入射光从表面反射出去的比例。换句话说,它是物体的整体亮度。 -

插值图像是变形图像(即训练数据出现的图像)的加权组合。 -

使用神经网络表示“flow(流)”。 解决不连续问题。

LIIF

论文链接:

收录会议:

项目地址:

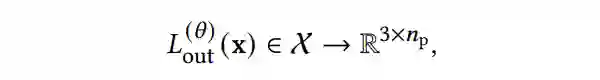

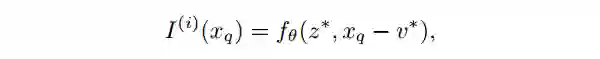

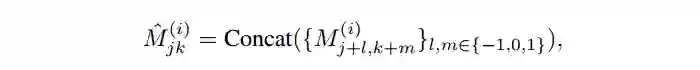

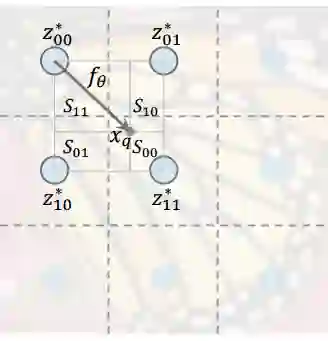

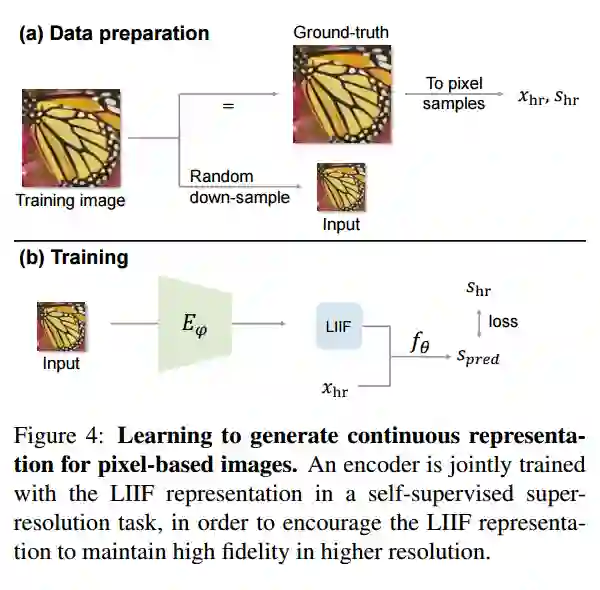

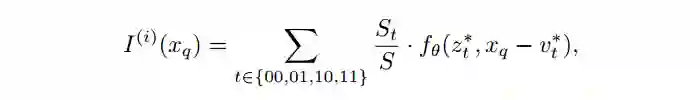

本次提出局部隐函数(Local Implicit Image Function,LIIF),以一个图像坐标和坐标周围的二维深度特征作为输入,预测给定坐标处的 RGB 值作为输出。由于坐标是连续的,所以 LIIF 可以呈现出任意分辨率。作者通过超分辨率的自监督任务来训练编码器和 LIIF 表示,以生成基于像素图像的连续表示。连续表示可以在任意分辨率下呈现,在没有提供训练任务的情况下,甚至可以放大到 ×30 更高的分辨率。

本文采用的是 encoder-decoder 架构,即使用一个 encoder 对所有的 object 预测 latent vectors,然后所有 object 共享一个 decoder,对于给定的坐标,根据坐标信息查询该坐标附近的局部 latent codes 作为函数输入,预测其 RGB 值。

网络很简单,先将数据预处理成高分辨率和低分辨率的图片,对低分辨率图片过一个 encoder,得到 feature map,然后输入高分辨率图像坐标(x,y)和低分辨率的 feature map,使用一个 MLP 预测高分辨率的 rgb 值。

特别鸣谢

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧