颠覆认知!数据增强、正则化可导致不易察觉的灾难?

文 | 子龙

编 | 智商掉了一地

作为常用的炼丹技巧,正则化 (Regularization) 和数据增强 (Data Augmentation, DA) 常常被简单粗暴地引入模型中来防止数据过拟合,进而提升最后的 performance。如果说,更高的performance就意味着更好的泛化能力,那么形式并不复杂的正则化和数据增强简直就是各大排名的屠榜利器、人工智能的指路明灯。然而,事情并不会这么简单,万事皆有代价,今天介绍的文章将会指出:虽然引入正则化和数据增强表面上能够提高模型的整体效果,但却会导致类别之间的不均衡问题。简单来说,就是虽然平均来看,整体效果有所提升,但其中却牺牲了部分类别的效果,而“偏心”于另外一些类别。

论文题目:

The Effects of Regularization and Data Augmentation are Class Dependent

论文链接:

https://arxiv.org/abs/2204.03632

Arxiv访问慢的小伙伴也可以在 【夕小瑶的卖萌屋】订阅号后台回复关键词 【0609】 下载论文PDF~

为了佐证这一结论,作者给出了数学上的严格证明,进而结合实验结果进一步分析,让我们一起来看看吧。

基本原理

文章首先将问题表述成如下形式:

训练数据:,假设 和 之间存在关系 ,即 ,那么我们模型的目的就是拟合函数 ,使得 和 尽可能的在训练数据上接近。数据增强(DA)可以一般化为,给定参数 , 会生成一个基于 的新样本加入训练。

根据上述定义,作者声称:如果DA中的参数 无法保证生成的新样本 和对应的原数据点 位于 的同一“水平集(level-set)”,同时模型能够最小化 training loss,那么就会在 上产生无法消除的偏差。

即:

其中第一项表示 生成的数据不在同一 level-set 上,第二项表示模型有能力最小化 loss。篇幅有限,具体证明过程可以参照论文,其中心思想是:如果 无法在同一 level-set 上生成数据,同时模型能够最小化 loss,模型习得的函数 与 就会有偏差,即 。

(level-set 指: ;即 )

于是,除非同时改变新数据 的标签 来消除 在 level-set 上产生的偏移,否则数据增强算法总会引入一定的偏差。若上述公式中第一项为 0,即不存在同一 level-set 上的偏差,这一性质被称为"label preserving",而这一性质依赖于特定的类别,即一部分类别偏差更小,label-perserving 的能力更强,当相同的数据增强的方法被运用于所有类别,自然而然,模型就会偏向于部分 label-preserving 更强的类别,进而产生类别间的不均衡。

具体实例

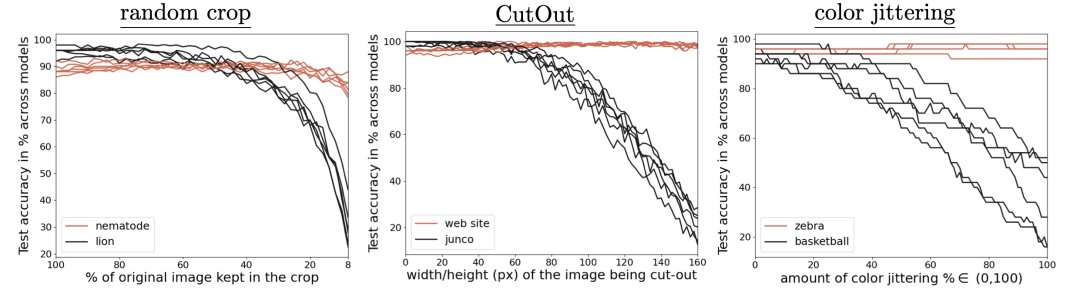

图中展示了运用不同数据增强的方法,对常见图片分类模型特定类别的分类效果,横轴是数据增强的程度,每种方法各不相同,但从整体趋势可以看出,对一些类别(红色)而言,尽管提高数据增强的比例,模型依旧能够学到足够的信息,但对另外一些类别(黑色),其结果下降明显。

根据之前的定义,红色所对应的类别 label preserving 的能力更强,黑色所对应的类别就相对较弱,这进一步佐证了作者在前文中的证明。

Weight Decay呢?

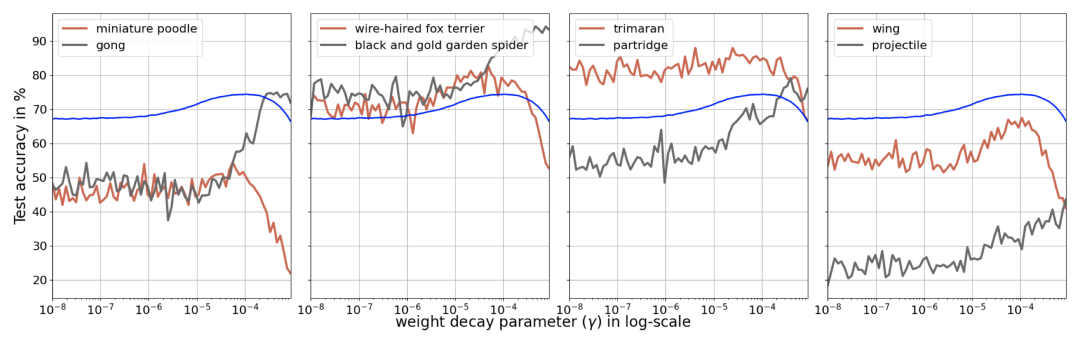

前文论述了 DA 会导致类别间的不均衡问题,那其他的正则方法呢?作者进一步给出了 Weight Decay 的实验结果。Weight Decay 是指在原本的损失函数上添加 ,也就是我们常说的 L2 正则。作者参照之前数据增强的实验,罗列了新的结果:

其中蓝色表示整体的平均分类准确率,红色和黑色表示对应的类别。与数据增强类似,虽然 Weight Decay 可以提升整体的平均分类效果,但是会导致类别间的不均衡。

小结

这篇文章主要讨论了一种常见的现象:引入正则或数据增强后导致类别间效果不均衡,并给出严格的证明和实验结果。无论是各种不同的数据增强结果,抑或是最为常见的正则方法 Weight Decay,即便往往使平均效果有所提升,但都会引入类别间的不均衡问题。可见,即使总体效果出色,也要关心一下各个类别更为具体的数据,否则就只是刷榜的机器学习,其泛化能力并不一定出色,也就不能完美地运用于具体的应用场景中。

萌屋作者:子龙(Ryan)

本科毕业于北大计算机系,曾混迹于商汤和MSRA,现在是宅在UCSD(Social Dead)的在读PhD,主要关注多模态中的NLP和data mining,也在探索更多有意思的Topic,原本只是贵公众号的吃瓜群众,被各种有意思的推送吸引就上了贼船,希望借此沾沾小屋的灵气,paper++,早日成为有猫的程序员!

作品推荐:

后台回复关键词【入群】

加入卖萌屋NLP、CV、搜推广与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

![]()

萌屋作者:子龙(Ryan)

萌屋作者:子龙(Ryan) 后台回复关键词【入群】

后台回复关键词【入群】