NeurIPS 2021 | 通过寻找平坦最小值,克服小样本增量学习中的灾难性遗忘

©作者 | FlyingBug

单位 | 哈尔滨工业大学(深圳)

研究方向 | 小样本学习

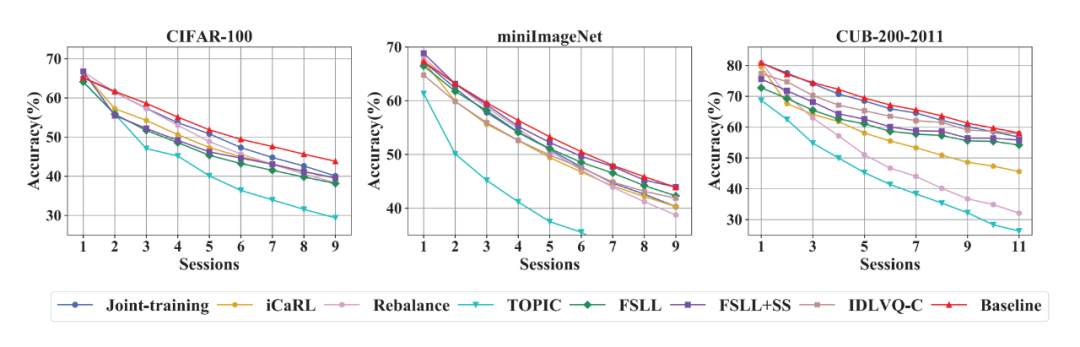

本文分享的这篇论文是 NeurIPS 2021的一篇 Few-Shot 增量学习 (FSCIL) 文章,这篇文章通过固定 backbone 和 prototype 得到一个简单的 baseline,发现这个 baseline 已经可以打败当前 IL 和 IFSL 的很多 SOTA 方法,基于此通过借鉴 robust optimize 的方法,提出了在 base training 训练时通过 flat local minima 来对后面的 session 进行 fine-tune novel classes,解决灾难性遗忘问题。

收录会议:

论文链接:

代码链接:

作者提出了一个简单的 baseline,模型只在 base classes 上进行训练,在后续的 session 上直接进行推理。

1.4 Method

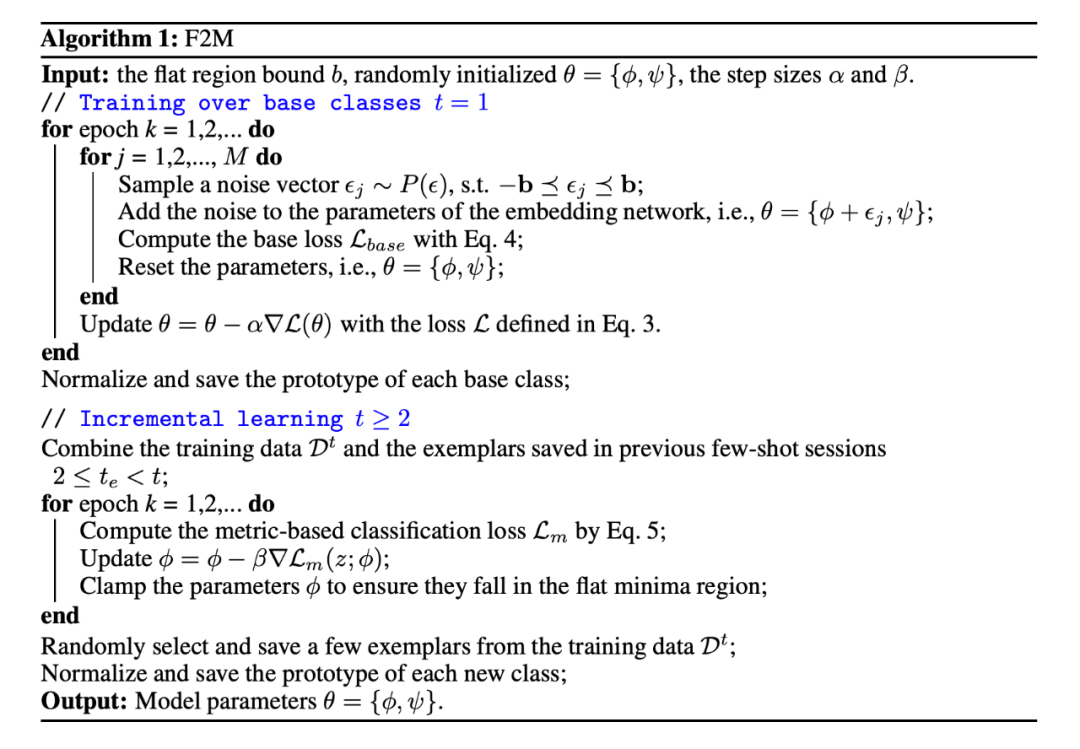

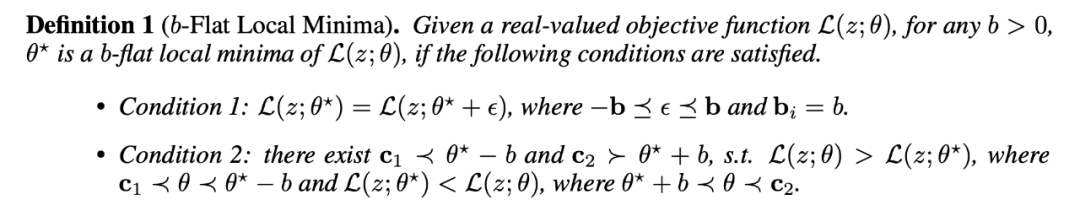

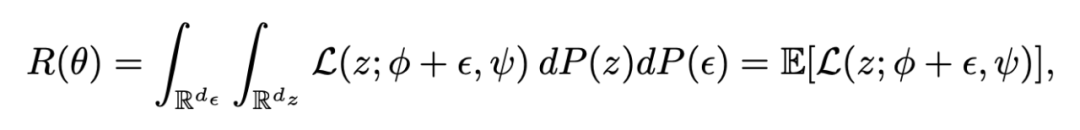

为了找到 base training function 的近似 flat local minima,作者提出添加一些随机噪声到模型参数,噪声可以被多次添加以获得相似但不同的 loss function,直觉上,flat local minima 附近的参数向量有小的函数值。

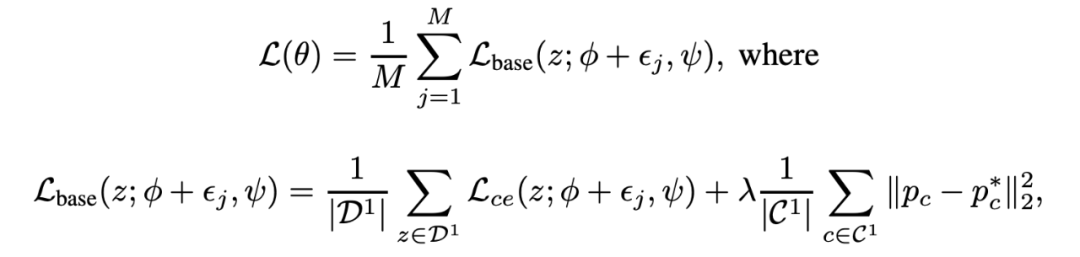

因此最小化期望损失是不可能的,所以这里我们最小化他的近似,empirical loss:

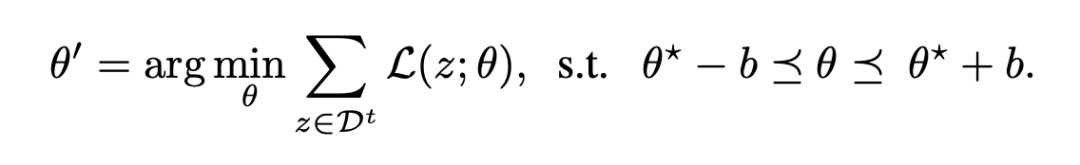

1.4.2 在Flat Region内进行IFSL

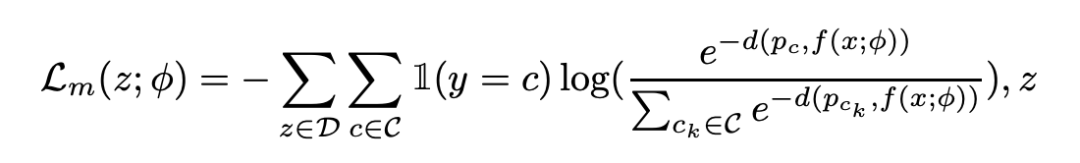

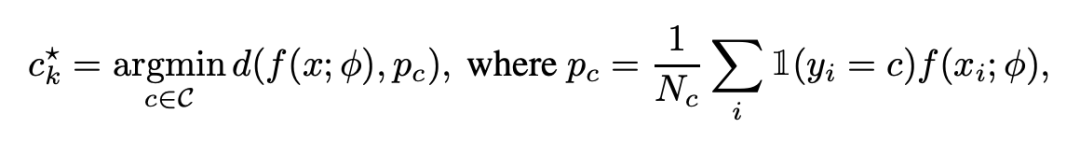

通过欧氏距离使用基于度量的分类算法来 fine-tune 模型参数。

1.4.3 收敛性分析

参考文献

[1] Shi G, Chen J, Zhang W, et al. Overcoming Catastrophic Forgetting in Incremental Few-Shot Learning by Finding Flat Minima[J]. Advances in Neural Information Processing Systems, 2021, 34.

[2] He H, Huang G, Yuan Y. Asymmetric valleys: Beyond sharp and flat local minima[J]. arXiv preprint arXiv:1902.00744, 2019.

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧