【AAAI2021】克服图神经网络灾难性遗忘,Overcoming Catastrophic Forgetting in GNN

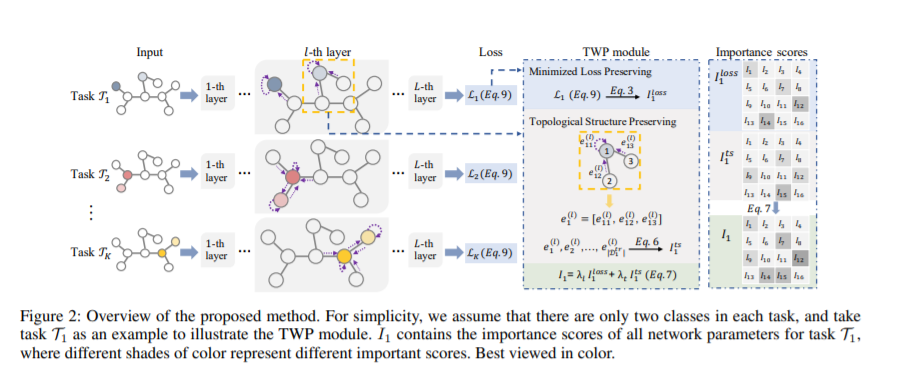

灾难性遗忘是指神经网络在学习新任务时“忘记”之前所学知识的倾向。以往的方法在克服这一问题上主要集中在卷积神经网络(CNNs),图像等输入样本位于一个网格域中,但在很大程度上忽略了处理非网格数据的图神经网络(GNNs)。在本文中,我们提出了一种新的方法来克服灾难性遗忘问题,从而加强网络中的持续学习。我们的方法的核心是一个通用模块,称为拓扑感知权值保持~(TWP),以即插即用的方式适用于任意形式的GNNs。主流的基于CNN的连续学习方法只依赖于减慢对下游任务很重要的参数的更新速度,而TWP不同于这种方法,它明确地探索了输入图的局部结构,并试图稳定在拓扑聚合中起关键作用的参数。我们在几个数据集上评估了TWP在不同GNN骨干上的性能,并证明了它产生的性能优于目前的技术状态。

https://www.zhuanzhi.ai/paper/1b14d3c79fd4da3b4cdbcaca97eed943

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CFGNN” 可以获取《【AAAI2021】克服图神经网络灾难性遗忘,Overcoming Catastrophic Forgetting in GNN》专知下载链接索引

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年5月3日

Arxiv

16+阅读 · 2020年3月30日

Arxiv

8+阅读 · 2019年5月20日